Eleven v3 Audio Tags: Situatives Bewusstsein für KI-Audio

Verbessern Sie KI-Sprache mit Eleven v3 Audio Tags. Steuern Sie Ton, Emotion und Tempo für natürliche Gespräche. Fügen Sie Ihrem Text-to-Speech situatives Bewusstsein hinzu.

Die Audio-Tags von ElevenLabs steuern Emotion, Tempo und Soundeffekte der KI-Stimme.

Mit der Einführung von Eleven v3 ist Audio-Prompting zu einer wichtigen Fähigkeit geworden. Anstatt nur Text einzugeben oder einzufügen, können Sie jetzt eine neue Funktion nutzen – Audio-Tags – um alles von Emotion bis Vortrag gezielt zu steuern.

Eleven v3 ist eine Alpha-Version Forschungsvorschau des neuen Modells. Es erfordert mehr Prompt Engineering als frühere Modelle – aber die Ergebnisse sind beeindruckend.

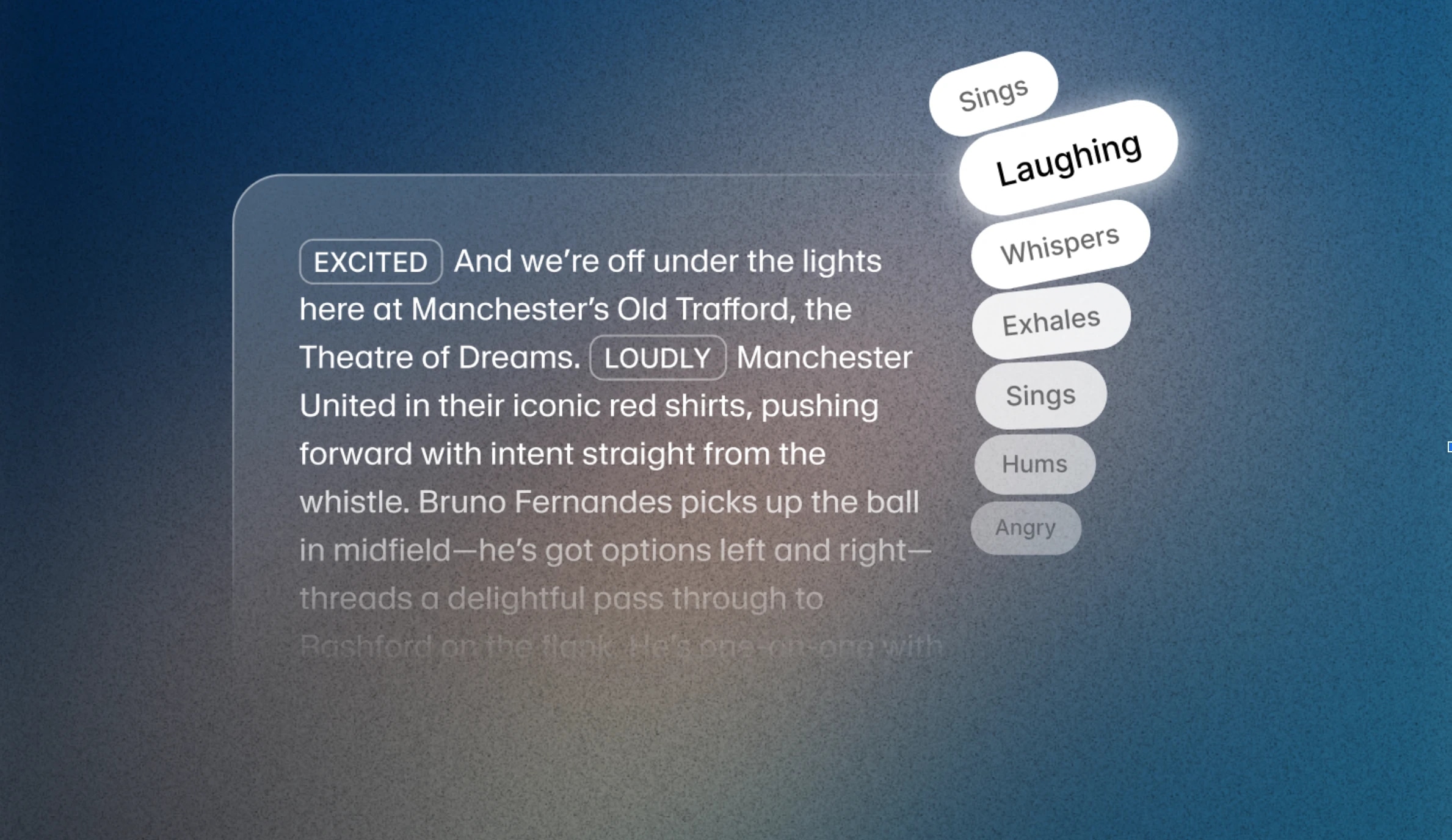

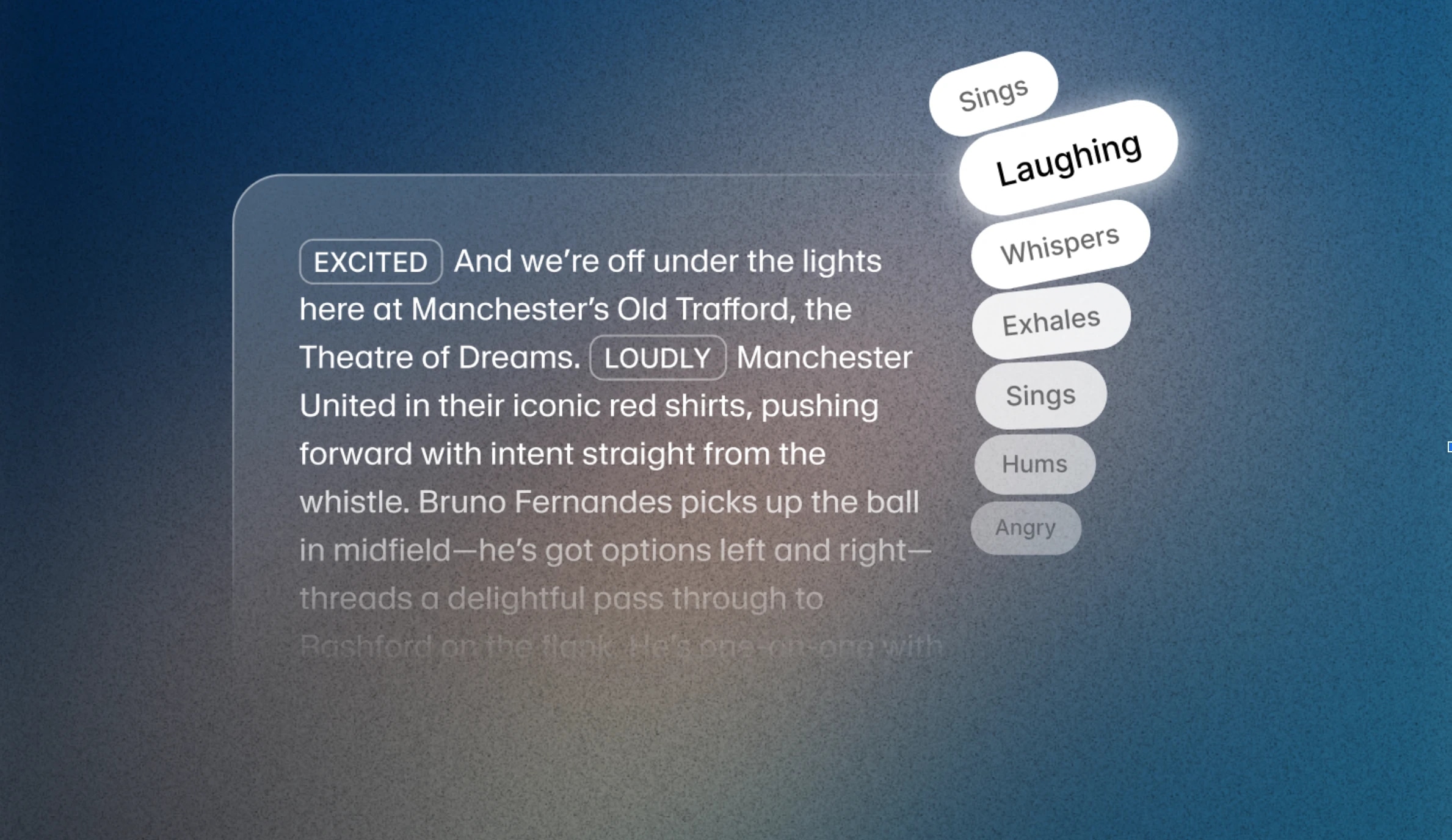

ElevenLabs Audio-Tags sind Wörter in eckigen Klammern, die das neue Eleven v3 Modell interpretieren und zur Steuerung der Audioausgabe nutzen kann. Beispiele sind [excited], [whispers], [sighs] bis hin zu [gunshot], [clapping] und [explosion].

Mit Audio-Tags gestalten Sie, wie KI-Stimmen klingen – inklusive nonverbaler Hinweise wie Tonfall, Pausen und Tempo. Ob für Hörbücher, interaktive Charaktere oder dialogbasierte Medien: Diese einfachen Tools auf Skriptebene geben Ihnen präzise Kontrolle über Emotion und Vortrag.

Sie können Audio-Tags überall im Skript platzieren, um die Ausgabe in Echtzeit zu beeinflussen. Auch Kombinationen innerhalb eines Skripts oder Satzes sind möglich. Die Tags lassen sich in Hauptkategorien einteilen:

Diese Tags helfen, die emotionale Stimmung der Stimme zu setzen – ob ernst, intensiv oder fröhlich. Zum Beispiel mit [sad], [angry], [happily] oder [sorrowful], einzeln oder kombiniert.

Hier geht es um Ton und Vortrag. Mit diesen Tags passen Sie Lautstärke und Energie an – für Szenen, die Zurückhaltung oder Kraft erfordern. Beispiele: [whispers], [shouts] oder auch [x accent].

Natürliche Sprache enthält Reaktionen. So können Sie Realismus schaffen, indem Sie spontane Momente einbauen – etwa [laughs], [clears throat] oder [sighs].

Die neue Architektur von v3 bildet die Grundlage für diese Funktionen. Das Modell versteht Textkontext tiefer und kann emotionale Hinweise, Tonwechsel und Sprecherwechsel natürlicher umsetzen. Zusammen mit Audio-Tags ermöglicht das mehr Ausdrucksstärke als bisher bei Text zu Sprache.

Sie können jetzt auch Dialoge mit mehreren Sprechern erstellen, die spontan wirken – inklusive Unterbrechungen, Stimmungswechseln und Gesprächsnuancen mit minimalem Prompting.

Professionelle Voice Clones (PVCs) sind derzeit noch nicht vollständig für Eleven v3 optimiert, was zu geringerer Klonqualität im Vergleich zu früheren Modellen führen kann. Während dieser Forschungsvorschau empfiehlt es sich, für v3-Funktionen einen Instant Voice Clone (IVC) oder eine Design-Stimme zu wählen. Die PVC-Optimierung für v3 folgt in Kürze.

Eleven v3 ist in der ElevenLabs-Oberfläche verfügbar, und wir bieten 80 % Rabatt bis Ende Juni an. Die öffentliche API für Eleven v3 (Alpha) ist ebenfalls verfügbar. Egal ob Sie experimentieren oder im großen Maßstab einsetzen – jetzt ist der richtige Zeitpunkt, die Möglichkeiten zu erkunden.

KI-Sprache zu erzeugen, die performt – und nicht nur vorliest – gelingt mit dem gezielten Einsatz von Audio-Tags. Wir haben sieben kompakte, praxisnahe Anleitungen erstellt, die zeigen, wie Tags wie [FLÜSTERT], [LACHT LEISE] oder [französischer Akzent] Kontext, Emotion, Tempo und sogar Dialoge mit mehreren Charakteren mit nur einem Modell steuern.

[FLÜSTERT], [RUFT] und [SEUFZT] lassen Eleven v3 auf den Moment reagieren – Spannung aufbauen, Warnungen abschwächen oder für Dramatik pausieren.[Piratenstimme] bis [französischer Akzent] wird aus Erzählung Rollenspiel. Wechseln Sie mitten im Satz die Rolle und steuern Sie Charakter-Performances, ohne das Modell zu wechseln.[seufzt], [begeistert] oder [müde] steuern die Stimmung im Moment – Spannung, Erleichterung oder Humor, ganz ohne Nachbearbeitung.[Pause], [staunend] oder [dramatischer Ton] steuern Rhythmus und Betonung, damit KI-Stimmen den Zuhörer durch jede Szene führen.[unterbricht], [überlappend] oder Tonwechseln. Ein Modell, viele Stimmen – natürliche Gespräche in einem Durchgang.[Pause], [eilig] oder [gedehnt] geben Ihnen Kontrolle über das Tempo und machen aus einfachem Text eine Performance.[amerikanischer Akzent], [britischer Akzent], [südamerikanischer Akzent] und mehr – für kulturell vielfältige Sprache ohne Modellwechsel.

Verbessern Sie KI-Sprache mit Eleven v3 Audio Tags. Steuern Sie Ton, Emotion und Tempo für natürliche Gespräche. Fügen Sie Ihrem Text-to-Speech situatives Bewusstsein hinzu.