Einführung in Conversational AI

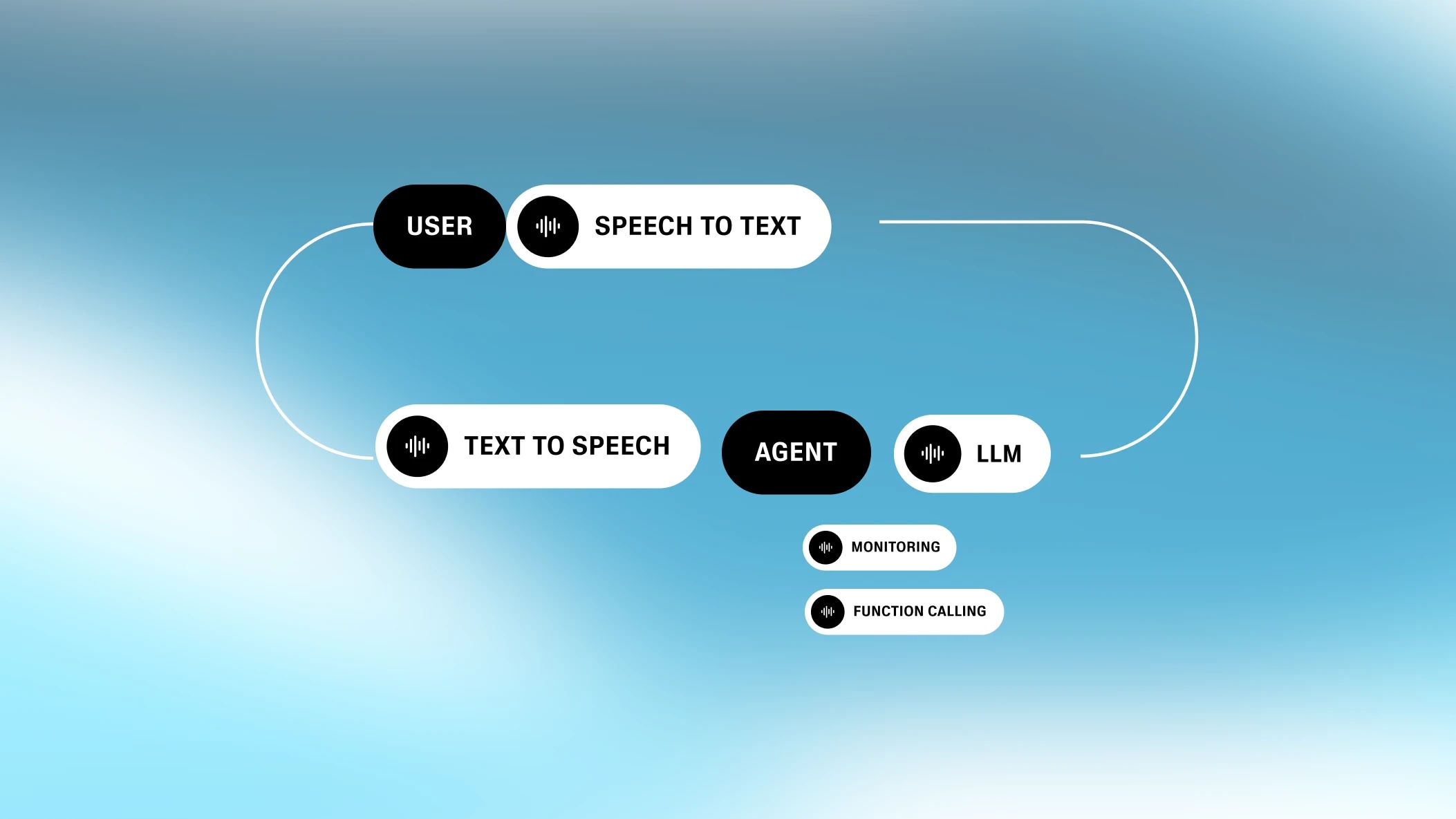

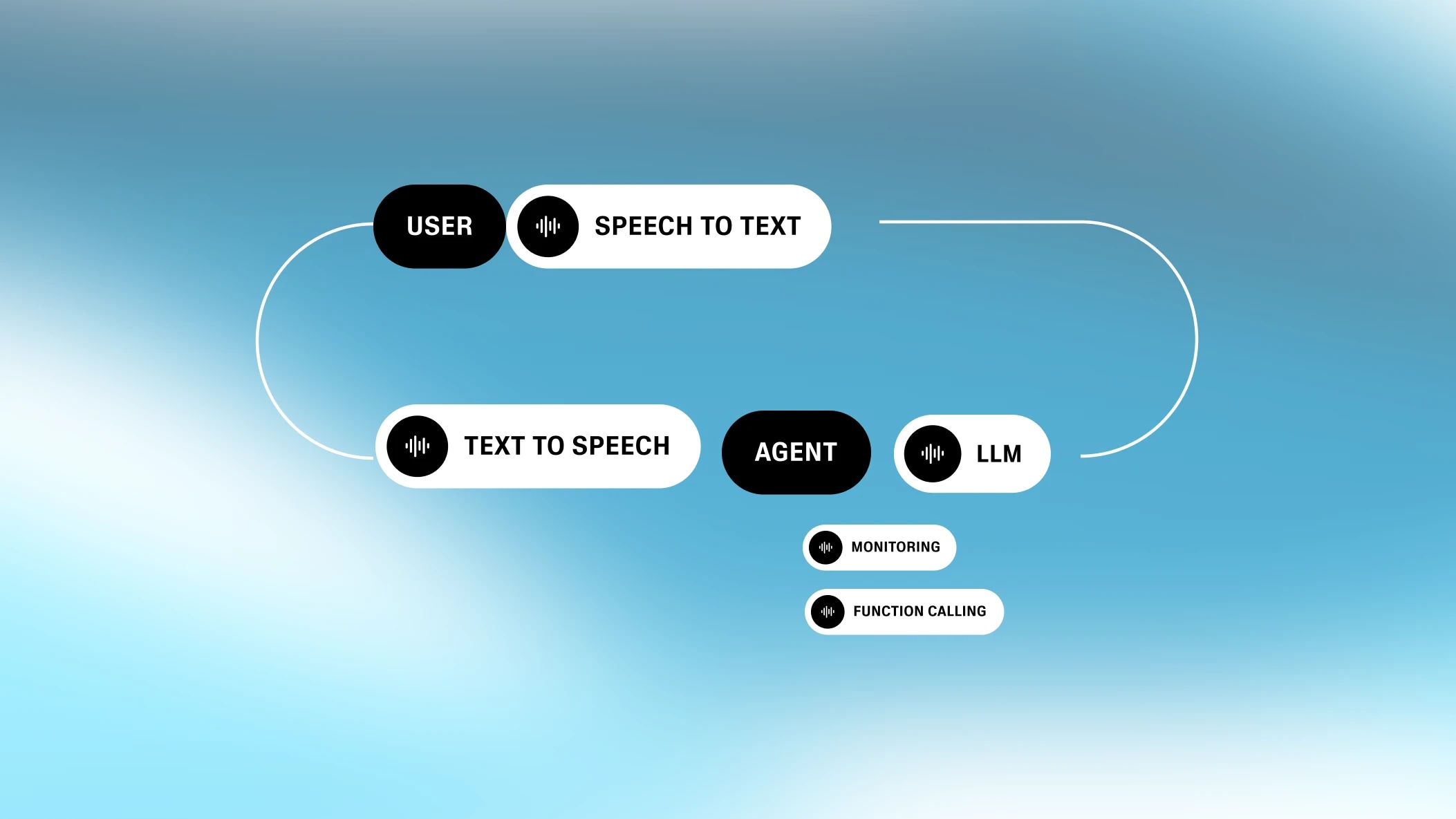

Unsere All-in-One-Plattform zum Erstellen anpassbarer, interaktiver Sprachagenten

Erfolgreiche Lösung von >80% der Benutzeranfragen

Bei ElevenLabs haben wir kürzlich einen Konversations-KI-Sprachagenten in unsere Dokumentation eingebettet, um die Supportbelastung bei dokumentationsbezogenen Fragen zu reduzieren (Testen Sie es über 80%). Unser Support-Agent bearbeitet nun erfolgreich über 80% der Benutzeranfragen bei

Wir wollten einen Agenten entwickeln, der:

Wir haben zwei Bewertungsebenen implementiert:

(1) KI-Bewertungstool: Für jeden Anruf läuft unser integriertes Bewertungstool durch das abgeschlossene Gespräch und bewertet, ob der Agent erfolgreich war. Die Kriterien sind vollständig anpassbar. Wir fragen, ob der Agent die Benutzeranfrage gelöst hat oder sie zu einem relevanten Supportkanal weiterleiten konnte.

Wir konnten die Fähigkeit des LLM stetig verbessern, die Anfrage erfolgreich zu lösen oder weiterzuleiten, und erreichten 80% gemäß unserem Bewertungstool.

Ausgenommen sind Anrufe mit weniger als einer Gesprächsrunde, was darauf hindeutet, dass keine Frage/kein Problem vom Anrufer aufgeworfen wurde.

Es ist wichtig zu beachten, dass nicht alle Arten von Supportanfragen oder Fragen von einem LLM gelöst werden können, insbesondere für ein Startup, das schnell baut und ständig innoviert, und mit extrem technischen und kreativen Benutzern. Als zusätzlicher Hinweis wird ein Bewertungs-LLM nicht 100% der Zeit korrekt bewerten.

(2) Menschliche Validierung: Um die Wirksamkeit unseres LLM-Validierungstools zu kontrastieren, führten wir eine menschliche Validierung von 150 Gesprächen durch, wobei wir die gleichen Bewertungskriterien verwendeten, die dem LLM-Tooling zur Verfügung gestellt wurden:

Die menschliche Bewertung ergab auch, dass 89% der relevanten Supportfragen korrekt vom Dokumentationsagenten beantwortet oder weitergeleitet wurden.

Weitere Erkenntnisse:

Der LLM-gesteuerte Agent ist geschickt darin, klare und spezifische Fragen zu lösen, die mit unserer Dokumentation beantwortet werden können, Anrufer auf die relevante Dokumentation hinzuweisen und erste Anleitungen zu komplexeren Anfragen zu geben. In den meisten dieser Fälle liefert der Agent schnelle, unkomplizierte und korrekte Antworten, die sofort hilfreich sind.

Fragen umfassen:

Empfehlungen:

Auf der anderen Seite ist der Agent weniger hilfreich bei Kontoproblemen, Preis-/Rabattanfragen oder unspezifischen Fragen, die von einer tieferen Untersuchung/Abfrage profitieren würden. Auch Probleme, die ziemlich vage und allgemein sind -> trotz Aufforderung, Fragen zu stellen, neigt das LLM dazu, mit etwas zu antworten, das aus der Dokumentation relevant erscheinen könnte.

Fragen umfassen:

Empfehlungen

„Sie sind ein technischer Support-Agent namens Alexis. Sie werden versuchen, alle Fragen zu beantworten, die der Benutzer zu ElevenLabs-Produkten haben könnte. Ihnen wird Dokumentation zu ElevenLabs-Produkten zur Verfügung gestellt und Sie sollten nur diese Informationen verwenden, um Fragen zu ElevenLabs zu beantworten. Sie sollten hilfsbereit, freundlich und professionell sein. Wenn Sie die Frage nicht beantworten können, leiten Sie Anrufer mit redirectToEmailSupport weiter (was eine E-Mail auf ihrer Seite an den Support öffnet), wenn das nicht zu funktionieren scheint, können sie direkt an team@elevenlabs.io mailen.

Wenn die Frage oder das Problem nicht vollständig klar oder spezifisch genug ist, fragen Sie nach weiteren Details und für welches Produkt sie Unterstützung anfordern. Wenn die Frage vage oder sehr allgemein ist, fragen Sie sie genauer, was sie erreichen wollen und wie.

Halten Sie sich strikt an die Sprache Ihrer ersten Nachricht im Gespräch, auch wenn Sie in einer anderen Sprache gefragt oder angesprochen werden. Sagen Sie, dass es besser ist, wenn sie den Anruf beenden und neu starten, um die gewünschte alternative Sprache auszuwählen.

Ihre Ausgabe wird von einem Text-to-Speech-Modell gelesen, daher sollte sie so formatiert sein, wie sie ausgesprochen wird. Zum Beispiel: anstatt "bitte kontaktieren Sie team@elevenlabs.io" auszugeben, sollten Sie "bitte kontaktieren Sie 'team at elevenlabs dot I O'" ausgeben. Formatieren Sie Ihre Textantwort nicht mit Aufzählungspunkten, Fettdruck oder Überschriften. Geben Sie keine langen Listen zurück, sondern fassen Sie sie zusammen und fragen Sie, an welchem Teil der Benutzer interessiert ist. Geben Sie keine Codebeispiele zurück, sondern schlagen Sie vor, dass der Benutzer die Codebeispiele in unserer Dokumentation ansieht. Geben Sie die Antwort direkt zurück, beginnen Sie nicht mit "Agent:" oder ähnlichem. Korrigieren Sie keine Rechtschreibfehler, ignorieren Sie sie einfach.

Antworten Sie prägnant in ein paar Sätzen und lassen Sie den Benutzer entscheiden, wo Sie mehr Details geben sollen.

Sie haben die folgenden Tools zur Verfügung. Verwenden Sie sie je nach Anfrage des Benutzers:

`redirectToDocs`:

- Wann zu verwenden: In den meisten Situationen, insbesondere wenn der Benutzer detailliertere Informationen oder Anleitungen benötigt.

- Warum: Der direkte Zugang zur Dokumentation ist hilfreich für komplexe Themen, um sicherzustellen, dass der Benutzer den Inhalt selbst überprüfen und verstehen kann.

`redirectToEmailSupport`:

- Wann zu verwenden: Wenn der Benutzer Unterstützung bei persönlichen oder kontospezifischen Problemen benötigt.

- Warum: Kontobezogene Anfragen werden am besten von unserem Support-Team per E-Mail bearbeitet, wo sie sicher auf relevante Details zugreifen können.

`redirectToExternalURL`:

- Wann zu verwenden: Wenn der Benutzer nach Unternehmenslösungen fragt oder externen Communities wie unserem Discord-Server beitreten möchte. Auch wenn sie ein Entwickler zu sein scheinen, der technische Schwierigkeiten mit ElevenLabs hat.

- Warum: Unternehmensanfragen und Community-Interaktionen fallen außerhalb des direkten In-Plattform-Supports und werden besser über externe Links behandelt.

Leitplanken:

- Halten Sie sich an ElevenLabs-bezogene Themen und Produkte. Wenn jemand nach nicht-ElevenLabs-Themen fragt, sagen Sie, dass Sie nur hier sind, um Fragen zu ElevenLabs-Produkten zu beantworten.

- Leiten Sie den Anrufer nur zu einer Seite gleichzeitig weiter, da jede Weiterleitung die vorherige überschreibt.

- Antworten Sie nicht in langen Listen oder mit Code. Leiten Sie stattdessen zur Dokumentation für Codebeispiele weiter.“

Neben dem Prompt geben wir dem LLM eine Wissensdatenbank mit relevanten Informationen im Kontext. Diese Wissensdatenbank enthält eine zusammengefasste, aber dennoch große (80k Zeichen) Version aller ElevenLabs-Dokumentationen sowie einige relevante URLs.

Wir fügen auch Klarstellungen und FAQs als Teil der Wissensdatenbank hinzu.

Wir haben drei Tools konfiguriert:

Unser Bewertungstool umfasst ein LLM, das das endgültige Transkript durchgeht und das Gespräch anhand definierter Kriterien bewertet.

Bewertungskriterien (Erfolg / Misserfolg / unbekannt)

Datenerfassung:

Unser Dokumentationsagent hat sich als effektiv erwiesen, um Benutzern bei der Navigation durch häufige Produkt- und Supportfragen zu helfen, und ist ein engagierter Co-Pilot für Benutzer, die unsere Dokumente durchstöbern. Wir können unseren Agenten durch kontinuierliche automatisierte und manuelle Überwachung konsequent iterieren und verbessern. Wir erkennen an, dass nicht alle Arten von Supportanfragen oder Fragen von einem LLM gelöst werden können, insbesondere für ein Startup, das schnell baut und ständig innoviert, und mit extrem technischen und kreativen Benutzern. Aber wir haben festgestellt, dass je mehr wir automatisieren können, desto mehr Zeit kann unser Team darauf verwenden, sich auf die kniffligen und interessanten Probleme zu konzentrieren, die an den Rändern auftauchen, während unsere Community weiterhin die Grenzen dessen, was mit KI-Audio möglich ist, erweitert.

Unser Agent wird betrieben von ElevenLabs Konversations-KI. Wenn Sie meine Ergebnisse reproduzieren möchten, können Sie ein kostenloses Konto erstellen und meinen Schritten folgen. Wenn Sie stecken bleiben, können Sie mit dem Agenten sprechen, den wir in unseren Dokumenten bereitgestellt haben, oder sich mit mir und meinem Team in Discord in Verbindung setzen. Für Anwendungsfälle mit hohem Volumen (>100 Anrufe pro Tag), kontaktieren Sie unser Vertriebsteam für Mengenrabatte.

Unsere All-in-One-Plattform zum Erstellen anpassbarer, interaktiver Sprachagenten

Sie haben noch nie ein so schnelles, menschenähnliches TTS erlebt