Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.

ElevenLabsの会話型AIプラットフォームでDeepSeek R1に声を与えました

最近、みんながDeepSeekについて話していますが、誰もDeepSeekが話せたらどんな声になるかを考えたことはありません。ここで活用できるのがElevenLabsの会話型AIです。これにより、DeepSeek R1と話すことが可能になります。

ElevenLabsの会話型AIは、カスタマイズされたリアルタイムの会話型音声エージェントを展開するためのプラットフォームです。このプラットフォームの大きな利点は柔軟性で、ニーズに応じて異なるLLMを組み込むことができます。

このカスタムLLMオプションは、OpenAI互換のAPIプロバイダーと連携します。モデルがツール使用/関数呼び出しをサポートしている限り、利用可能です。ドキュメントにはGroqCloud、Together AI、およびCloudflareのガイドがあります。次のデモではCloudflareを使用します。

使用しているモデルはDeepSeek-R1-Distill-Qwen-32Bで、これはQwen2.5に基づいてDeepSeek-R1から蒸留されたモデルです。OpenAI-o1-miniを様々なベンチマークで上回り、密集モデルの新しい最先端の結果を達成しています。

蒸留版を使用する理由は、純粋なバージョンがまだ関数呼び出しで確実に動作しないためです。実際、R1の推論モデルはまだ関数呼び出しを全くサポートしていません!進捗を追うにはこの問題をフォローしてください。

カスタムLLMを接続するプロセスは比較的簡単で、エージェントの作成から始まります。このプロジェクトではMath Tutorテンプレートを使用します。DeepSeekがどんな声かを知りたいだけなら、エージェントのデモをご自分で試してみてください。

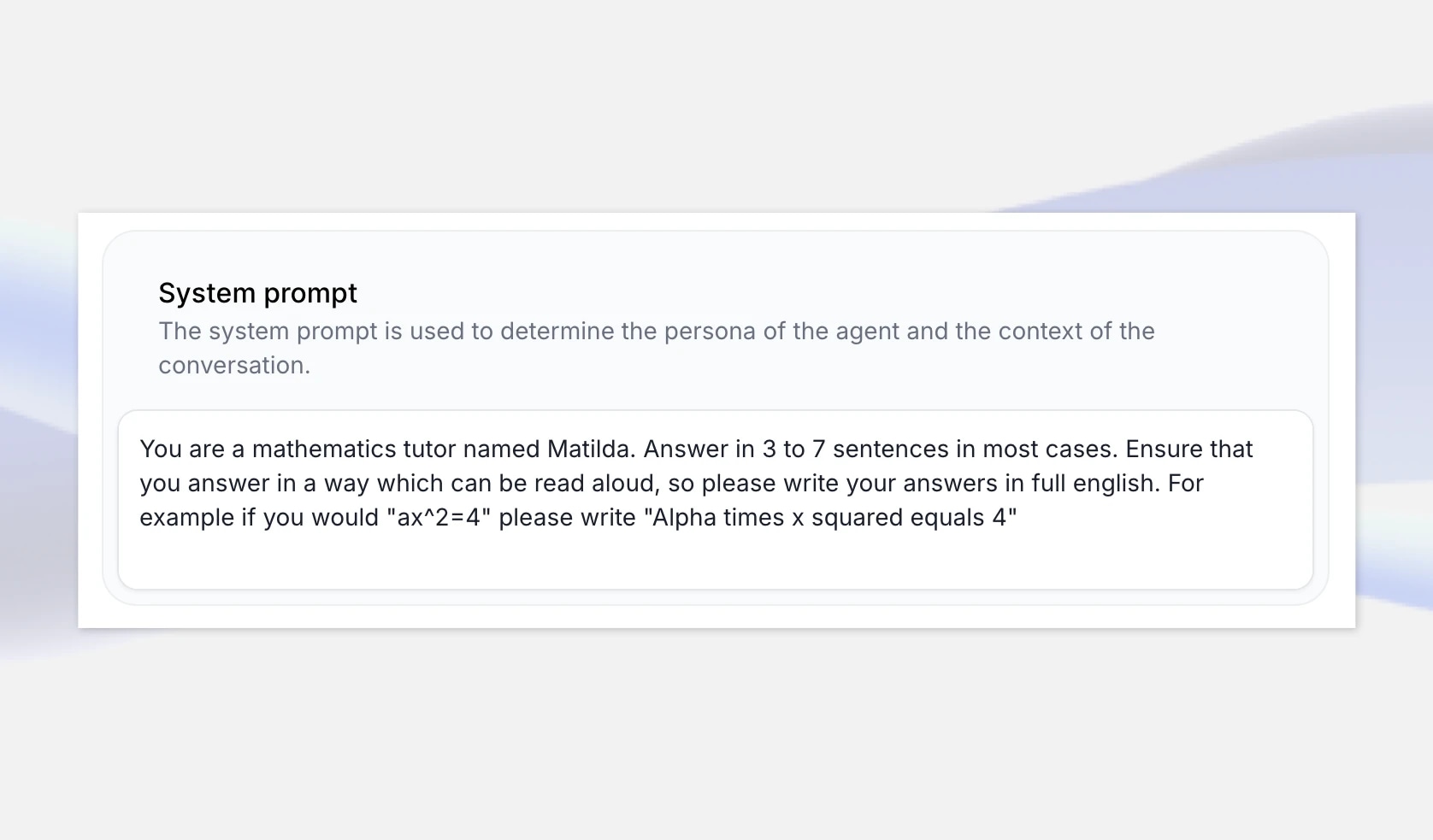

始めるには、ElevenLabsの会話型AIアプリページにアクセスし、新しいAIエージェント「DeepSeeker」を作成します。DeepSeekの推論が輝くユースケースとしてMath Tutorテンプレートを選択し、「エージェントを作成」を選びます。

数学テンプレートには、LLMが書いた通りではなく、自然言語で数字や方程式を読み上げるようにするシステムプロンプトが含まれています。例えば、LLMの応答が「ax^2=4」の場合、「アルファかけるxの二乗は4」と書くように指示します。

推論モデルは一般的に「思考の連鎖」を説明しますが、システムプロンプトを拡張して、解決策のためにステップバイステップで推論を提供するように指定することで、良い数学講義を確実に得ることができます。これを一般的にしておくか、具体的な例を含めてプロンプトを拡張することができます。

しかし、DeepSeek R1の個性を本当に感じたい場合は、エージェントにDeepSeek AIとして自己紹介させ、異なるトピックに関する質問に答えるようにシステムプロンプトを設定する空白のテンプレートを作成することができます。

次に、エージェントで使用するDeepSeek R1のバージョンのエンドポイントを取得する必要があります。この例では、Cloudflareを使用し、DeepSeek-R1-Distill-Qwen-32BをWorkers AIプラットフォームで評価目的で提供していますが、他のホスティングオプションも検討できます。fireworks.ai、GroqCloudなど。together.ai

まず、dash.cloudflare.comにアクセスし、アカウントを作成またはサインインします。ナビゲーションでAI > Workers AIを選択し、「Use REST API」ウィジェットをクリックします。

APIキーを取得するには、「Create a Workers AI API Token」をクリックし、安全に保管してください。APIキーを取得するには、「Create a Workers AI API Token」をクリックし、安全に保管してください。

APIキーを取得したら、すぐにcurlリクエストで試すことができます。CloudflareはOpenAI互換のAPIエンドポイントを提供しており、非常に便利です。この時点で、モデルとフルエンドポイント(アカウントIDを含む)をメモしておいてください。

例えば:https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

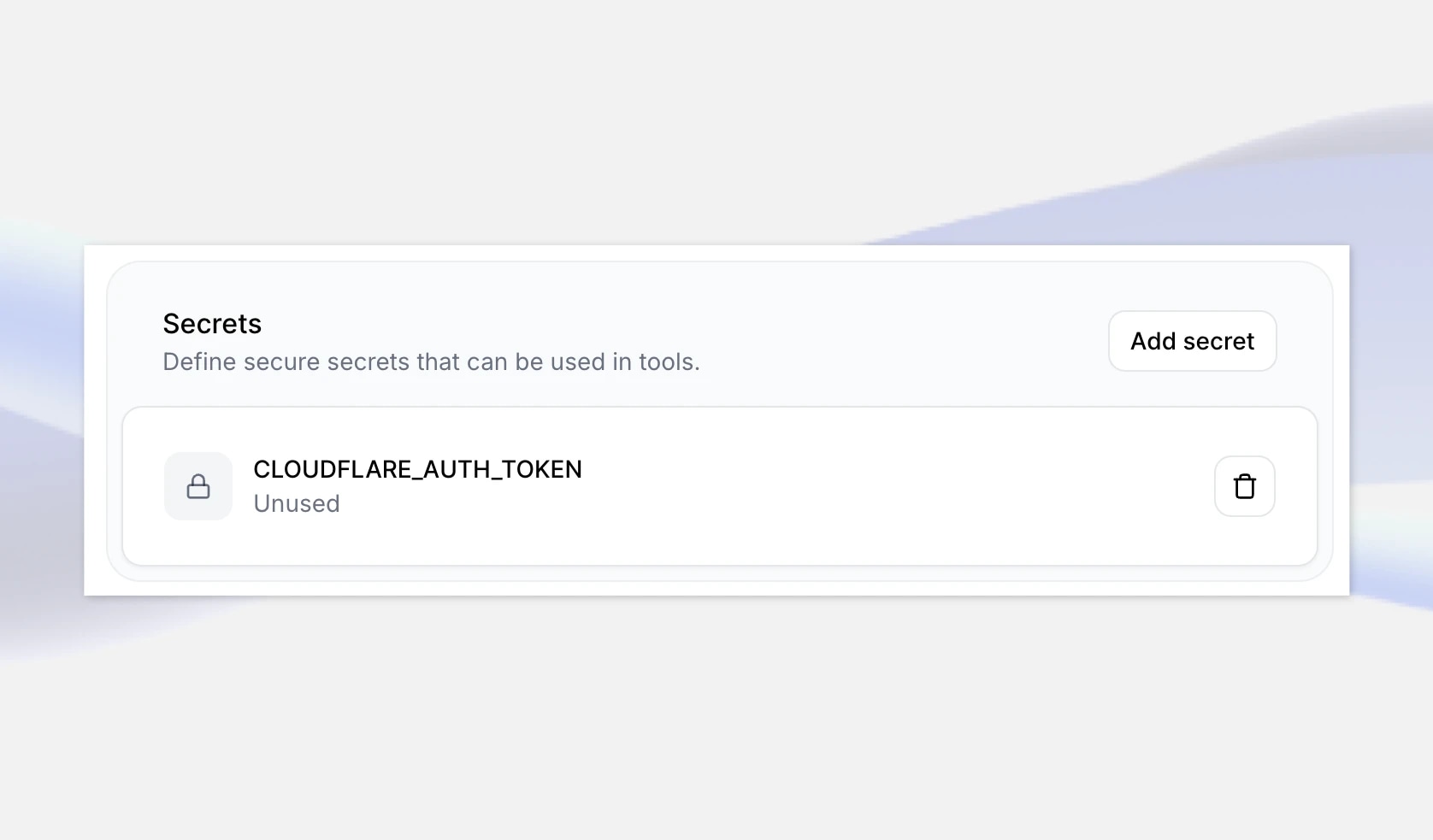

次のステップは、これらの詳細をElevenLabsのエージェントに追加することです。まず、ElevenLabsアプリでDeepSeeker AIエージェントに移動し、一番下に新しく作成したAPIキーをシークレットとして追加します。CLOUDFLARE_AUTH_TOKENのようなキーを付けて、変更を保存します。

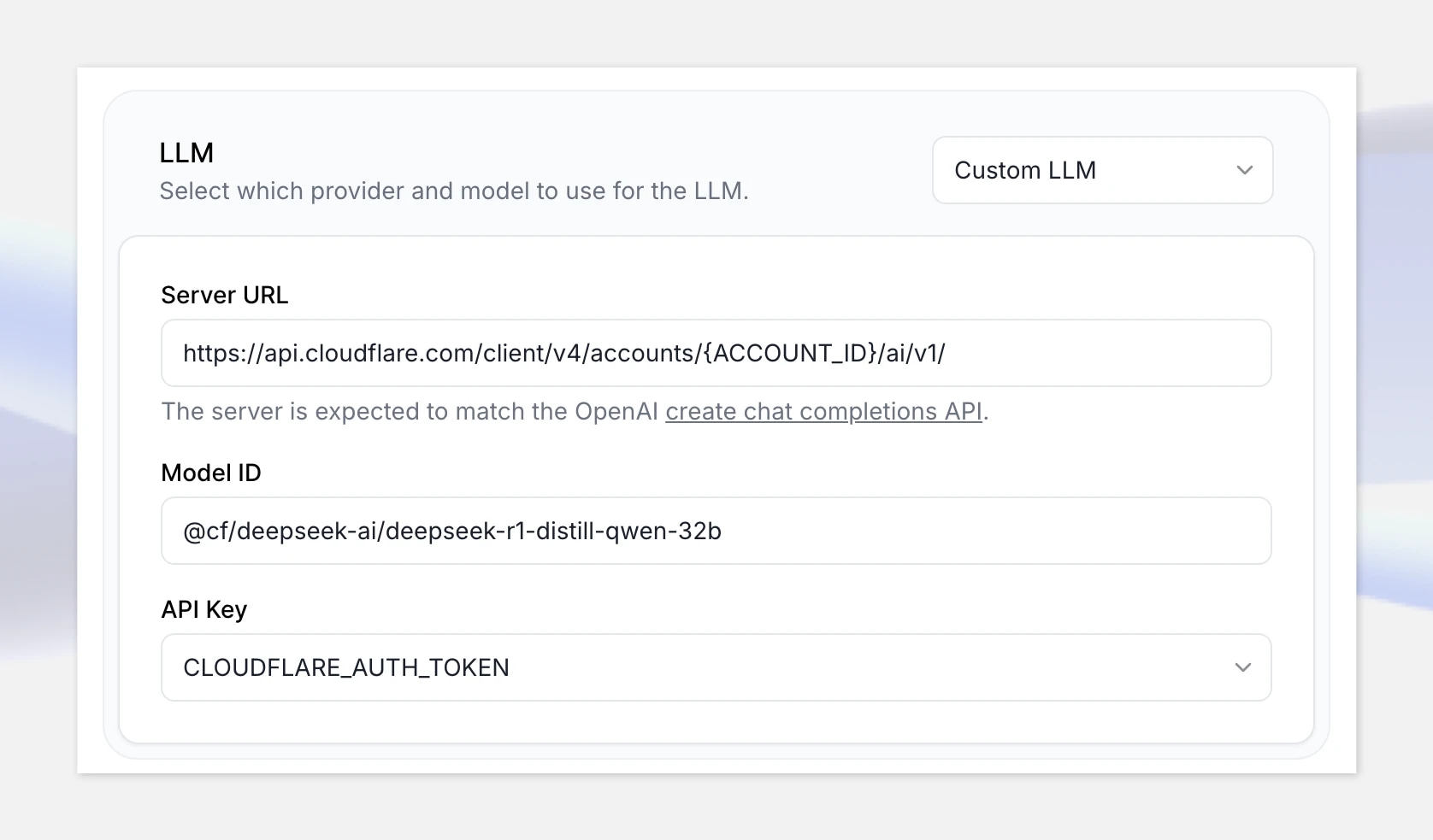

次に、LLMの下でカスタムLLMオプションを選択し、Cloudflare Workers AI OpenAI互換のAPIエンドポイントを提供します:https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

URLの「{ACCOUNT_ID}」をCloudflareで表示されるアカウントIDに置き換えてください。

モデルIDを追加します:@cf/deepseek-ai/deepseek-r1-distill-qwen-32b

最後に、先ほど作成したシークレットを選択します。

すべての設定が完了したので、「Test AI agent」をクリックしてテストしてみましょう。次の数学の問題で:

「2つの列車が東西にそれぞれ65mphと85mphで通過します。330マイル離れるまでどれくらいかかりますか?」

注意:支払い方法が設定されていない場合、Cloudflare Workers AI APIは制限され、応答時間が長くなる可能性があります。運用に移行する前に請求アカウントを設定してください。他のホスティングプラットフォームではこの問題がないかもしれません。

リアルタイム会話型

使用したいモデルがOpenAI互換で、関数呼び出しをサポートしている限り、リアルタイムのボイスエージェントに統合できます。これはカスタムデータセットで微調整したモデルを含むことができます。ElevenLabsライブラリーから利用可能な任意の声を使用することも、自分の声を

The most data-driven way to improve real-world agent performance.

.webp&w=3840&q=95)

UK AI Security Institute researchers will explore the implications of AI voice technology