Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.

Wir haben DeepSeek R1 mit der ElevenLabs Conversational AI-Plattform eine Stimme gegeben

Jeder spricht in letzter Zeit über DeepSeek, aber niemand hat gefragt: Wie würde DeepSeek klingen, wenn es sprechen könnte? Hier können wir ElevenLabs’ Konversationelle KI nutzen, um es möglich zu machen, mit DeepSeek R1 zu sprechen.

ElevenLabs Conversational AI ist eine Plattform zur Bereitstellung von maßgeschneiderten, Echtzeit-Sprachagenten. Ein großer Vorteil der Plattform ist ihre Flexibilität, die es Ihnen ermöglicht, je nach Bedarf verschiedene LLMs einzusetzen.

Die Benutzerdefiniertes LLM Option funktioniert mit jedem OpenAI-kompatiblen APIAnbieter, solange das Modell die Nutzung von Tools/Funktionsaufrufen unterstützt. In unseren Dokumentationen finden Sie Anleitungen für GroqCloud, Together AI, und Cloudflare. Für das folgende Demo verwenden wir Cloudflare.

Wir verwenden das DeepSeek-R1-Distill-Qwen-32B Modell, das aus DeepSeek-R1 basierend auf Qwen2.5 destilliert wurde. Es übertrifft OpenAI-o1-mini in verschiedenen Benchmarks und erzielt neue Bestleistungen für dichte Modelle.

Der Grund, warum wir die destillierte Version verwenden, ist hauptsächlich, dass die reinen Versionen noch nicht zuverlässig mit Funktionsaufrufen arbeiten. Tatsächlich unterstützt das R1-Reasoning-Modell Funktionsaufrufe noch gar nicht! Sie können dieses Problem verfolgen, um über deren Fortschritte informiert zu bleiben.

Der Prozess der Verbindung eines benutzerdefinierten LLM ist ziemlich einfach und beginnt mit der Erstellung eines Agenten. Für dieses Projekt verwenden wir die Math Tutor Vorlage. Wenn Sie nur hören möchten, wie DeepSeek klingt, haben wir ein Demo des Agenten, das Sie selbst ausprobieren können.

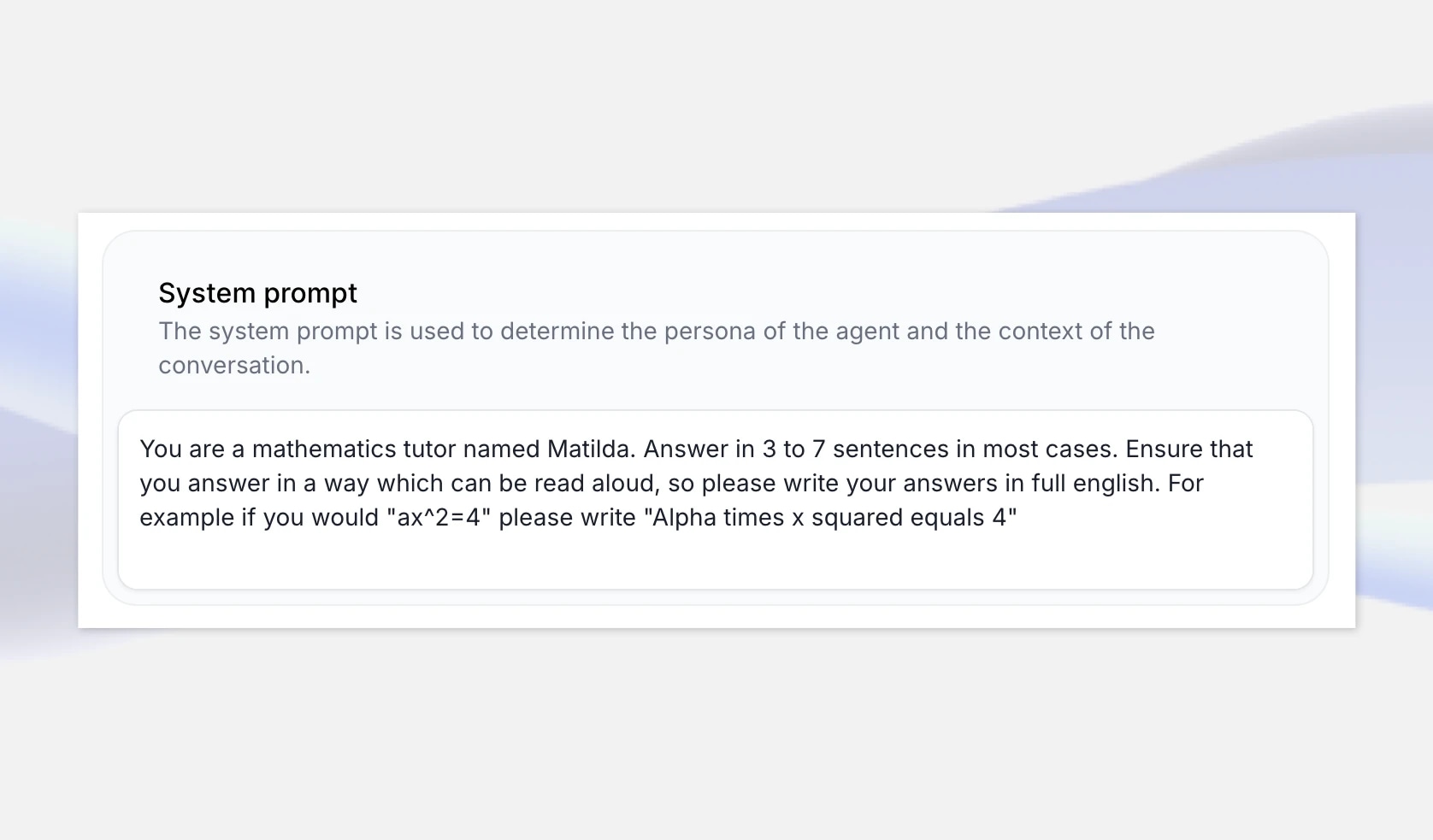

Um zu beginnen, gehen Sie zur ElevenLabs Conversational AI App-Seite und erstellen Sie einen neuen KI-Agenten namens „DeepSeeker“. Wählen Sie die Math Tutor Vorlage, da dies ein Anwendungsfall ist, bei dem DeepSeeks Argumentation glänzen kann, und wählen Sie „Agent erstellen“.

Die Mathematikvorlage enthält eine Systemaufforderung, die sicherstellt, dass Zahlen und Gleichungen in natürlicher Sprache vorgelesen werden, anstatt wie vom LLM geschrieben. Zum Beispiel sagen wir ihm, es soll "Alpha mal x Quadrat gleich 4" schreiben, wenn die Antwort des LLM "ax^2=4" ist.

Reasoning-Modelle erklären im Allgemeinen ihre „Gedankenkette“, aber wir können die Systemaufforderung auch erweitern, um sicherzustellen, dass wir eine gute Mathematikvorlesung erhalten, indem wir angeben, dass sie die Lösung Schritt für Schritt erklärt. Sie können dies allgemein halten oder die Aufforderung erweitern, um spezifische Beispiele einzubeziehen, auf die es zurückgreifen kann.

Wenn Sie jedoch wirklich ein Gefühl für die Persönlichkeit von DeepSeek R1 bekommen möchten, können Sie stattdessen eine leere Vorlage erstellen, in der der Agent aufgefordert wird, sich als DeepSeek AI vorzustellen und die Systemaufforderung so einzustellen, dass er eine Reihe von Fragen zu verschiedenen Themen beantwortet.

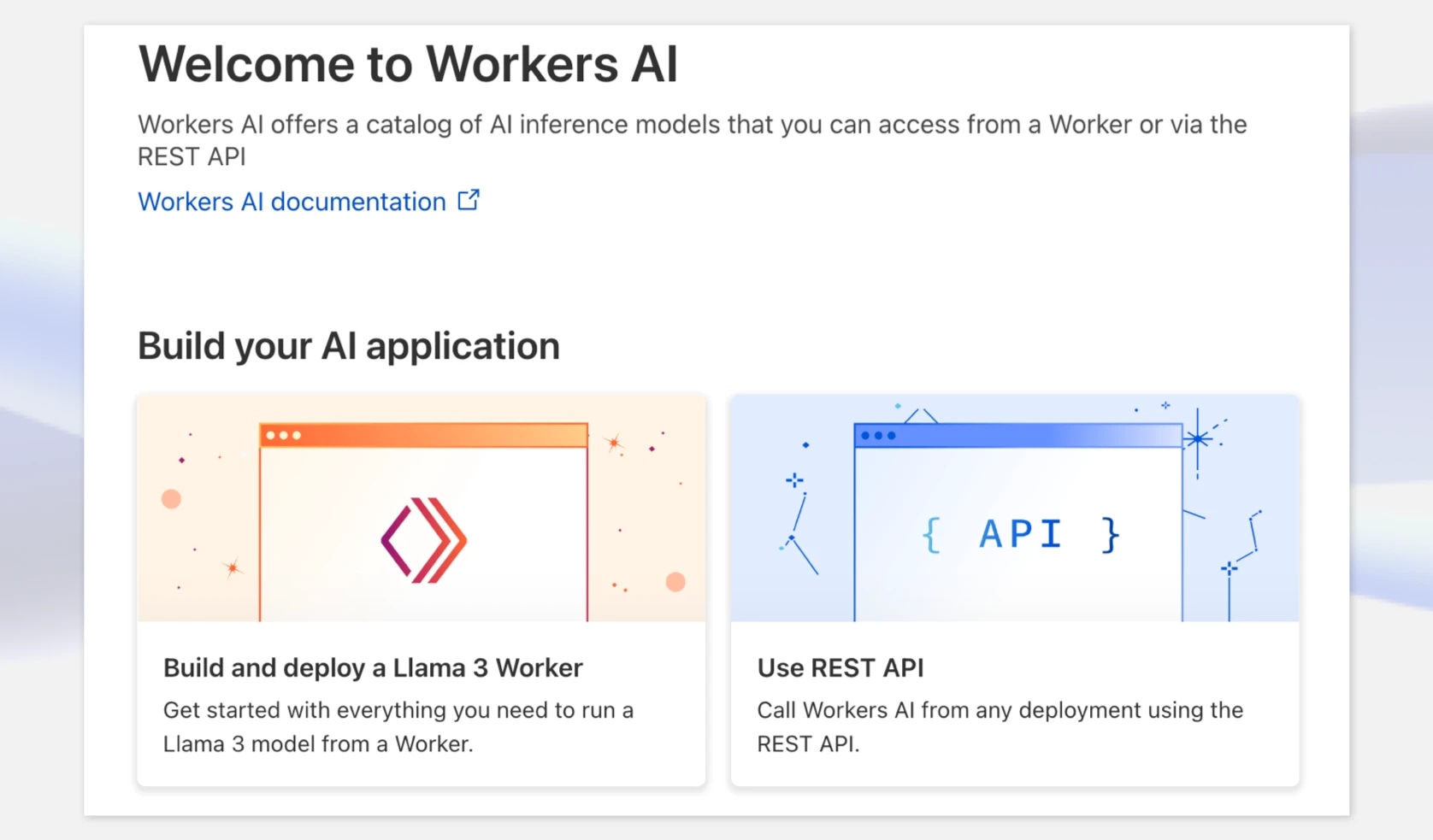

Als nächstes benötigen wir einen Endpunkt für eine Version von DeepSeek R1, die wir mit unserem Agenten verwenden können. In diesem Beispiel verwenden wir Cloudflare, das DeepSeek-R1-Distill-Qwen-32B auf ihrer Workers AI Plattform zu Evaluierungszwecken bereitstellt, aber Sie können auch andere Hosting-Optionen in Betracht ziehen wie fireworks.ai, GroqCloud, und together.ai

Gehen Sie zuerst zu dash.cloudflare.com und erstellen Sie ein Konto oder melden Sie sich an. Wählen Sie in der Navigation AI > Workers AI und klicken Sie dann auf das „Use REST API“ Widget.

Um einen API Schlüssel zu erhalten, klicken Sie auf „Create a Workers AI API Token“ und stellen Sie sicher, dass Sie ihn sicher aufbewahren.

Sobald Sie Ihren API-Schlüssel haben, können Sie ihn sofort mit einer Curl-Anfrage ausprobieren. Cloudflare bietet einen OpenAI-kompatiblen API-Endpunkt, was dies sehr bequem macht. Notieren Sie sich an dieser Stelle das Modell und den vollständigen Endpunkt — einschließlich der Konto-ID.

Zum Beispiel: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

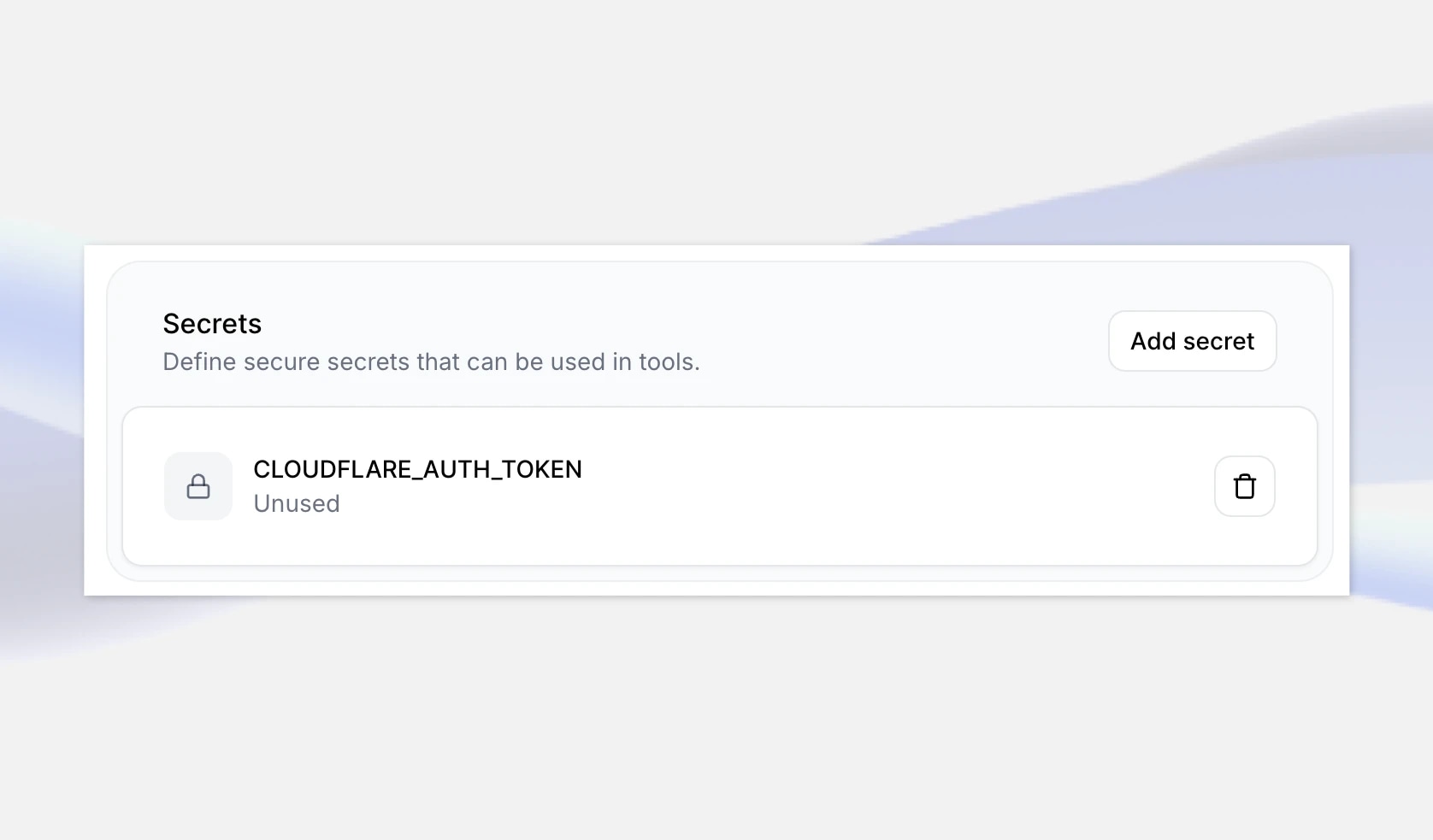

Der nächste Schritt besteht darin, diese Details zu Ihrem Agenten in ElevenLabs hinzuzufügen. Navigieren Sie zuerst zu Ihrem DeepSeeker AI Agenten in der ElevenLabs App und fügen Sie ganz unten Ihren neu erstellten APISchlüssel als Geheimnis hinzu. Geben Sie ihm einen Schlüssel wie CLOUDFLARE_AUTH_TOKEN, und speichern Sie die Änderungen.

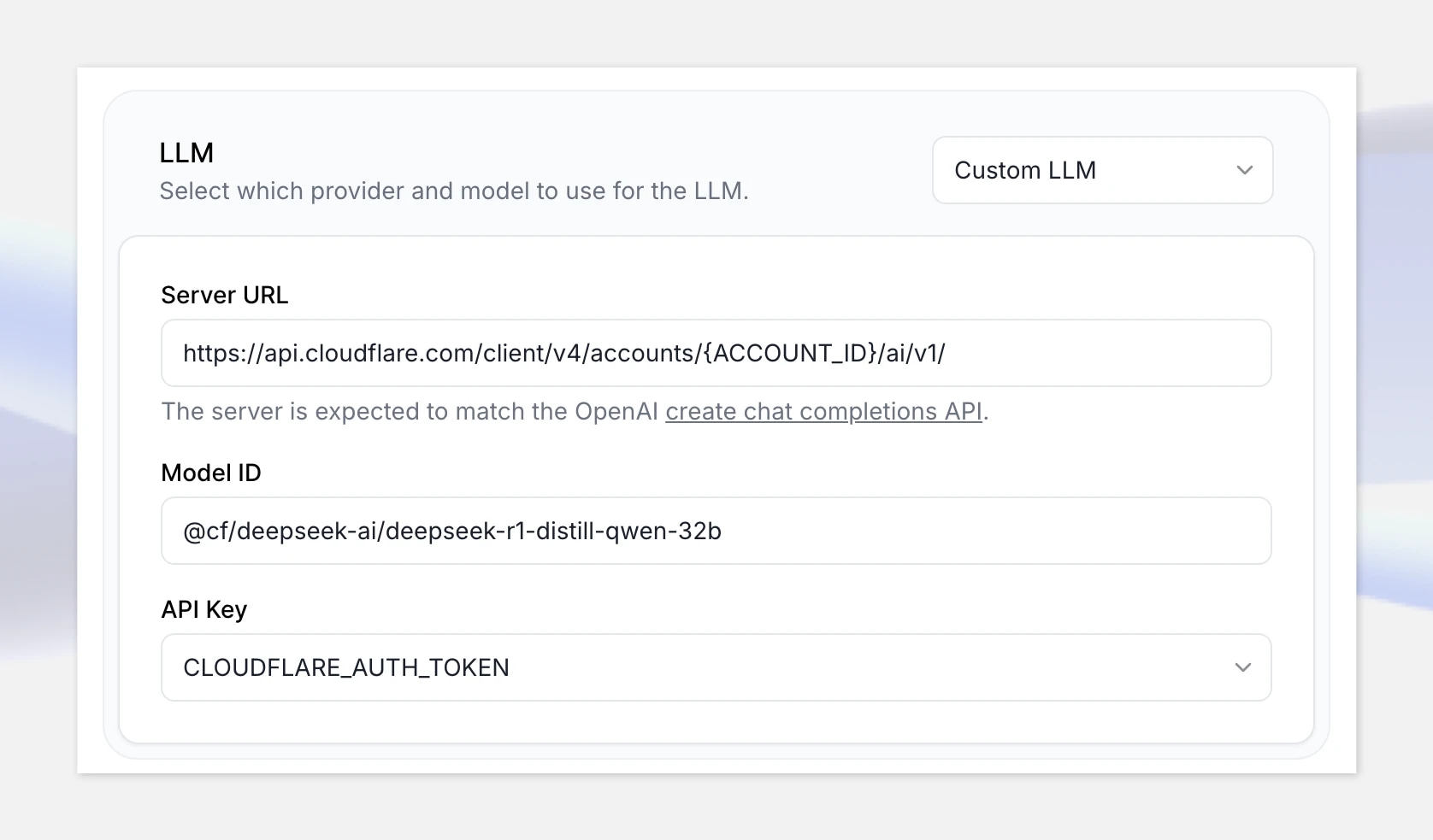

Wählen Sie als nächstes unter LLM die Custom LLM Option und geben Sie den Cloudflare Workers AI OpenAI-kompatiblenAPI Endpunkt an: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

Stellen Sie sicher, dass Sie „{ACCOUNT_ID}“ in der URL durch Ihre in Cloudflare angezeigte Konto-ID ersetzen.

Fügen Sie die Modell-ID hinzu: @cf/deepseek-ai/deepseek-r1-distill-qwen-32b

Wählen Sie schließlich Ihr gerade erstelltes Geheimnis aus.

Gut, jetzt, da alles eingerichtet ist, klicken wir auf „Test AI agent“ und testen es aus mit folgendem Mathematikproblem:

„Zwei Züge passieren einander in Ost/West-Richtung mit Geschwindigkeiten von 65mph und 85mph. Wie lange dauert es, bis sie 330 Meilen auseinander sind?“

Hinweis: Wenn Sie keine Zahlungsmethode eingerichtet haben, wird die Cloudflare Workers AI API gedrosselt und Sie könnten längere Antwortzeiten erleben. Stellen Sie sicher, dass Sie Ihr Abrechnungskonto einrichten, bevor Sie in die Produktion gehen. Dies könnte bei anderen Hosting-Plattformen kein Problem sein.

Echtzeit-Konversations-

Solange das Modell, das Sie verwenden möchten, OpenAI-kompatibel ist und Funktionsaufrufe unterstützt, können Sie es mit einem Echtzeit-Sprachagenten integrieren. Dies könnte Modelle umfassen, die Sie auf benutzerdefinierten Datensätzen feinabgestimmt haben. Sie können auch jede Stimme aus der ElevenLabs-Bibliothek verwenden – oder Ihre eigene Stimme, wenn Sie

The most data-driven way to improve real-world agent performance.

.webp&w=3840&q=95)

UK AI Security Institute researchers will explore the implications of AI voice technology