各話者の感情、タイミング、トーン、独自の特徴を保ちながら音声とビデオを翻訳

吹き替えとは、映画やビデオの元のセリフを新しい音声に置き換えるプロセスを指します。映画制作やビデオ作成において、吹き替えは通常、映画やテレビシリーズを視聴者の母国語に翻訳する目的で行われます。

言語の吹き替えとは、映画やビデオのオリジナルのセリフを新しい音声に置き換えるプロセスを指します。映画制作やビデオ制作では、吹き替えは通常、映画やテレビシリーズを対象視聴者の母国語に翻訳するなど、翻訳の目的で実施されます。

人気のアニメシリーズの多くは英語やその他の広く話されている言語に吹き替えられるため、多くの人がアニメ(日本のアニメ映画)を通じて吹き替えの概念に慣れ親しんでいます。アニメファンの間では、「サブ」(オリジナルの日本語音声に字幕を付けたもの)と「ダブ」(シリーズの英語吹き替え版)のどちらが優れているかについて頻繁に議論されています。

とはいえ、吹き替えは日本のアニメ映画やシリーズだけにとどまらず、映画、テレビシリーズ、ドキュメンタリー、そして現代のデジタル世界では YouTube 動画にも広く採用されています。

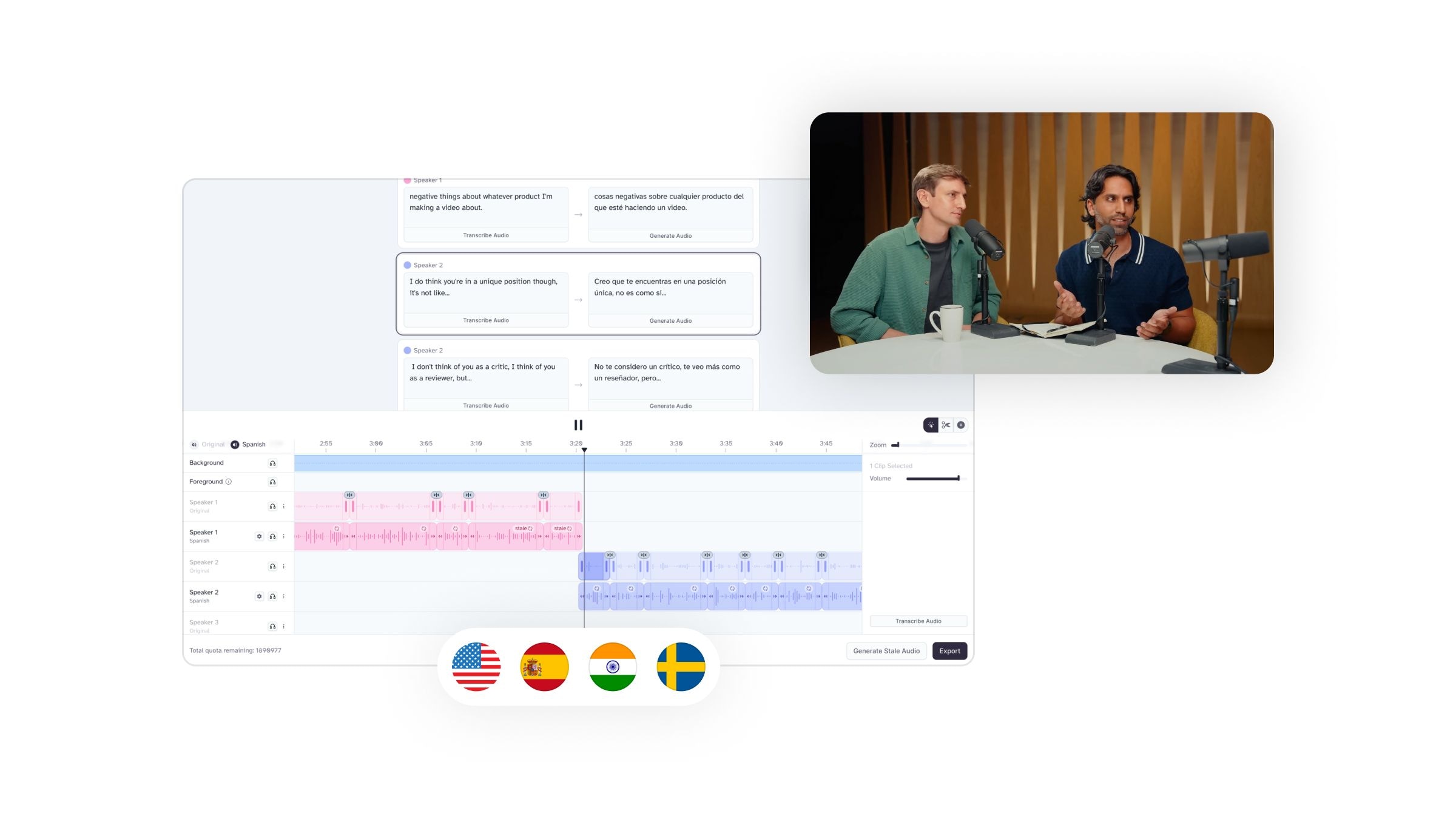

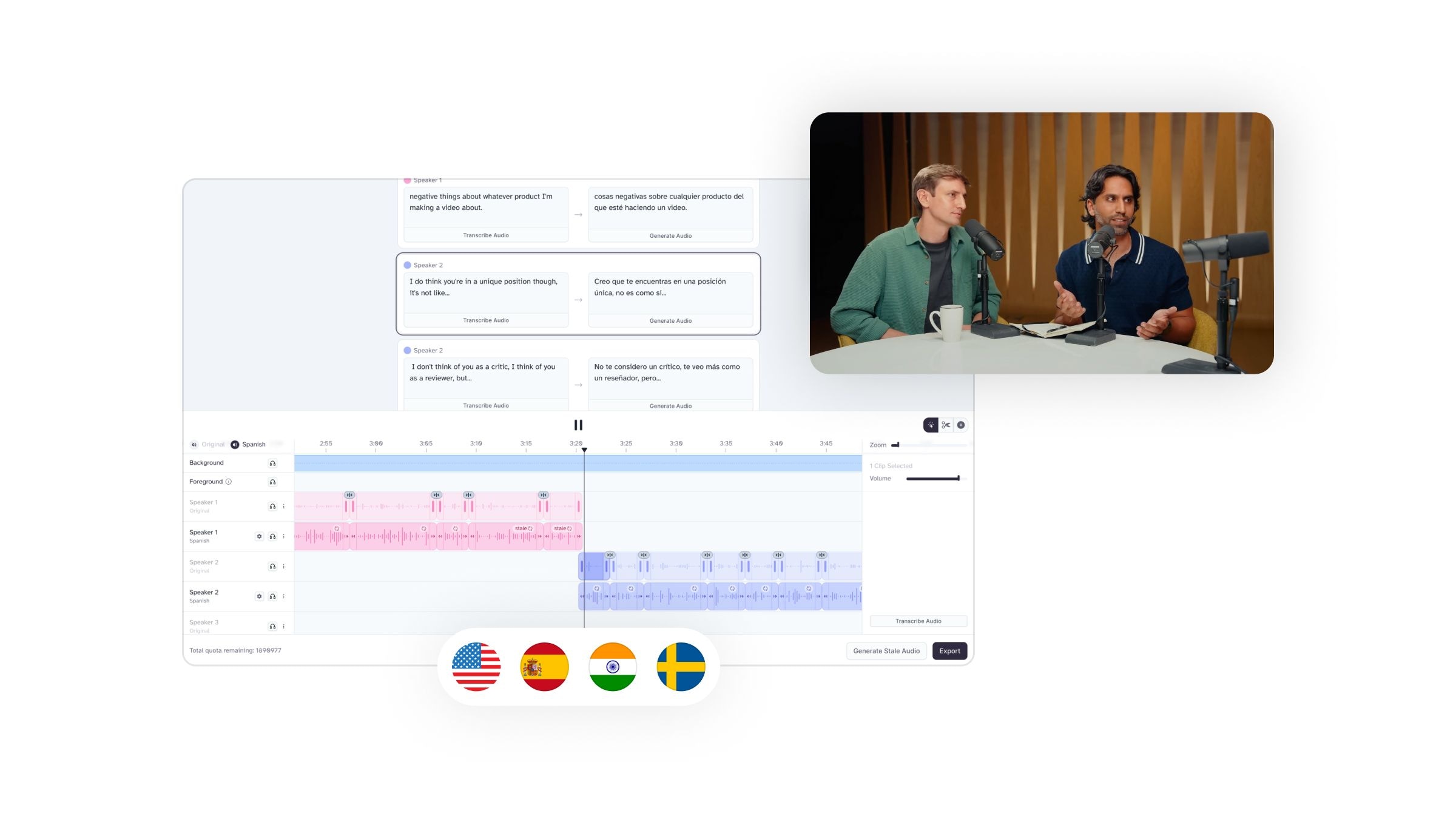

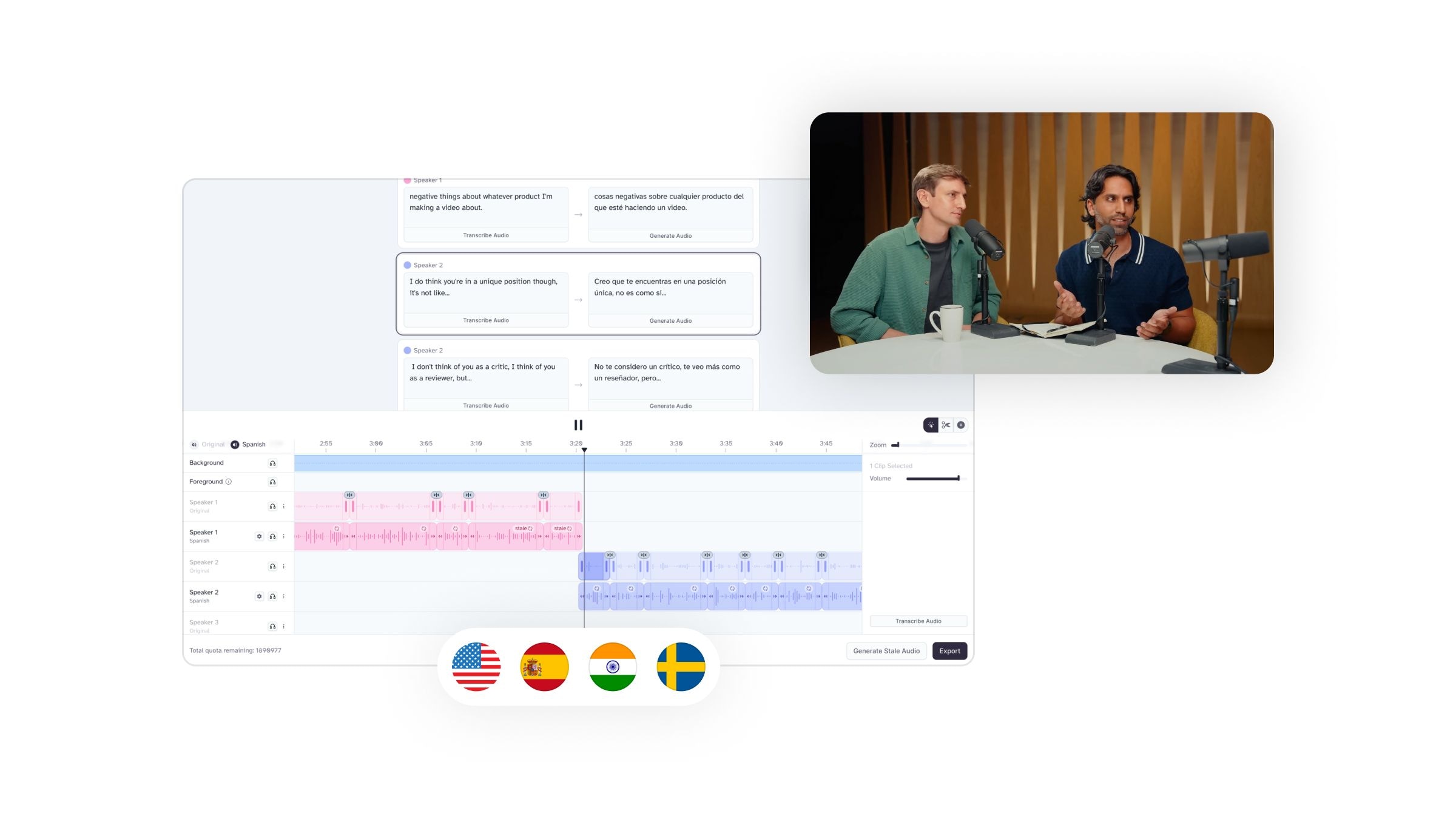

かつては、ビジュアルコンテンツの吹き替えは面倒で細心の注意が必要でしたが、AI テクノロジー (特に音声生成ツール) の進歩により、クリエイターは時間とコストのかかる手順の多くを省略し、数分で高品質の吹き替えを生成できるようになりました。

各話者の感情、タイミング、トーン、独自の特徴を保ちながら音声とビデオを翻訳

AI は吹き替えのプロセスをどのように変革しているのでしょうか?

AI 技術が使用される(そして広く利用可能になる)前は、吹き替えは比較的時間がかかり、コストのかかるプロセスであると考えられていました。プロデューサーやクリエイターは、声優を探し、オーディションを開催し、役柄に最適な人材を雇用し、そのナレーションアーティストと協力して吹き替え音声を一から作成する必要があります。

このプロセスには、長時間にわたるオーディション、慎重な意思決定、綿密な脚本の翻訳作業、長時間にわたる音声録音セッションが含まれていました。

では、特定のキャラクターの吹き替えを担当するために雇われたすべての声優に対して、同じプロセスが行われることを想像してみてください。それは、膨大な時間、お金、そしてエネルギーです。

幸いなことに、AI の進歩により、プロデューサーやクリエイターは、吹き替え用の高品質オーディオを大幅に短時間で生成できるようになり、これらの課題のほとんどを回避できるようになりました。

しかし、このプロセスは実際にはどのように機能するのでしょうか? ElevenLabsプロデューサーやクリエイターに多くの便利なツールと機能を提供します。

高度なAI搭載音声生成およびTTSツール

このような機能には、さまざまなナレーション オプションを備えた広範な音声ライブラリ、調整可能なパラメーター (速度、アクセント、抑揚など)、音声の複製機能、そして最も重要な点として、最終的な音声が本物の人間の音声と区別がつかないことなどが含まれます。

人工知能は特にTTSやボイスジェネレーターの分野で確実に進化しています。高度な機械学習と自然言語処理により、これらのツールは人間の音声を認識し、処理し、実際の音声と区別がつかないほどに再現することができます。

人工知能は、特にTTSやElevenLabsのような音声生成ツールに関しては、間違いなく増加傾向にあります。徹底的な機械学習と自然言語処理を活用したこれらのツールは、本物と区別がつかないほどの人間の音声を認識、処理、再現できるようになりました。

AIツールは費用対効果が高い

想像してみてください。1 人以上のナレーターにシリーズ全体を手動で吹き替えてもらうためにお金を払い、スタジオのスペース代も支払い (作業がリモートでない場合)、撮り直しが必要になった場合でもナレーターに時間に対する報酬を支払い、誰かがプロジェクトを続行できない場合は代わりの人を探すことになるでしょう。これらは主な経費の一部です。

AIツールは時間の節約に役立つ

コストがかかるだけでなく、手作業によるダビングには時間もかかります。チームを編成し、声優を探して雇い、オーディションを実施し、脚本を翻訳し、撮り直しに取り組み、プロジェクトから誰かが抜けた場合は新しい俳優やナレーターを雇い、吹き替えオーディオ ファイルを最初のコンテンツに合わせる必要があります。

言い換えれば、それは大変な作業です!

AIツールは創造の自由をもたらす

吹き替えを制作する際は、常にオリジナルの音声を考慮する必要があります。人々は、自分自身で映画、シリーズ、ビデオゲーム、またはその他の視覚コンテンツのファンになるわけではありません。彼らは登場人物やナレーターとの強いつながりも築き、その中で特徴的な声が大きな役割を果たします。

言うまでもなく、すべての吹き替えが成功するわけではなく、ファンは最終結果に失望し、ナレーションの面で期待に応えられなかったためにコンテンツをボイコットすることもあります。

幸いなことに、AI はプロデューサーやクリエイターが AI 音声をゼロから作成したり、音声クローン技術を実装して言語を変更しながら元の音声を維持したりできるようにすることで、この問題を解決します。

ElevenLabsであらゆるビデオをダビングする方法

それが良さそうに思えるなら、AI吹き替えツールは元の話者の声とスタイルをすべての言語で一貫して保持し、ビデオを自動的に分析して話者を認識し、声、イントネーション、話す時間を一致させ、トランスクリプトと翻訳を手動で編集してコンテンツが適切に同期されるようにすることもできます。

最後に

翻訳オプションはアクセシビリティとコンテンツの拡張において大きな要素ですが、ビデオの吹き替えを手動で実行すると、コストがかかり、面倒で、制限される可能性があります。

幸いなことに、ElevenLabs のような高度な AI ベースの TTS および音声生成ツールは、世界中のエンターテインメント企業、プロデューサー、コンテンツ クリエイターが、追加費用を回避し、吹き替えプロセスを合理化しながら、ビジュアル コンテンツを効果的に吹き替えるのに役立っています。

各話者の感情、タイミング、トーン、独自の特徴を保ちながら音声とビデオを翻訳

Delivering authentic ad-style videos powered by human-sounding AI voices by ElevenLabs

Italy’s leading property marketplace adds 24/7 voice support with AI

Powered by ElevenLabs エージェント