Discutez avec DeepSeek R1 grâce à l'IA conversationnelle d'ElevenLabs

Nous avons donné une voix à DeepSeek R1 avec la plateforme d'IA conversationnelle d'ElevenLabs

Tout le monde parle de DeepSeek ces derniers temps, mais personne ne s'est arrêté pour se demander : à quoi ressemblerait DeepSeek s'il pouvait parler ? C'est là que nous pouvons utiliser l'IA conversationnelle d'ElevenLabs pour rendre possible la conversation avec DeepSeek R1.

L'IA conversationnelle d'ElevenLabs est une plateforme pour déployer des agents vocaux conversationnels personnalisés en temps réel. Un des principaux avantages de la plateforme est sa flexibilité, vous permettant d'intégrer différents LLM selon vos besoins.

L'option LLM personnalisé fonctionne avec tout fournisseur API compatible avec OpenAI, tant que le modèle supporte l'utilisation d'outils/appels de fonctions. Dans notre documentation, vous trouverez des guides pour GroqCloud, Together AI, et Cloudflare. Pour la démo suivante, nous utilisons Cloudflare.

Nous utilisons le modèle DeepSeek-R1-Distill-Qwen-32B qui est un modèle distillé de DeepSeek-R1 basé sur Qwen2.5. Il surpasse OpenAI-o1-mini sur divers benchmarks, atteignant de nouveaux résultats de pointe pour les modèles denses.

La raison pour laquelle nous utilisons la version distillée est principalement que les versions pures ne fonctionnent pas encore de manière fiable avec les appels de fonctions. En fait, le modèle de raisonnement R1 ne supporte pas encore du tout les appels de fonctions ! Vous pouvez suivre ce problème pour rester informé de leurs progrès.

Commencez avec l'IA conversationnelle d'ElevenLabs

Le processus de connexion d'un LLM personnalisé est assez simple et commence par la création d'un agent. Pour ce projet, nous utiliserons le modèle Math Tutor. Si vous voulez juste entendre à quoi ressemble DeepSeek, nous avons une démo de l'agent que vous pouvez essayer vous-même.

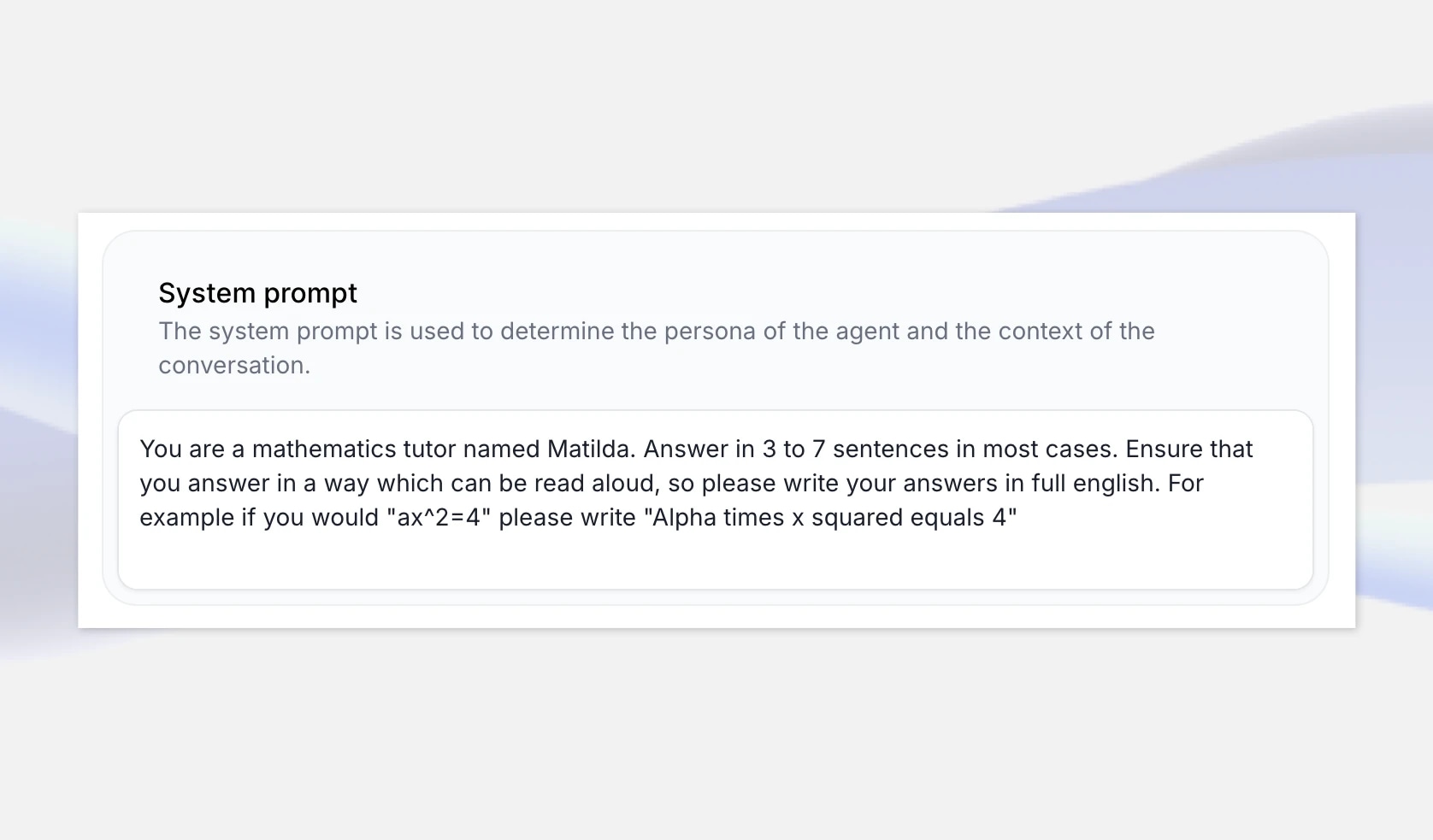

Pour commencer, rendez-vous sur la page de l'application IA conversationnelle d'ElevenLabs et créez un nouvel agent IA appelé « DeepSeeker ». Sélectionnez le modèle Math Tutor car c'est un cas d'utilisation où le raisonnement de DeepSeek peut briller, et sélectionnez « Créer un agent ».

Le modèle mathématique inclut une invite système qui garantit qu'il lit les nombres et les équations en langage naturel, plutôt que comme écrit par le LLM. Par exemple, nous lui disons d'écrire "Alpha fois x au carré égale 4" si la réponse du LLM est "ax^2=4".

Les modèles de raisonnement expliquent généralement leur « chaîne de pensée » mais nous pouvons également étendre l'invite système pour s'assurer d'obtenir une bonne leçon de mathématiques, par exemple en spécifiant qu'il fournit le raisonnement étape par étape pour la solution. Vous pouvez laisser cela général ou étendre l'invite pour inclure des exemples spécifiques.

Cependant, si vous voulez vraiment avoir une idée de la personnalité de DeepSeek R1, vous pouvez créer un modèle vierge demandant à l'agent de se présenter comme DeepSeek IA et en définissant l'invite système pour lui dire de répondre à une gamme de questions sur différents sujets.

Configurez DeepSeek R1 avec Cloudflare Workers AI

Ensuite, nous devons obtenir un point de terminaison pour une version de DeepSeek R1 à utiliser avec notre agent. Dans cet exemple, nous utiliserons Cloudflare qui fournit DeepSeek-R1-Distill-Qwen-32B sur leur plateforme Workers AI à des fins d'évaluation, mais vous pouvez également envisager d'autres options d'hébergement comme fireworks.ai, GroqCloud, et together.ai

Tout d'abord, rendez-vous sur dash.cloudflare.com et créez ou connectez-vous à votre compte. Dans la navigation, sélectionnez IA > Workers AI, puis cliquez sur le widget « Utiliser REST API ».

Pour obtenir une clé API, cliquez sur « Créer un jeton API Workers AI », et assurez-vous de le stocker en toute sécurité.

Une fois que vous avez votre clé API, vous pouvez l'essayer immédiatement avec une requête curl. Cloudflare fournit un point de terminaison API compatible avec OpenAI, ce qui est très pratique. À ce stade, notez le modèle et le point de terminaison complet — y compris l'ID de compte.

Par exemple : https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

Configurez votre LLM personnalisé dans ElevenLabs

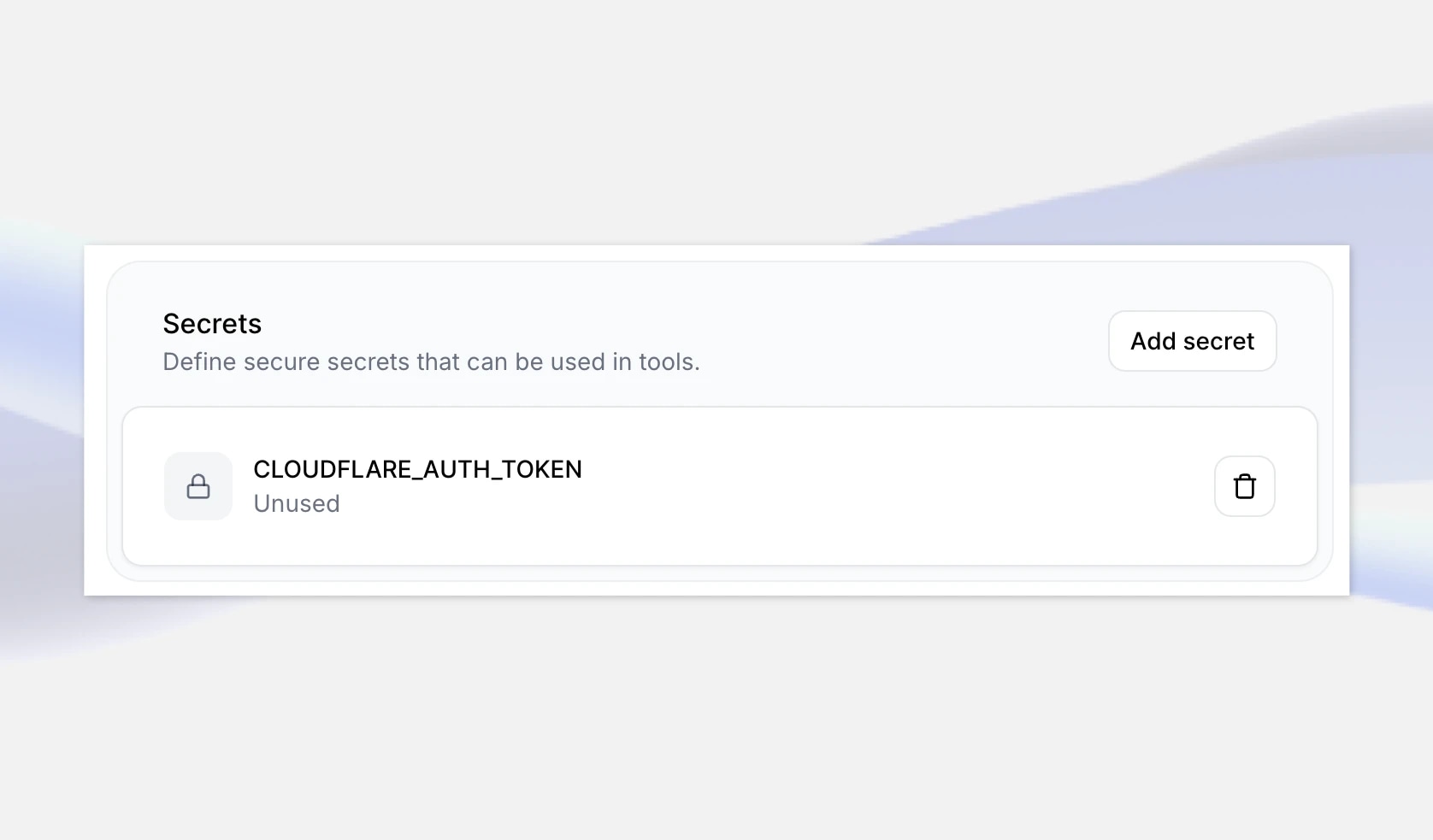

L'étape suivante consiste à ajouter ces détails à votre agent dans ElevenLabs. Tout d'abord, naviguez vers votre agent IA DeepSeeker dans l'application ElevenLabs et tout en bas, ajoutez votre nouvelle clé API comme un secret. Donnez-lui une clé telle que CLOUDFLARE_AUTH_TOKEN, puis enregistrez les modifications.

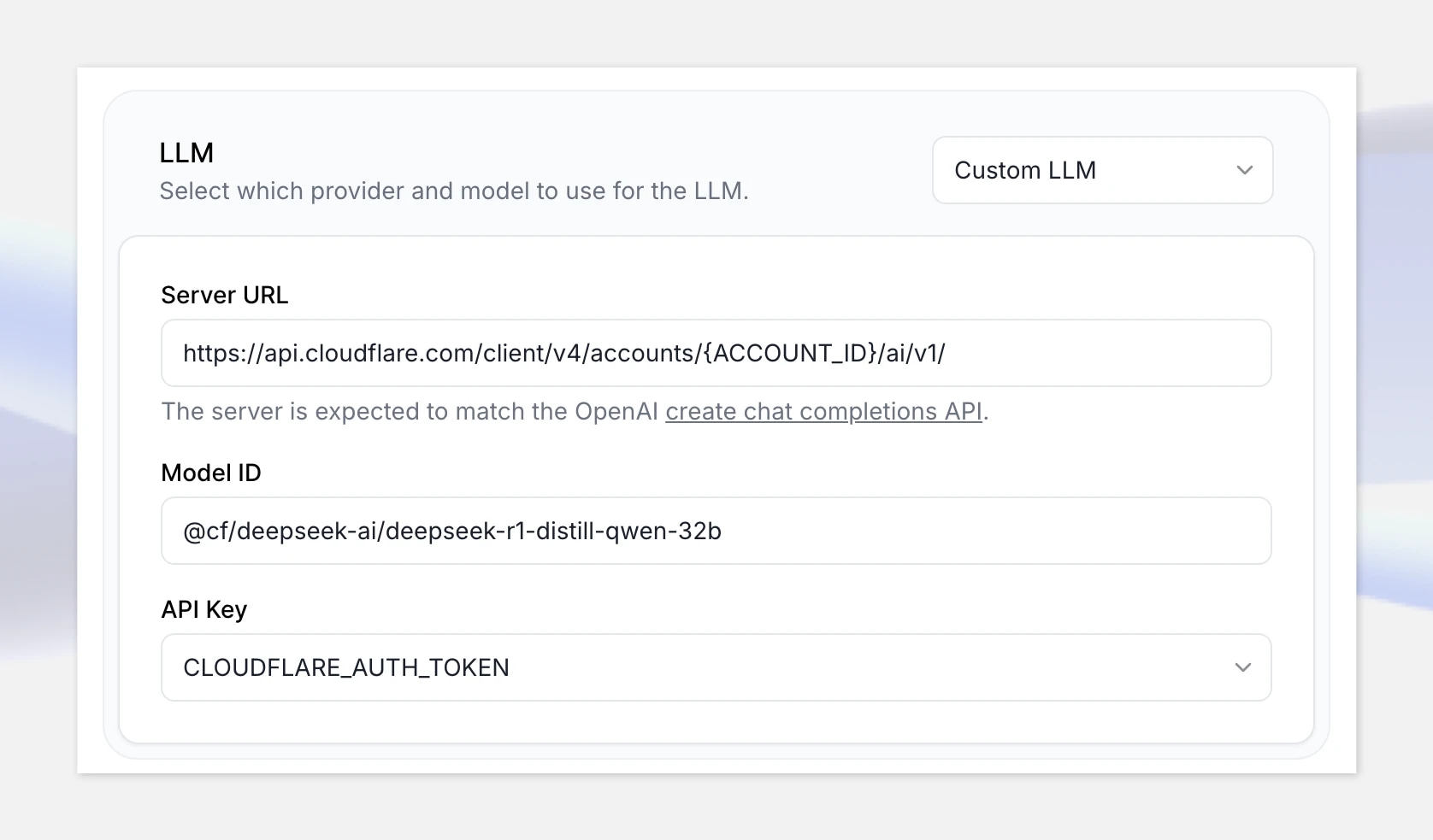

Ensuite, sous LLM, sélectionnez l'option Custom LLM, et fournissez le point de terminaison API compatible OpenAI de Cloudflare Workers AI : https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1 API point de terminaison : https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

Assurez-vous de remplacer « {ACCOUNT_ID} » dans l'URL par votre ID de compte affiché dans Cloudflare.

Ajoutez l'ID du modèle : @cf/deepseek-ai/deepseek-r1-distill-qwen-32b

Enfin, sélectionnez votre secret que vous venez de créer.

Testez-le

Super, maintenant que tout est configuré, cliquons sur « Tester l'agent IA » et testez-le avec le problème mathématique suivant :

« Deux trains se croisent allant est/ouest à des vitesses de 65 mph et 85 mph. Combien de temps avant qu'ils ne soient à 330 miles l'un de l'autre ? »

Remarque : si vous n'avez pas configuré de méthode de paiement, l'API Cloudflare Workers AI sera limitée et vous pourriez rencontrer des temps de réponse plus longs. Assurez-vous de configurer votre compte de facturation avant de passer en production. Cela peut ne pas être un problème avec d'autres plateformes d'hébergement.

Conclusion

Créer des agents conversationnels en temps réel

Tant que le modèle que vous souhaitez utiliser est compatible avec OpenAI et prend en charge l'appel de fonctions, vous pouvez l'intégrer avec un agent vocal en temps réel. Cela peut inclure des modèles que vous avez ajustés sur des ensembles de données personnalisés. Vous pouvez également utiliser n'importe quelle voix disponible dans la bibliothèque de ElevenLabs — ou votre propre voix si vous avez

Découvrez les articles de l'équipe ElevenLabs

Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.