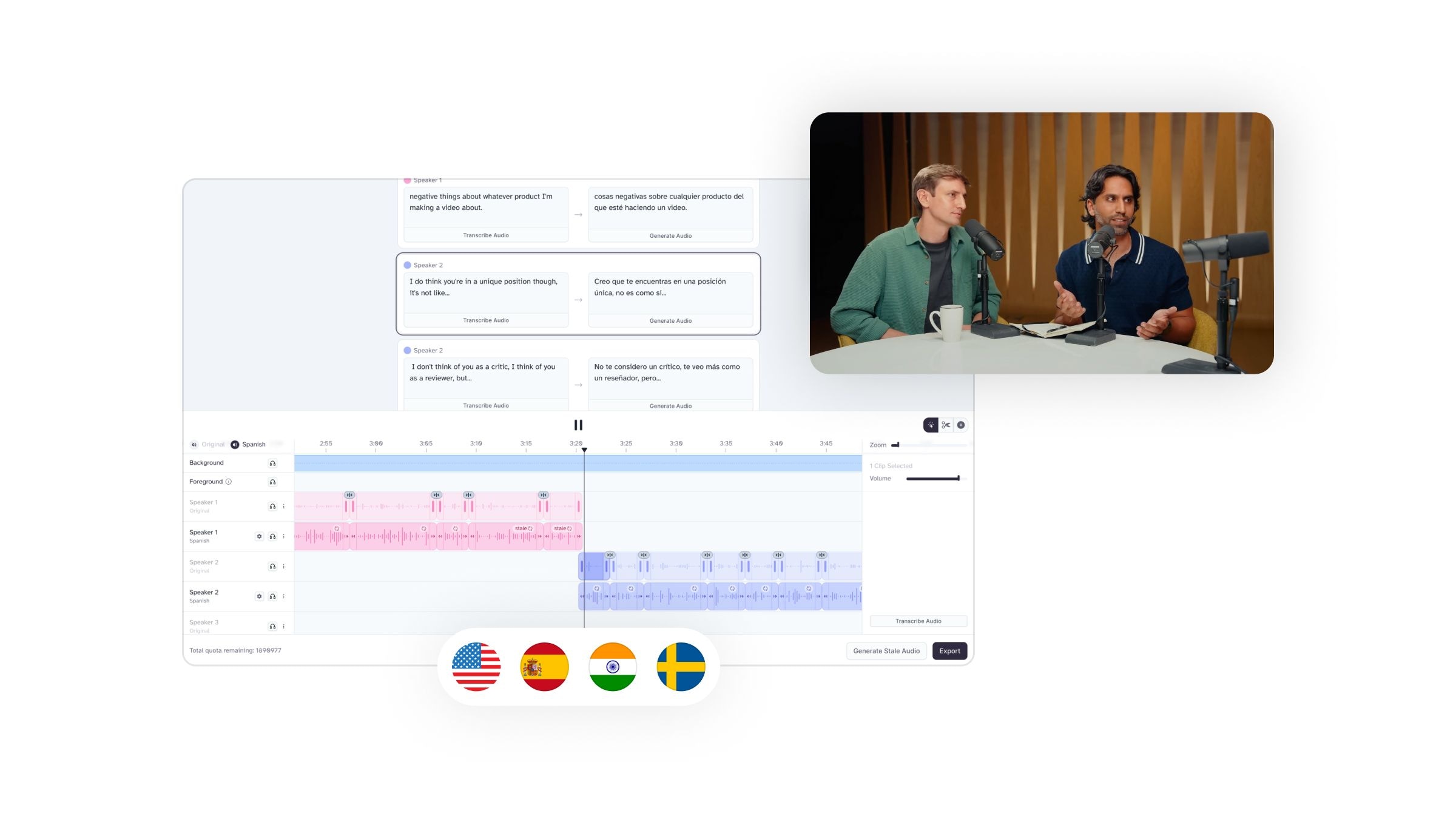

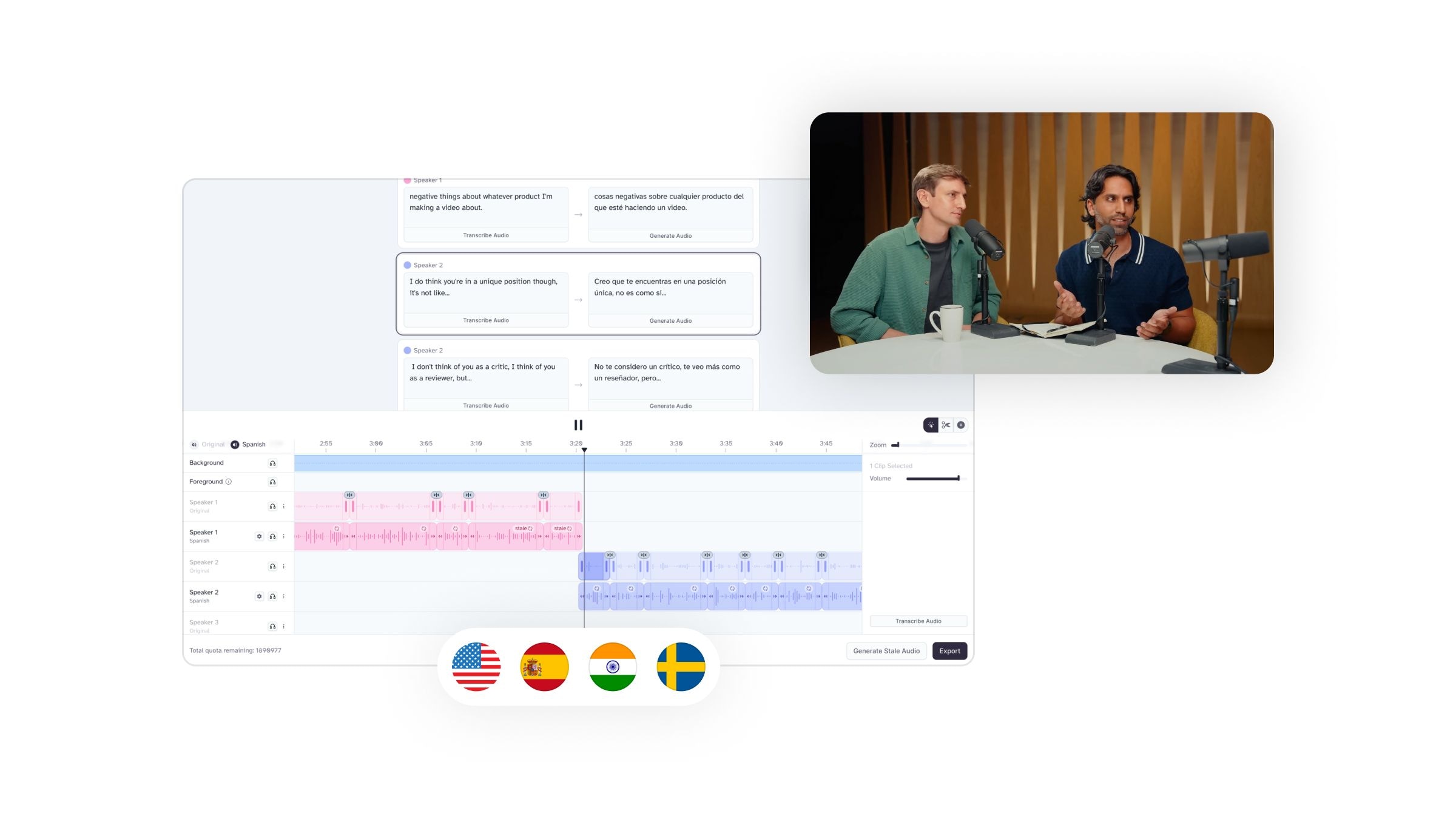

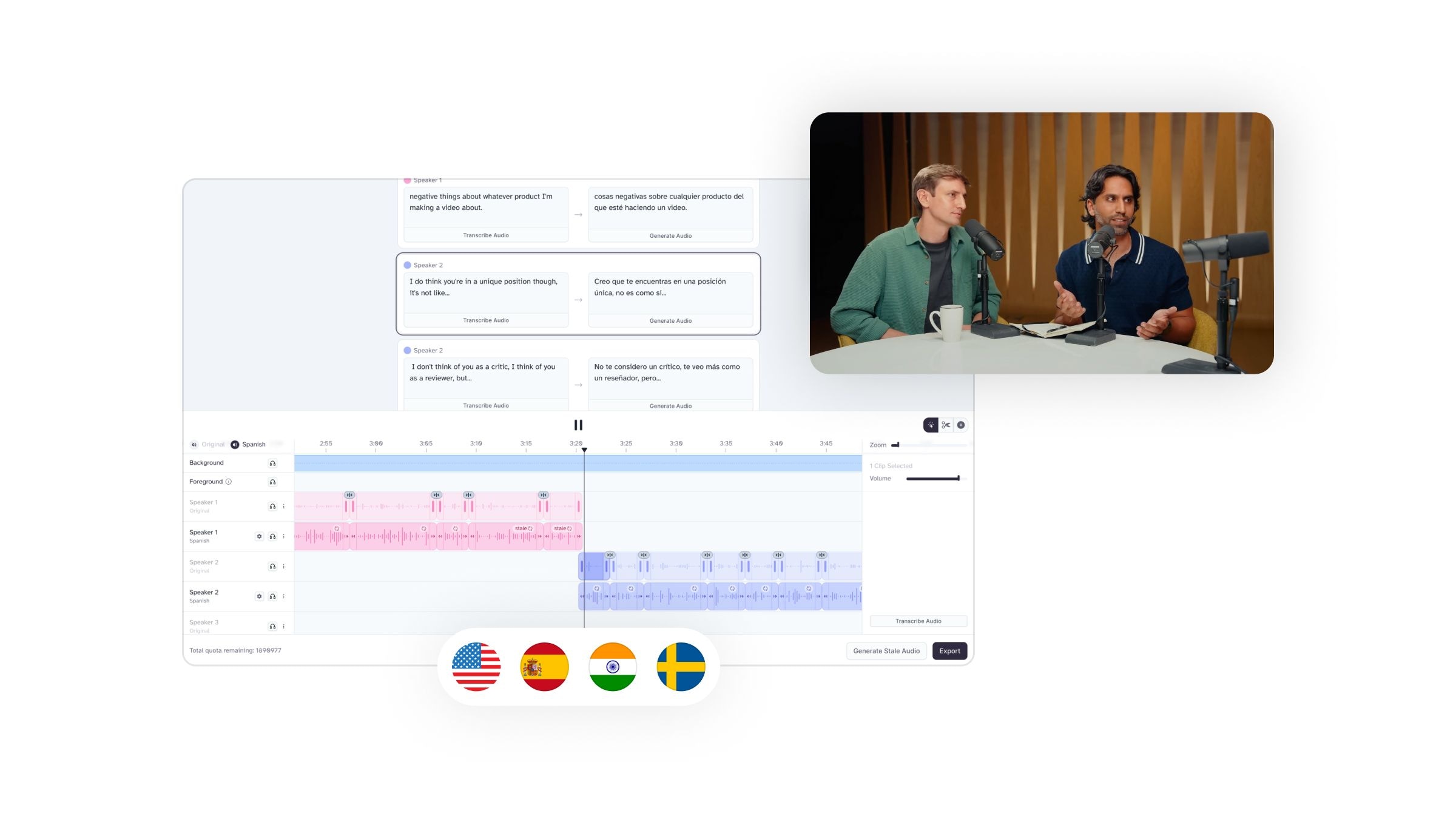

Übersetzen Sie Audio und Video, während Sie die Emotion, das Timing, den Ton und die einzigartigen Merkmale jedes Sprechers bewahren

Unter Sprachsynchronisation versteht man den Prozess, bei dem der Originaldialog eines Films oder Videos durch neue Audios ersetzt wird. In der Film- und Videoproduktion wird Synchronisation meist zu Übersetzungszwecken eingesetzt, um einen Film oder eine TV-Serie in die Muttersprache des Zielpublikums zu übersetzen.

Unter Synchronisation versteht man den Vorgang, den Originaldialog eines Films oder Videos durch neuen Ton zu ersetzen. Bei der Film- und Videoerstellung wird die Synchronisation normalerweise zu Übersetzungszwecken durchgeführt, beispielsweise um einen Film oder eine Fernsehserie in die Muttersprache des Zielpublikums zu übersetzen.

Viele Menschen lernen das Konzept der Synchronisation durch Anime (japanische Zeichentrickfilme) kennen, da die meisten beliebten Anime-Serien oft ins Englische und in andere weit verbreitete Sprachen synchronisiert werden. Unter Anime-Fans kommt es häufig zu einer Debatte darüber, was besser ist: „Subs“ (japanischer Originalton mit Untertiteln) oder „Dubs“ (englisch synchronisierte Versionen einer Serie).

Dennoch geht die Synchronisation über japanische Zeichentrickfilme und -serien hinaus und wird sehr häufig bei Filmen, Fernsehserien, Dokumentationen und – in unserer heutigen digitalen Welt – sogar bei YouTube-Videos angewendet.

Obwohl das Synchronisieren visueller Inhalte früher mühsam und akribisch war, konnten die Produzenten dank der Fortschritte in der KI-Technologie (insbesondere bei Tools zur Sprachgenerierung) viele der zeit- und kostenintensiven Schritte umgehen und innerhalb von Minuten qualitativ hochwertige Synchronisationen erstellen.

Übersetzen Sie Audio und Video, während Sie die Emotion, das Timing, den Ton und die einzigartigen Merkmale jedes Sprechers bewahren

Wie verändert KI den Synchronisationsprozess?

Vor dem Einsatz (und der breiten Verfügbarkeit) der KI-Technologie galt die Synchronisation als relativ langwieriger und kostspieliger Prozess. Produzenten und Kreative müssen Synchronsprecher finden, Vorsprechen veranstalten, die am besten geeigneten Sprecher für die Rollen engagieren und mit den Synchronsprechern zusammenarbeiten, um von Grund auf eine Synchronisation zu erstellen.

Zu diesem Prozess gehörten langes Sitzen bei Vorsprechen, sorgfältige Entscheidungsfindung, sorgfältige Arbeit bei der Übersetzung des Drehbuchs und langwierige Sitzungen zur Sprachaufzeichnung.

Stellen Sie sich nun vor, dass dieser Prozess für jeden Synchronsprecher, der angeheuert wird, um eine bestimmte Figur zu synchronisieren, identisch wäre – das kostet eine Menge Zeit, Geld und Energie!

Dank der Fortschritte in der künstlichen Intelligenz können Produzenten und Entwickler die meisten dieser Herausforderungen umgehen, indem sie in deutlich kürzerer Zeit qualitativ hochwertige Audiodaten für die Synchronisierung erstellen können.

Doch wie funktioniert dieser Vorgang eigentlich? ElevenLabsbieten Produzenten und Kreativen eine Fülle nützlicher Werkzeuge und Funktionen.

Fortschrittliche KI-gestützte Sprachgenerierung und TTS-Tools wie

Zu diesen Funktionen gehören umfangreiche Stimmenbibliotheken mit verschiedenen Erzähloptionen, anpassbaren Parametern (z. B. Geschwindigkeit, Akzent, Tonfall), Möglichkeiten zum Klonen von Stimmen und, am wichtigsten, ein endgültiges Audio, das von authentischer menschlicher Sprache nicht zu unterscheiden ist.

Künstliche Intelligenz ist zweifellos auf dem Vormarsch, insbesondere im Hinblick auf TTS- und Sprachgenerierungstools wie ElevenLabs. Angetrieben von tiefgehendem maschinellem Lernen und natürlicher Sprachverarbeitung können diese Tools nun menschliche Sprache erkennen, verarbeiten und replizieren, die von der echten nicht zu unterscheiden ist.

Künstliche Intelligenz ist zweifellos auf dem Vormarsch, insbesondere im Hinblick auf TTS und Sprachgenerierungstools wie ElevenLabs. Mithilfe umfassender maschineller Lernverfahren und natürlicher Sprachverarbeitung können diese Tools nun menschliche Sprache erkennen, verarbeiten und nachbilden, sodass sie von der echten Sprache nicht mehr zu unterscheiden ist.

KI-Tools sind kosteneffizient

Stellen Sie sich Folgendes vor: Sie bezahlen einen oder mehrere Synchronsprecher dafür, eine ganze Serie manuell zu synchronisieren. Außerdem zahlen Sie für das Studio (wenn die Arbeit nicht remote erfolgt), erstatten den Synchronsprechern ihre Zeit, auch wenn Wiederholungen erforderlich sind, und suchen möglicherweise nach Ersatz, wenn jemand das Projekt nicht fortsetzen kann. Und das sind nur die Hauptausgaben.

KI-Tools helfen, Zeit zu sparen

Das manuelle Überspielen ist nicht nur teuer, sondern auch zeitaufwändig. Sie müssen ein Team organisieren, Synchronsprecher finden und engagieren, Vorsprechen durchführen, Drehbücher übersetzen, an Neuaufnahmen arbeiten, möglicherweise neue Schauspieler oder Sprecher engagieren, wenn jemand das Projekt verlässt, und dann die synchronisierten Audiodateien an den ursprünglichen Inhalt anpassen.

Mit anderen Worten: Das ist eine Menge Arbeit!

KI-Tools bieten kreative Freiheit

Bei der Produktion von Synchronisationen sollte immer die Originalstimme berücksichtigt werden. Menschen werden nicht von selbst zu Fans von Filmen, Serien, Videospielen oder anderen visuellen Inhalten. Sie entwickeln außerdem eine starke Verbindung zu den Charakteren oder Erzählern, und unverwechselbare Stimmen spielen dabei eine große Rolle.

Es versteht sich von selbst, dass nicht alle Synchronisationen erfolgreich sind, was dazu führen kann, dass die Fans vom Endergebnis enttäuscht sind und manchmal sogar Inhalte boykottieren, weil diese in Bezug auf die Sprachausgabe nicht ihren Erwartungen entsprechen.

Glücklicherweise löst KI dieses Problem, indem sie Produzenten und Entwicklern ermöglicht, KI-Stimmen von Grund auf neu zu erstellen oder eine Technologie zum Klonen von Stimmen zu implementieren, um beim Ändern der Sprache die Originalstimme beizubehalten.

So synchronisieren Sie jedes Video mit ElevenLabs

Wenn das gut klingt, beachten Sie, dass unser KI-Synchronisationstool auch die Stimme und den Stil des ursprünglichen Sprechers in allen Sprachen konsistent hält, Ihr Video automatisch analysiert, um zu erkennen, wann jemand spricht, und die Stimme, Intonation und Sprechdauer anpasst. Außerdem können Sie Transkripte und Übersetzungen manuell bearbeiten, um sicherzustellen, dass Ihr Inhalt korrekt synchronisiert ist.

Abschließende Gedanken

Übersetzungsoptionen sind ein großer Faktor für die Zugänglichkeit und Inhaltserweiterung, doch die Videosynchronisierung kann kostspielig, mühsam und mit Einschränkungen verbunden sein, wenn sie manuell durchgeführt wird.

Glücklicherweise helfen fortschrittliche KI-basierte TTS- und Sprachgenerierungstools wie ElevenLabs Unterhaltungsunternehmen, Produzenten und Inhaltserstellern weltweit dabei, ihre visuellen Inhalte effektiv zu synchronisieren, ohne zusätzliche Kosten zu verursachen und den Synchronisierungsprozess zu optimieren.

Übersetzen Sie Audio und Video, während Sie die Emotion, das Timing, den Ton und die einzigartigen Merkmale jedes Sprechers bewahren

Delivering authentic ad-style videos powered by human-sounding AI voices by ElevenLabs

Italy’s leading property marketplace adds 24/7 voice support with AI

Bereitgestellt von ElevenLabs Agenten