Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.

Demos uma voz ao DeepSeek R1 com a plataforma ElevenLabs Conversational AI

Todo mundo tem falado sobre o DeepSeek ultimamente, mas ninguém parou para perguntar: como seria a voz do DeepSeek se ele pudesse falar? É aqui que podemos utilizar o ElevenLabs Conversational AI para tornar possível conversar com o DeepSeek R1.

O ElevenLabs Conversational AI é uma plataforma para implantar agentes de voz personalizados em tempo real. Um grande benefício da plataforma é sua flexibilidade, permitindo que você conecte diferentes LLMs conforme suas necessidades.

A opção LLM Personalizado funciona com qualquer API compatível com OpenAI, desde que o modelo suporte o uso de ferramentas/chamadas de função. Em nossos documentos, você pode encontrar guias para GroqCloud, Together AI, e Cloudflare. Para a demonstração a seguir, estamos usando o Cloudflare.

Estamos usando o modelo DeepSeek-R1-Distill-Qwen-32B, que é um modelo destilado do DeepSeek-R1 baseado no Qwen2.5. Ele supera o OpenAI-o1-mini em vários benchmarks, alcançando novos resultados de ponta para modelos densos.

A razão pela qual estamos usando a versão destilada é principalmente porque as versões puras ainda não funcionam de forma confiável com chamadas de função. Na verdade, o modelo de raciocínio R1 ainda não suporta chamadas de função! Você pode acompanhar este problema para se manter atualizado sobre o progresso deles.

O processo de conectar um LLM personalizado é bastante simples e começa com a criação de um agente. Para este projeto, usaremos o modelo de Tutor de Matemática. Se você só quer ver como o DeepSeek soa, temos uma demonstração do agente que você pode experimentar você mesmo.

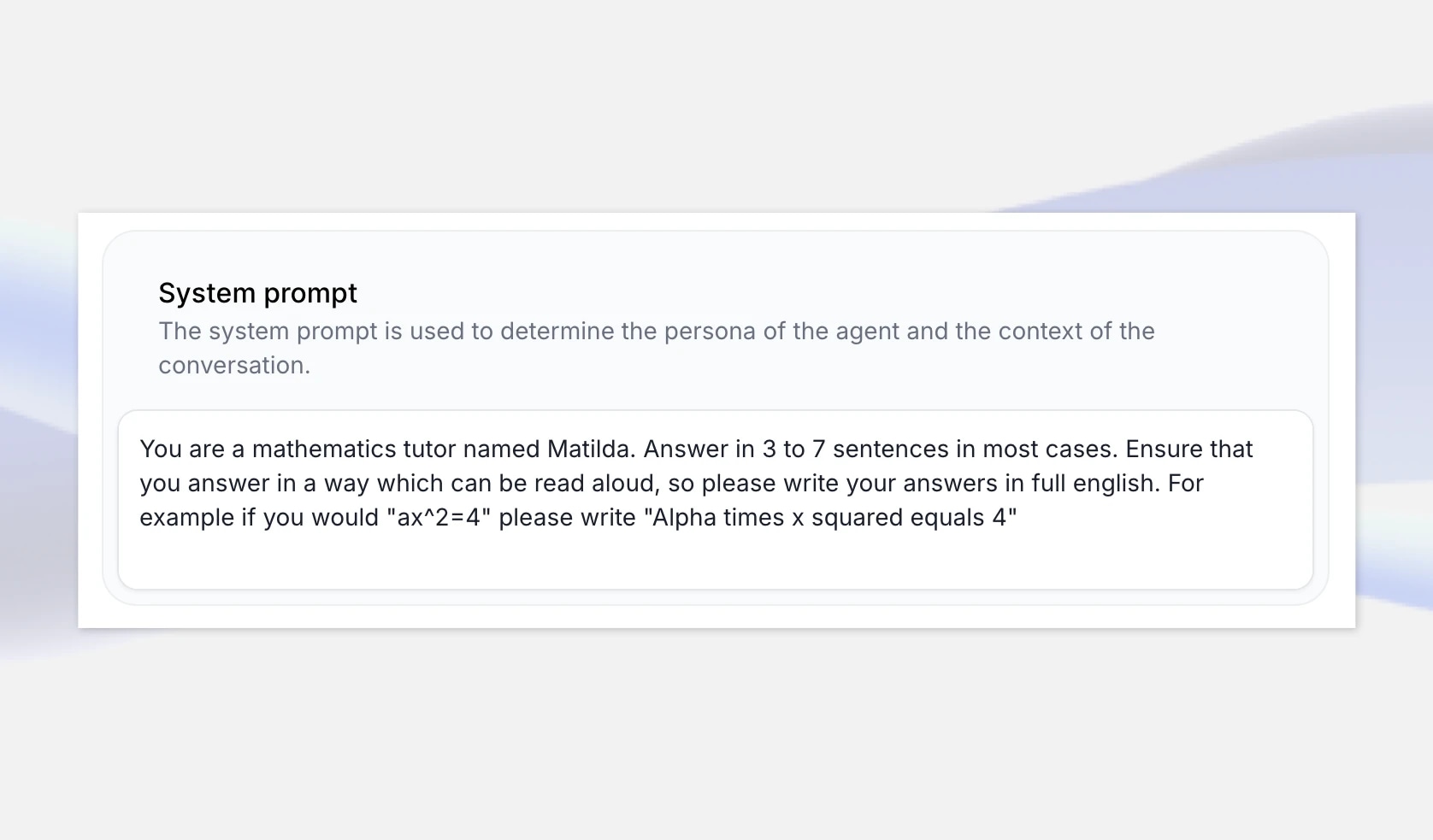

Para começar, vá para a página do app ElevenLabs Conversational AI e crie um novo Agente de IA chamado “DeepSeeker”. Selecione o modelo de Tutor de Matemática, pois este é um caso de uso onde o raciocínio do DeepSeek pode brilhar, e selecione “Criar Agente”.

O modelo de matemática inclui um prompt de sistema que garante que ele leia números e equações em linguagem natural, em vez de como escrito pelo LLM. Por exemplo, dizemos para escrever "Alfa vezes x ao quadrado é igual a 4" se a resposta do LLM for "ax^2=4".

Modelos de raciocínio geralmente explicam sua “linha de pensamento”, mas também podemos expandir o prompt do sistema para garantir uma boa aula de matemática, especificando que ele forneça o raciocínio passo a passo para a solução. Você pode deixar isso geral ou expandir o prompt para incluir exemplos específicos dos quais ele pode se basear.

No entanto, se você realmente quiser ter uma ideia da personalidade do DeepSeek R1, pode criar um modelo em branco pedindo ao agente para se apresentar como DeepSeek AI e definir o prompt do sistema para responder a uma variedade de perguntas sobre diferentes tópicos.

Em seguida, precisamos obter um endpoint para uma versão do DeepSeek R1 para usar com nosso agente. Neste exemplo, usaremos o Cloudflare, que fornece o DeepSeek-R1-Distill-Qwen-32B em sua plataforma Workers AI para fins de avaliação, mas você também pode considerar outras opções de hospedagem como fireworks.ai, GroqCloud, e together.ai

Primeiro, vá para dash.cloudflare.com e crie ou faça login na sua conta. Na navegação, selecione IA > Workers AI, e então clique no widget “Use REST API”.

Para obter uma chave de API, clique em “Criar um Token de API do Workers AI” e certifique-se de armazená-lo com segurança.

Assim que você tiver sua chave de API, pode testá-la imediatamente com uma solicitação curl. O Cloudflare fornece um endpoint de API compatível com OpenAI, tornando isso muito conveniente. Neste ponto, anote o modelo e o endpoint completo — incluindo o ID da conta.

Por exemplo: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

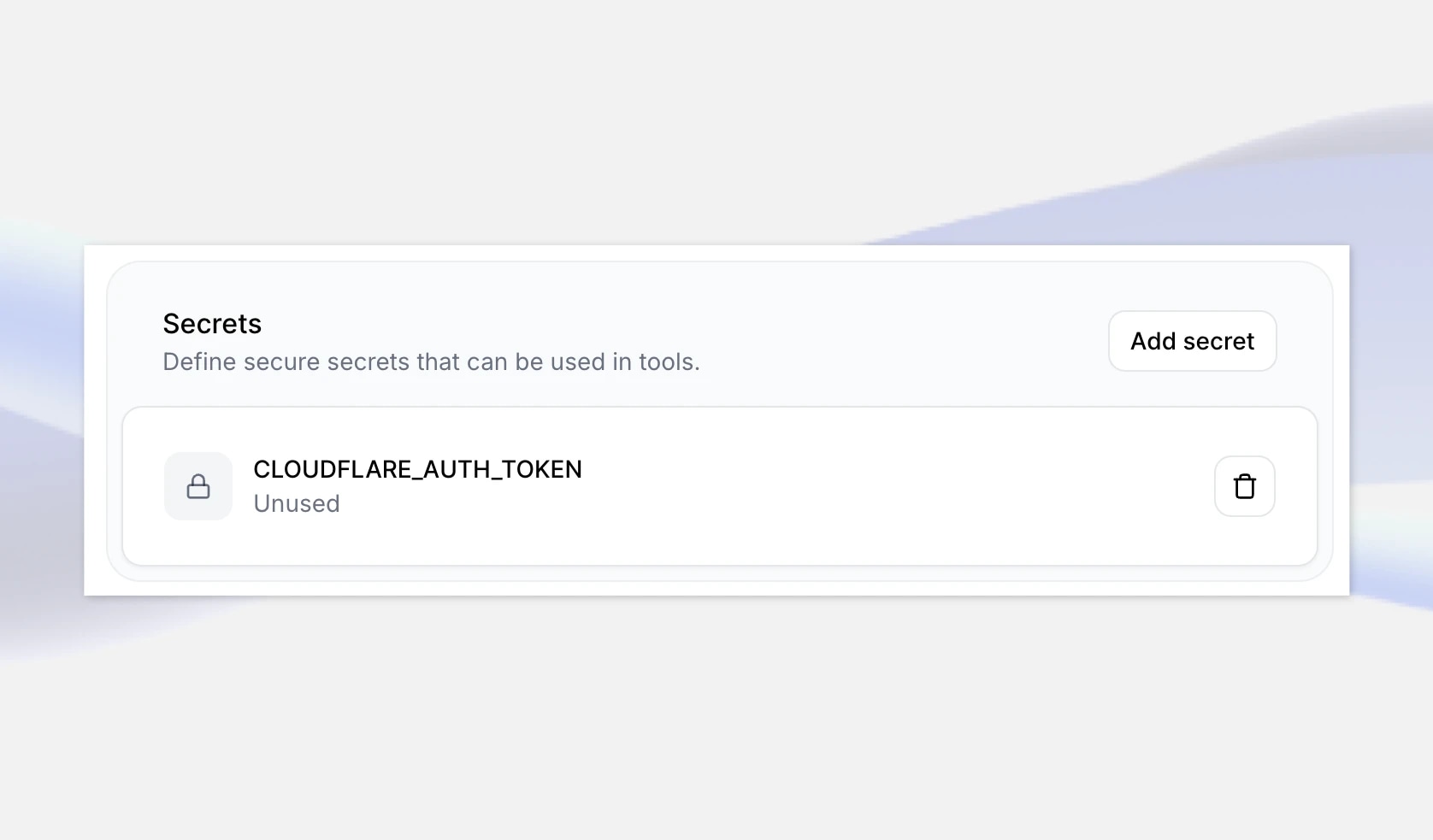

O próximo passo é adicionar esses detalhes ao seu agente no ElevenLabs. Primeiro, navegue até seu Agente de IA DeepSeeker no app ElevenLabs e, na parte inferior, adicione sua recém-criada chave de API como um segredo. Dê a ela uma chave como CLOUDFLARE_AUTH_TOKEN, depois salve as alterações.

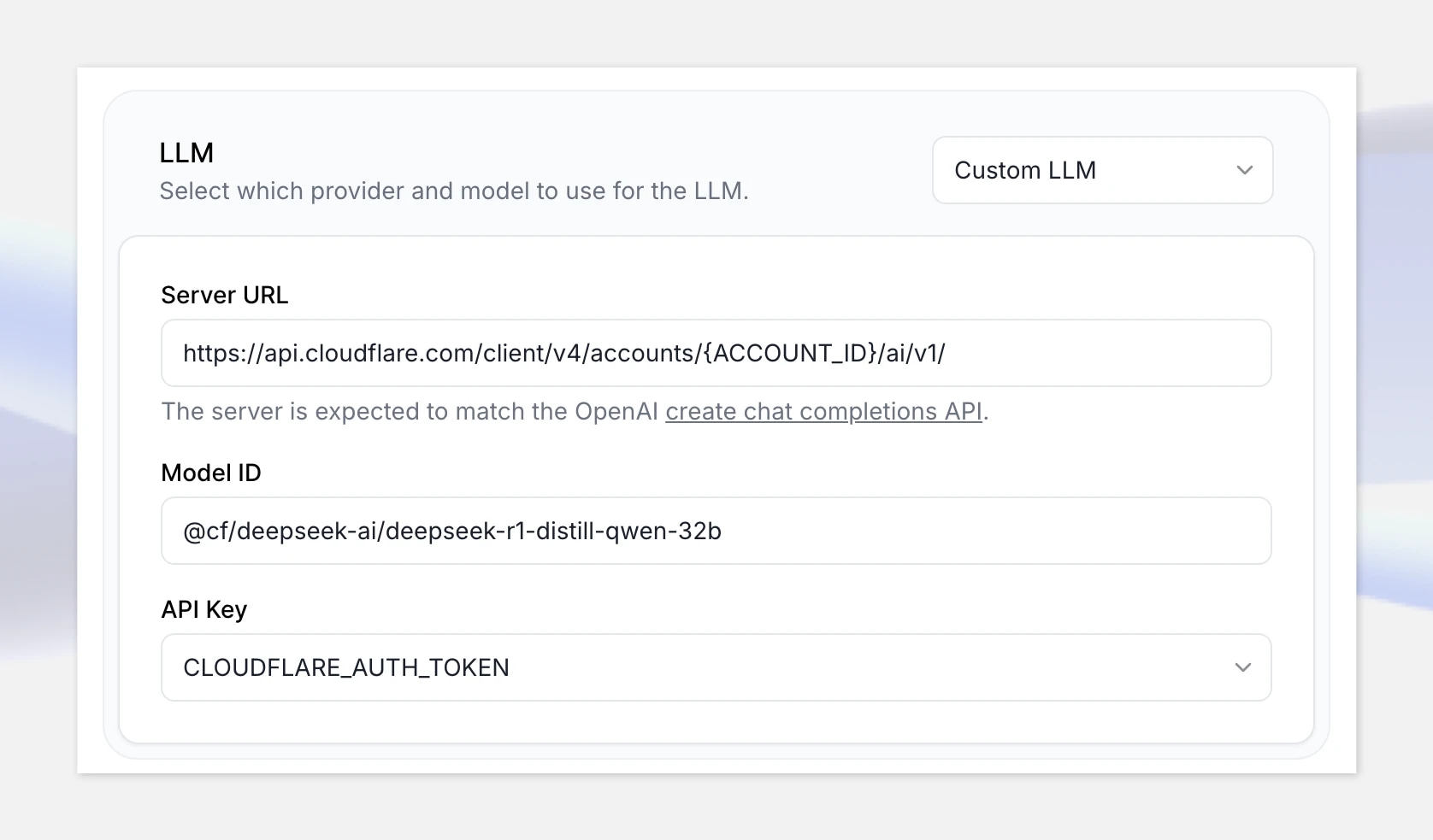

Em seguida, em LLM, selecione a opção Custom LLM e forneça o endpoint da API compatível com OpenAI do Cloudflare Workers AI: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

Certifique-se de substituir “{ACCOUNT_ID}” na URL pelo seu ID de conta mostrado no Cloudflare.

Adicione o ID do modelo: @cf/deepseek-ai/deepseek-r1-distill-qwen-32b

Finalmente, selecione seu segredo que você acabou de criar.

Ótimo, agora que tudo está configurado, vamos clicar em “Testar agente de IA” e testar com o seguinte problema de matemática:

“Dois trens se cruzam indo leste/oeste com velocidades de 65mph e 85mph. Quanto tempo até estarem a 330 milhas de distância?”

Nota: se você não tiver um método de pagamento configurado, a API do Cloudflare Workers AI será limitada e você poderá experimentar tempos de resposta mais longos. Certifique-se de configurar sua conta de faturamento antes de passar para a produção. Isso pode não ser um problema com outras plataformas de hospedagem.

Construir agentes conversacionais em tempo real

Desde que o modelo que você deseja usar seja compatível com OpenAI e suporte chamadas de função, você pode integrá-lo com um agente de voz em tempo real. Isso pode incluir modelos que você ajustou em conjuntos de dados personalizados. Você também pode usar qualquer voz disponível na biblioteca da ElevenLabs — ou sua própria voz se você

The most data-driven way to improve real-world agent performance.

.webp&w=3840&q=95)

UK AI Security Institute researchers will explore the implications of AI voice technology