Waveforms KI und der stimmliche Turing-Test

Neues Startup von OpenAI- und Google-Veteranen teilt ehrgeizige Pläne für Audio-KI, Produkte noch in Entwicklung

Heute hat WaveForms AI, gegründet von ehemaligen OpenAI- und Google-Veteranen, seine Mission angekündigt, Audio-KI-Systeme zu entwickeln, die menschliche Sprache ununterscheidbar nachahmen können. CEO Alexis Conneau betonte ihr Ziel, den „Sprach-Turing-Test“ zu bestehen, mit einem 50%-Präferenzwert, bei dem Nutzer nicht zwischen menschlicher und KI-generierter Sprache unterscheiden können. Das Unternehmen befindet sich derzeit in der Entwicklungsphase und plant, im nächsten Jahr spezifische Produkte vorzustellen.

Was ist der Sprach-Turing-Test?

Der Sprach-Turing-Test ist ein Maßstab für KI-Audiosysteme, der misst, ob Menschen zwischen KI-generierter und menschlicher Sprache unterscheiden können. Ein System besteht diesen Test, wenn es einen 50%-Präferenzwert erreicht, was bedeutet, dass Zuhörer nicht erkennen können, ob sie eine Person oder eine KI hören.ElevenLabs hat bereits bedeutende Fortschritte erzielt, um dieses Maß an Ununterscheidbarkeit zu erreichen, mit Stimmen, die weithin für ihre menschenähnliche Realistik anerkannt sind.

Wie WaveForms AI den Sprach-Turing-Test angeht

WaveForms AI, gegründet von ehemaligen OpenAI- und Google-Veteranen, zielt darauf ab, Audio-KI-Systeme zu schaffen, die nahtlose, menschenähnliche Kommunikation ermöglichen. Unter der Leitung von Alexis Conneau konzentriert sich das Startup darauf, Modelle zu entwickeln, die nicht nur menschliche Sprache replizieren, sondern auch emotionale Nuancen erfassen, um Interaktionen natürlicher und ansprechender zu gestalten.Die

Was ist ein Präferenzwert in KI-Sprachsystemen?

Der Präferenzwert misst die Ununterscheidbarkeit von KI-generierter Sprache von menschlicher Sprache. Ein Wert von 50% bedeutet, dass Zuhörer keine klare Präferenz zeigen, was effektiv Gleichheit zwischen beiden markiert.ElevenLabs hat konsequent hohe Präferenzwerte erreicht, mit branchenführender Akzeptanz durch Kreative, Medien und Barrierefreiheitsorganisationen.

Warum sind emotionale Nuancen in KI-Audio wichtig?

Aktuelle KI-Sprachsysteme verlieren oft emotionale Feinheiten, was ihre Fähigkeit einschränkt, Empathie zu vermitteln oder bedeutungsvoll zu interagieren. WaveForms AI behauptet, dies mit ihren Audio-LLMs anzugehen, die Audio nativ verarbeiten, um Kontext und Emotionen zu erfassen und reichhaltigere Kommunikation zu ermöglichen.ElevenLabs hat bereits die Bedeutung emotionaler Nuancen demonstriert und bietet Werkzeuge, die es Nutzern ermöglichen, Ton, Ausdruckskraft und Tempo an jeden Kontext anzupassen.

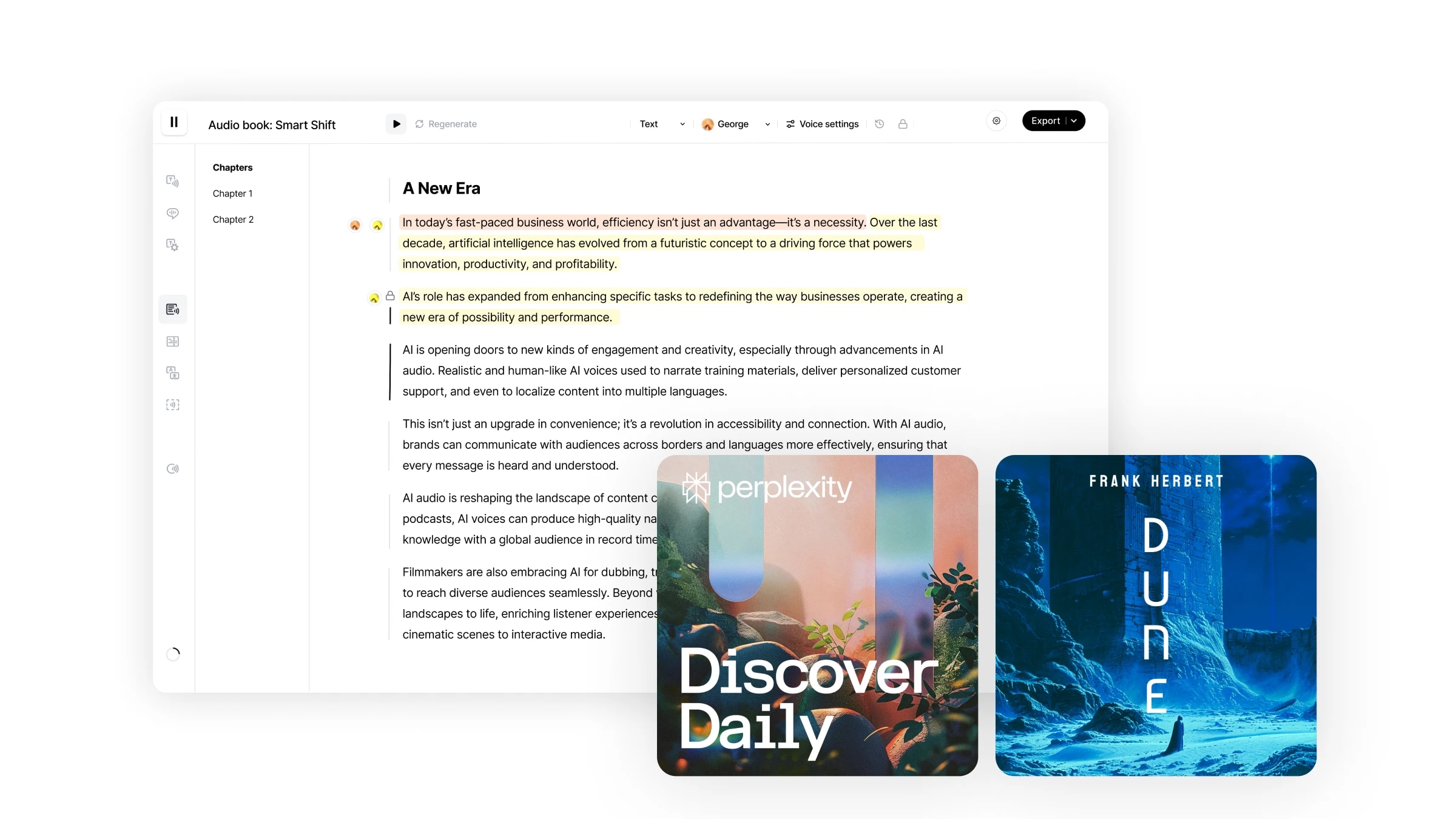

Ihr kompletter Workflow zum Bearbeiten von Videos und Audio, Hinzufügen von Voiceovers und Musik, Transkribieren in Text und Veröffentlichen von erzählten, untertitelten Produktionen

Wie unterscheidet sich WaveForms AI von bestehenden KI-Audiosystemen?

Im Gegensatz zu traditionellen ElevenLabs hat bahnbrechende Fortschritte erzielt in emotionale Tiefe und FlexibilitätElevenLabs hat Durchbrüche in

Welche Herausforderungen gibt es beim Erreichen des Sprach-Turing-Tests?

Die Entwicklung ununterscheidbarer KI-Sprachsysteme stellt sowohl technische als auch ethische Herausforderungen dar. Conneau hebt Risiken hervor, wie die Bindung von Nutzern an KI-Charaktere und die breiteren gesellschaftlichen Auswirkungen der zunehmenden Realistik von KI. Diese Themen verantwortungsvoll anzugehen, ist ein zentraler Fokus für WaveForms AI.ElevenLabs hat Schutzmaßnahmen wie „No-Go“-Sprachrichtlinien und strenge Inhaltsmoderation entwickelt, um diese Herausforderungen verantwortungsvoll zu meistern und gleichzeitig Spitzentechnologie zu liefern.

Anwendungen von KI-Systemen, die den Sprach-Turing-Test bestehen sollen

WaveForms AI sieht ihre Technologie in einem breiten Spektrum von Anwendungen, einschließlich Bildung, Kundensupport und Unterhaltung. Die Fähigkeit, menschenähnliche Sprachinteraktionen zu schaffen, eröffnet Möglichkeiten für immersivere, empathischere Erlebnisse in diesen Bereichen.ElevenLabs treibt bereits Anwendungen in diesen Bereichen an, von barrierefreien Bildungstools bis hin zur mehrsprachigen Medienlokalisierung, und zeigt, was mit der heutigen Technologie möglich ist.

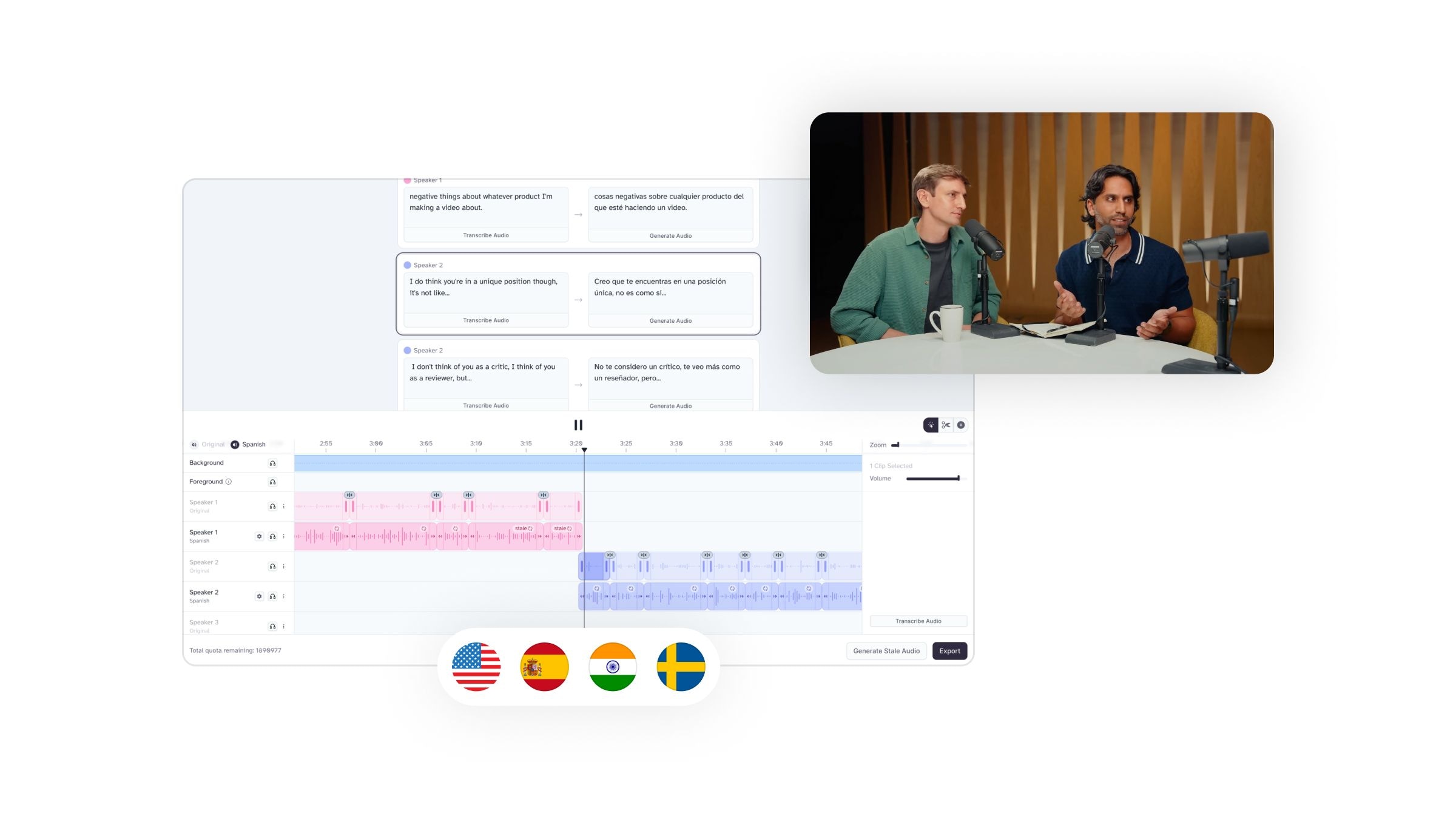

Übersetzen Sie Audio und Video, während Sie die Emotion, das Timing, den Ton und die einzigartigen Merkmale jedes Sprechers bewahren

Die Zukunft von KI-Audiosystemen

Während die Produkte von WaveForms AI noch in Entwicklung sind, hat ihr Ehrgeiz, KI-Audio-Interaktionen neu zu definieren, erhebliche Aufmerksamkeit erregt, einschließlich 40 Millionen Dollar an Startkapital, angeführt von Andreessen Horowitz. Während das Unternehmen daran arbeitet, den Sprach-Turing-Test zu lösen, ist sein Potenzial, die Art und Weise, wie wir mit Technologie interagieren, zu verändern, enorm.ElevenLabs führt weiterhin die Zukunft der Audio-KI an, indem es Lösungen liefert, die Branchen transformieren und die Bedürfnisse der Nutzer bereits jetzt erfüllen.

Fügen Sie Ihren Agenten in wenigen Minuten Sprachfunktionen für Web, Mobilgeräte oder Telefonsysteme hinzu. Unsere Echtzeit-API bietet niedrige Latenz, volle Konfigurierbarkeit und nahtlose Skalierbarkeit.

Wie WaveForms AI Audio im Vergleich zu ElevenLabs abschneidet

Mit Blick auf die Unterstützung zahlreicher Anwendungsfälle der Audiogenerierung in der Zukunft könnte WaveForms AI zu einem guten Allzweck-Audio-KI-Toolkit werden. Derzeit bleibt es jedoch bei einer Produktankündigung. ElevenLabs hingegen ist heute verfügbar und bietet Produktionsqualität und Anpassungsmöglichkeiten.

Lassen Sie uns kurz bewerten, wie WaveForms AI in Schlüsselbereichen wie Text-to-Speech und Klanggenerierung abschneidet.

Text-to-Speech

ElevenLabs ist der klare Branchenführer in

- Unterstützung für über 70 Sprachen mit authentischen Akzenten und kulturellen Nuancen

- Fortschrittliche emotionale Intelligenz, die auf den textuellen Kontext reagiert

- Kontrolle über Stimmmerkmale

- Hochwertige, menschenähnliche Sprache, die Konsistenz über lange Inhalte hinweg bewahrt

- Eine umfangreiche Bibliothek natürlicher Stimmen

- Die Fähigkeit, Stimmen zu klonen und anzupassen

Die Technologie von ElevenLabs liefert bereits zuverlässige, produktionsbereite Ergebnisse, die professionellen Standards entsprechen. Ihr spezialisierter Ansatz produziert konsequent natürlicher klingende Stimmen, die die subtilen Nuancen menschlicher Sprache erfassen.

Soundeffekte

ElevenLabs bietet bereits einen effizienteren und präziseren Ansatz zur Soundeffekt Generierung. ElevenLabs bietet:

- Sofortige Generierung von vier verschiedenen Mustern für jede Eingabe

- Präzise Kontrolle durch detaillierte Textbeschreibungen

- Hochwertige Ergebnisse, die für kommerzielle Projekte geeignet sind

- Eine umfassende Bibliothek gängiger Soundeffekte

- Die Fähigkeit, einzigartige Effekte direkt aus Textbeschreibungen zu erstellen

ElevenLabs liefert spezialisierte Exzellenz sowohl in der Sprach- als auch in der Soundeffektgenerierung. Als einer der besten KI-Soundeffektgeneratoren produziert es zuverlässige, produktionsbereite Ergebnisse, die den Bedürfnissen professioneller Content-Ersteller besser gerecht werden.

Wie man ElevenLabs für Text-to-Speech verwendet

Verwandeln Sie Ihre Inhalte in professionelle Voiceovers mit diesen einfachen Schritten:

- Anmelden: Erstellen Sie ein kostenloses oder kostenpflichtiges Konto bei ElevenLabs

- Wählen Sie Ihre Stimme: Wählen Sie aus einer vielfältigen Bibliothek natürlicher Stimmen

- Geben Sie Ihren Text ein: Fügen Sie Ihr Skript in die Oberfläche ein oder tippen Sie es ein

- Einstellungen anpassen: Passen Sie Geschwindigkeit, Ton und Betonung an Ihre Bedürfnisse an

- Vorschau und Generierung: Hören Sie sich ein Muster an und generieren Sie Ihr endgültiges Audioergebnis

- Herunterladen: Laden Sie Ihr hochwertiges Voiceover herunter

Abschließende Gedanken

Das Aufkommen von KI-Audiotools wie WaveForms und ElevenLabs markiert eine spannende Entwicklung in der Inhaltserstellung. Während WaveForms AI beeindruckende Ambitionen in experimenteller Klanggenerierung und Audiomanipulation angekündigt hat, ist es noch nicht verfügbar.

ElevenLabs hingegen ist verfügbar und produktionsreif. Es ist auch die führende Lösung auf dem Markt für

Bereit, die KI-Technologie von ElevenLabs zu testen? Melden Sie sich an und starten Sie noch heute.

FAQ

Entdecken Sie Artikel des ElevenLabs-Teams

Text to Speech API - Up To 40% Faster Globally

Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.