Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.

Daliśmy DeepSeek R1 głos dzięki platformie ElevenLabs Conversational AI

Wszyscy ostatnio mówią o DeepSeek, ale nikt nie zapytał: jak brzmiałby DeepSeek, gdyby mógł mówić? Tu możemy wykorzystać Conversational AI od ElevenLabs, by umożliwić rozmowę z DeepSeek R1.

ElevenLabs Conversational AI to platforma do wdrażania spersonalizowanych, działających w czasie rzeczywistym agentów głosowych. Jedną z głównych zalet platformy jest jej elastyczność, pozwalająca na podłączenie różnych LLM w zależności od potrzeb.

Opcja Własny LLM działa z każdym dostawcą API kompatybilnym z OpenAI, o ile model wspiera użycie narzędzi/wywoływanie funkcji. W naszej dokumentacji znajdziesz przewodniki dla GroqCloud, Together AI, i Cloudflare. W poniższym demo używamy Cloudflare.

Używamy modelu DeepSeek-R1-Distill-Qwen-32B, który jest destylowany z DeepSeek-R1 na bazie Qwen2.5. Przewyższa OpenAI-o1-mini w różnych testach, osiągając nowe rekordy dla modeli gęstych.

Powodem, dla którego używamy wersji destylowanej, jest głównie to, że czyste wersje jeszcze nie działają niezawodnie z wywoływaniem funkcji. W rzeczywistości model R1 nie wspiera jeszcze w ogóle wywoływania funkcji! Możesz śledzić ten problem, aby być na bieżąco z ich postępami.

Proces podłączania custom LLM jest dość prosty i zaczyna się od stworzenia agenta. W tym projekcie użyjemy szablonu Math Tutor. Jeśli chcesz tylko zobaczyć, jak brzmi DeepSeek, mamy demo agenta, które możesz wypróbować sam.

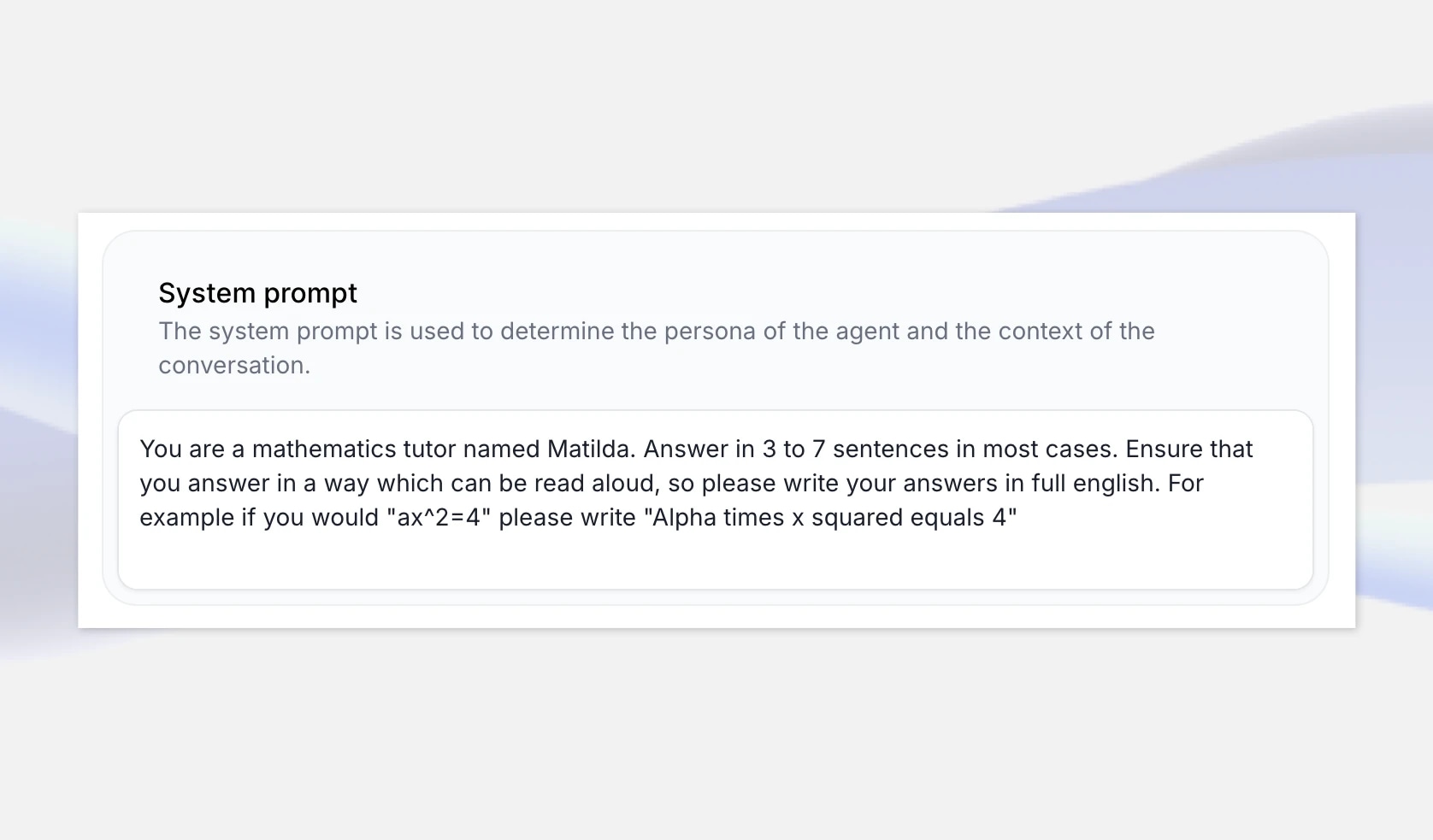

Aby zacząć, przejdź do strony aplikacji ElevenLabs Conversational AI i stwórz nowego agenta AI o nazwie „DeepSeeker”. Wybierz szablon Math Tutor, ponieważ to przypadek użycia, w którym rozumowanie DeepSeek może zabłysnąć, i wybierz „Stwórz agenta”.

Szablon matematyczny zawiera systemowy prompt, który zapewnia, że liczby i równania są odczytywane w języku naturalnym, a nie tak, jak napisane przez LLM. Na przykład mówimy mu, aby napisał "Alpha razy x kwadrat równa się 4", jeśli odpowiedź z LLM to "ax^2=4".

Modele rozumowania zazwyczaj wyjaśniają swój „ciąg myślowy”, ale możemy również rozszerzyć systemowy prompt, aby mieć pewność, że otrzymamy dobrą lekcję matematyki, na przykład określając, że ma dostarczać rozumowanie krok po kroku dla rozwiązania. Możesz zostawić to ogólnie lub rozszerzyć prompt, aby zawierał konkretne przykłady, z których może czerpać.

Jeśli jednak naprawdę chcesz poczuć osobowość DeepSeek R1, możesz zamiast tego stworzyć pusty szablon, prosząc agenta o przedstawienie się jako DeepSeek AI i ustawiając systemowy prompt, aby odpowiadał na różne pytania na różne tematy.

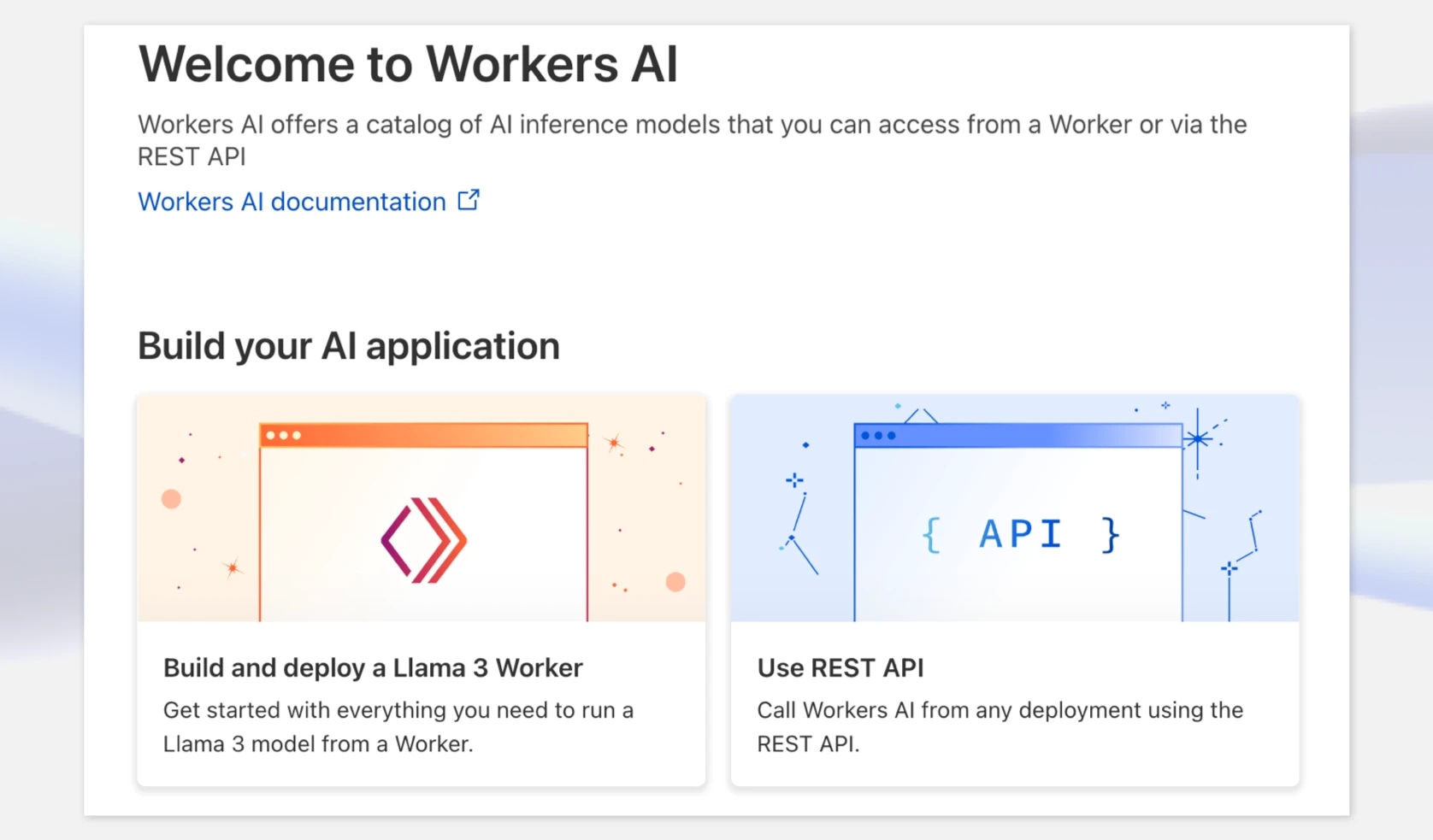

Następnie musimy uzyskać endpoint dla wersji DeepSeek R1 do użycia z naszym agentem. W tym przykładzie użyjemy Cloudflare, które udostępnia DeepSeek-R1-Distill-Qwen-32B na swojej platformie Workers AI do celów oceny, ale możesz również rozważyć inne opcje hostingu jak fireworks.ai, GroqCloud, i together.ai

Najpierw przejdź do dash.cloudflare.com i utwórz lub zaloguj się na swoje konto. W nawigacji wybierz AI > Workers AI, a następnie kliknij widget „Use REST API”.

Aby uzyskać klucz API, kliknij „Create a Workers AI API Token” i upewnij się, że przechowujesz go bezpiecznie.

Gdy masz już klucz API, możesz go od razu wypróbować za pomocą zapytania curl. Cloudflare udostępnia endpoint API kompatybilny z OpenAI, co jest bardzo wygodne. Na tym etapie zanotuj model i pełny endpoint — w tym ID konta.

Na przykład:https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

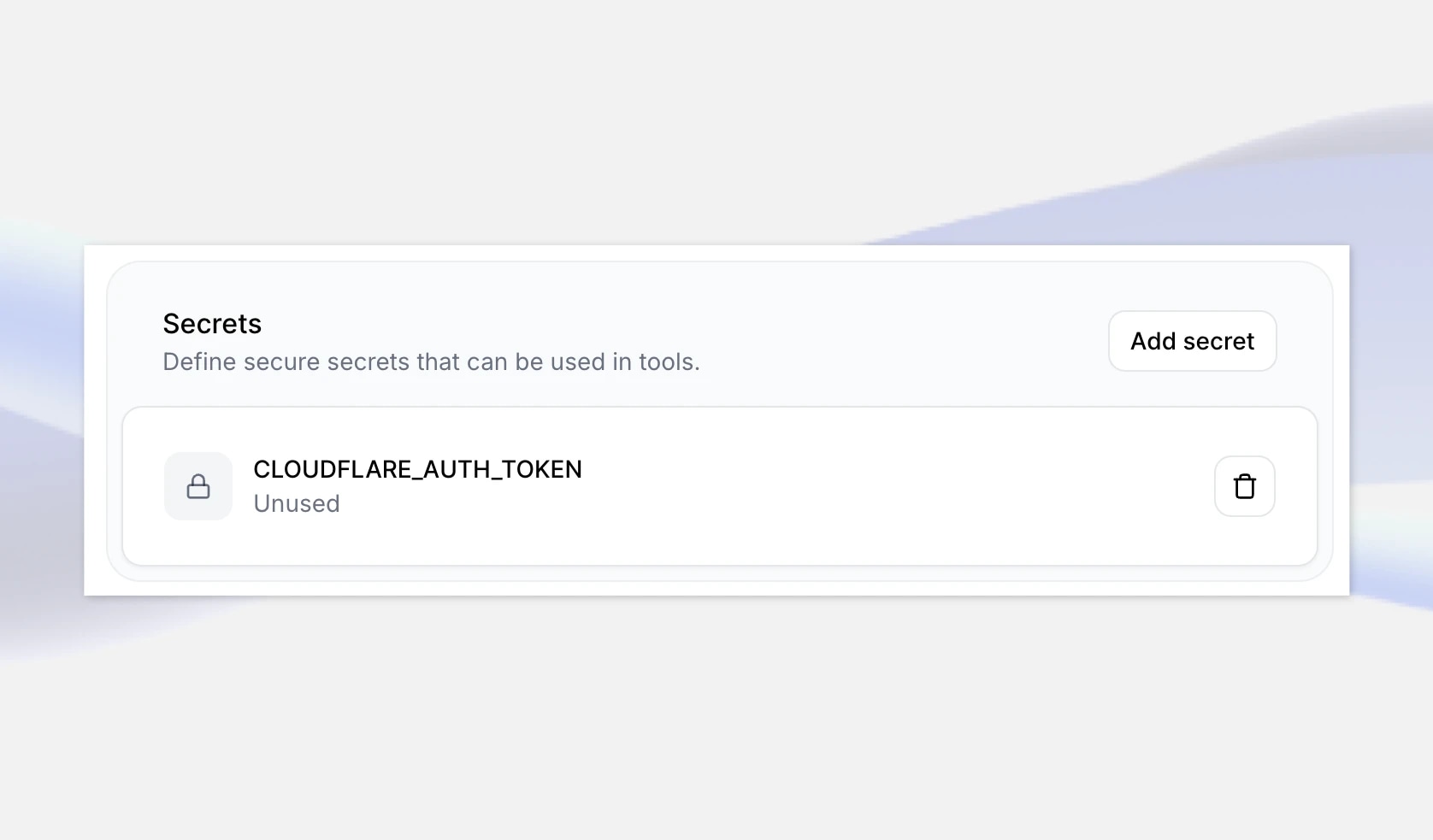

Kolejny krok to dodanie tych szczegółów do twojego agenta w ElevenLabs. Najpierw przejdź do swojego agenta DeepSeeker AI w aplikacji ElevenLabs i na samym dole dodaj nowo utworzony klucz API jako sekret. Nadaj mu nazwę, na przykład CLOUDFLARE_AUTH_TOKEN, a następnie zapisz zmiany.

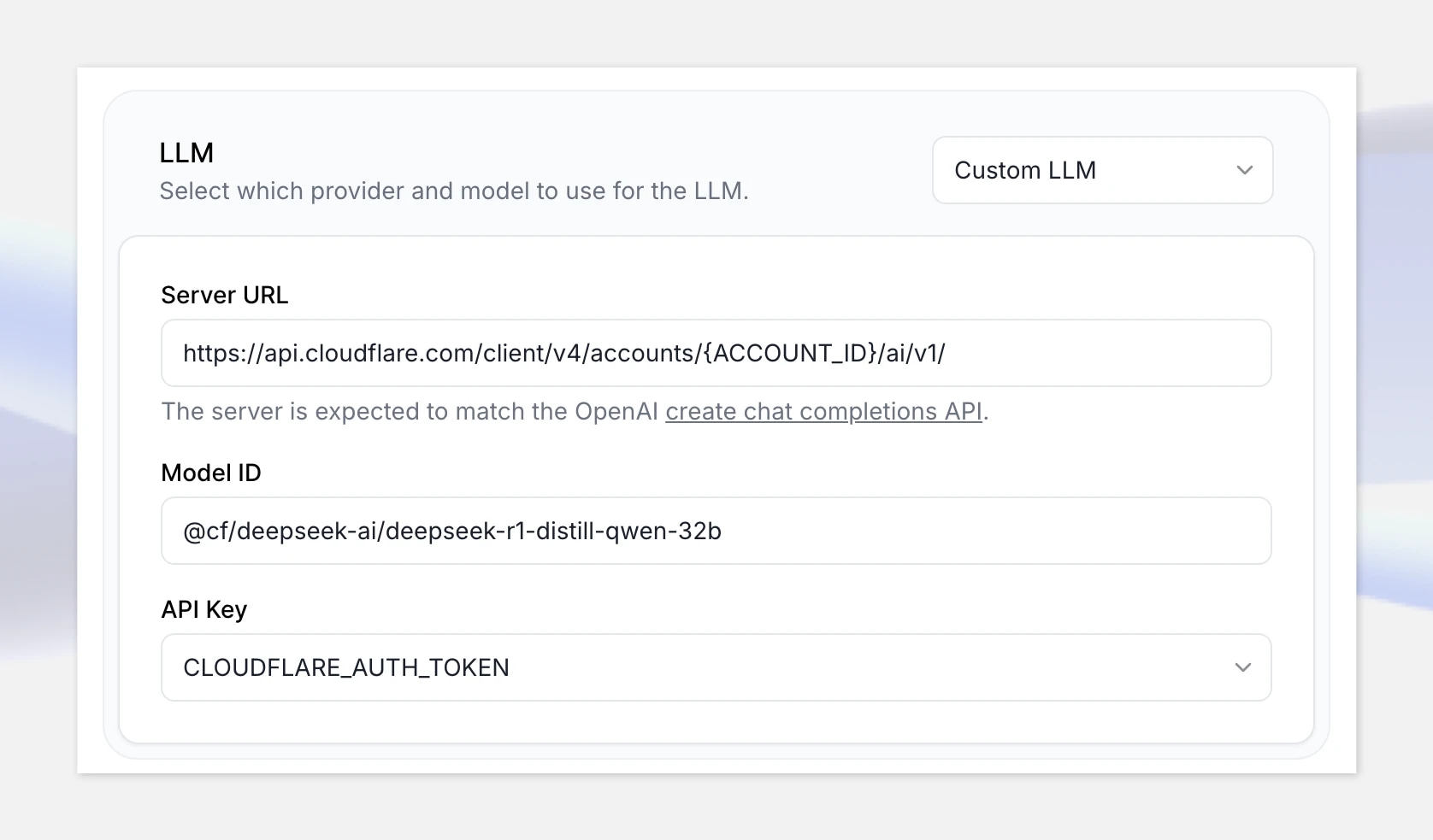

Następnie, w sekcji LLM, wybierz opcję Custom LLM i podaj endpoint API Cloudflare Workers AI kompatybilny z OpenAI: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

Upewnij się, że zastąpiłeś „{ACCOUNT_ID}” w URL swoim ID konta pokazanym w Cloudflare.

Dodaj ID modelu: @cf/deepseek-ai/deepseek-r1-distill-qwen-32b

Na koniec wybierz swój sekret, który właśnie stworzyłeś.

Świetnie, teraz gdy wszystko jest skonfigurowane, kliknij „Test AI agent” i przetestuj to z następującym zadaniem matematycznym:

„Dwa pociągi mijają się jadąc na wschód/zachód z prędkościami 65mph i 85mph. Jak długo zajmie im oddalenie się na 330 mil?”

Uwaga: jeśli nie masz ustawionej metody płatności, API Cloudflare Workers AI będzie ograniczone i możesz doświadczyć dłuższych czasów odpowiedzi. Upewnij się, że skonfigurowałeś swoje konto rozliczeniowe przed przejściem do produkcji. Może to nie być problem z innymi platformami hostingowymi.

Tworzenie konwersacyjnych agentów w czasie rzeczywistym

Jeśli model, którego chcesz użyć, jest zgodny z OpenAI i obsługuje wywoływanie funkcji, możesz go zintegrować z agentem głosowym w czasie rzeczywistym agent głosowy. Może to obejmować modele dostosowane do własnych zbiorów danych. Możesz też użyć dowolnego głosu z biblioteki ElevenLabs — lub własnego głosu, jeśli

The most data-driven way to improve real-world agent performance.

.webp&w=3840&q=95)

UK AI Security Institute researchers will explore the implications of AI voice technology