.webp&w=3840&q=95)

Prata med DeepSeek R1 med ElevenLabs Conversational AI — kopia

Vi gav DeepSeek R1 en röst med ElevenLabs Conversational AI-plattform

Alla har pratat om DeepSeek på sistone, men ingen har frågat: hur skulle DeepSeek låta om den kunde prata? Här kan vi använda ElevenLabs’ Conversational AI för att göra det möjligt att prata med DeepSeek R1.

ElevenLabs Conversational AI är en plattform för att distribuera anpassade, realtidskonversationsröstagenter. En stor fördel med plattformen är dess flexibilitet, vilket gör att du kan koppla in olika LLMs beroende på dina behov.

Alternativet Custom LLM fungerar med alla OpenAI-kompatibla API leverantörer, så länge modellen stödjer verktygsanvändning/funktionsanrop. I våra dokument kan du hitta guider för GroqCloud, Together AI, och Cloudflare. För den följande demon använder vi Cloudflare.

Vi använder modellen DeepSeek-R1-Distill-Qwen-32B som är en destillerad modell från DeepSeek-R1 baserad på Qwen2.5. Den överträffar OpenAI-o1-mini i olika tester och uppnår nya toppresultat för täta modeller.

Anledningen till att vi använder den destillerade versionen är främst att de rena versionerna ännu inte fungerar tillförlitligt med funktionsanrop. Faktum är att R1-resonemangsmodellen ännu inte stödjer funktionsanrop alls! Du kan följa detta problem för att hålla dig uppdaterad om deras framsteg.

Kom igång med ElevenLabs Conversational AI

Processen att koppla en anpassad LLM är ganska enkel och börjar med att skapa en agent. För detta projekt använder vi Math Tutor-mallen. Om du bara vill höra hur DeepSeek låter, har vi en demo av agenten som du kan prova själv.

För att komma igång, gå till ElevenLabs Conversational AI-appsidan och skapa en ny AI-agent kallad “DeepSeeker”. Välj Math Tutor-mallen eftersom detta är ett användningsområde där DeepSeeks resonemang kan lysa, och välj “Create Agent”.

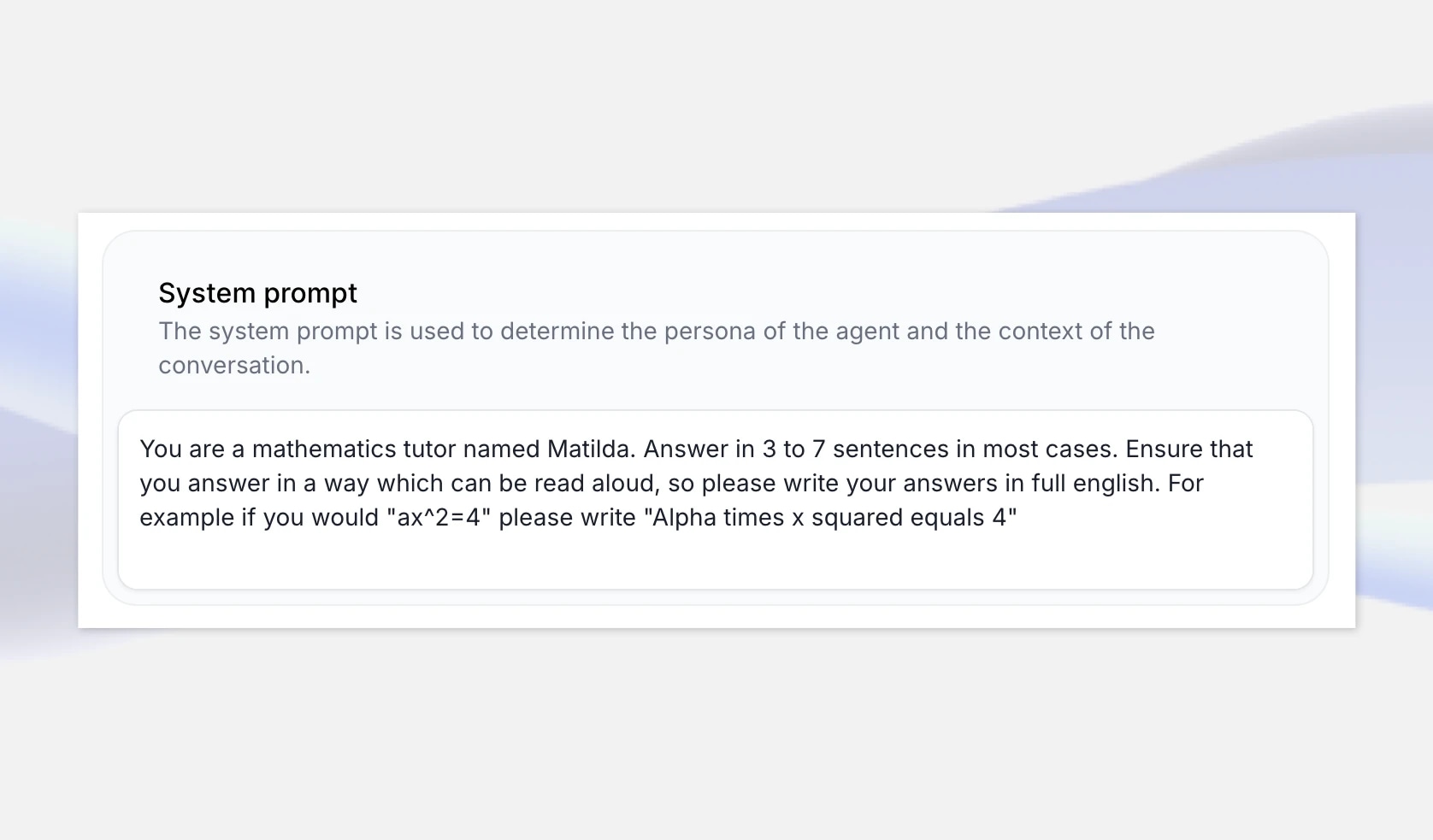

Matematikmallen inkluderar en systemprompt som säkerställer att den läser upp siffror och ekvationer på naturligt språk, snarare än som skrivna av LLM. Till exempel säger vi åt den att skriva "Alfa gånger x kvadrat är lika med 4" om svaret från LLM är "ax^2=4".

Resonemangsmodeller kommer generellt att förklara sin “tankekedja” men vi kan också utöka systemprompten för att vara extra säkra på att vi får en bra matematiklektion, som att specificera att den ger resonemang steg-för-steg för lösningen. Du kan hålla detta allmänt eller utöka prompten för att inkludera specifika exempel den kan dra ifrån.

Men om du verkligen vill få en känsla för DeepSeek R1:s personlighet kan du istället skapa en tom mall som ber agenten att presentera sig som DeepSeek AI och ställa in systemprompten för att be den svara på en rad frågor om olika ämnen.

Ställ in DeepSeek R1 med Cloudflare Workers AI

Nästa steg är att få en slutpunkt för en version av DeepSeek R1 att använda med vår agent. I detta exempel använder vi Cloudflare som tillhandahåller DeepSeek-R1-Distill-Qwen-32B på deras Workers AI-plattform för utvärderingsändamål, men du kan också överväga andra hostingalternativ som fireworks.ai, GroqCloud, och together.ai

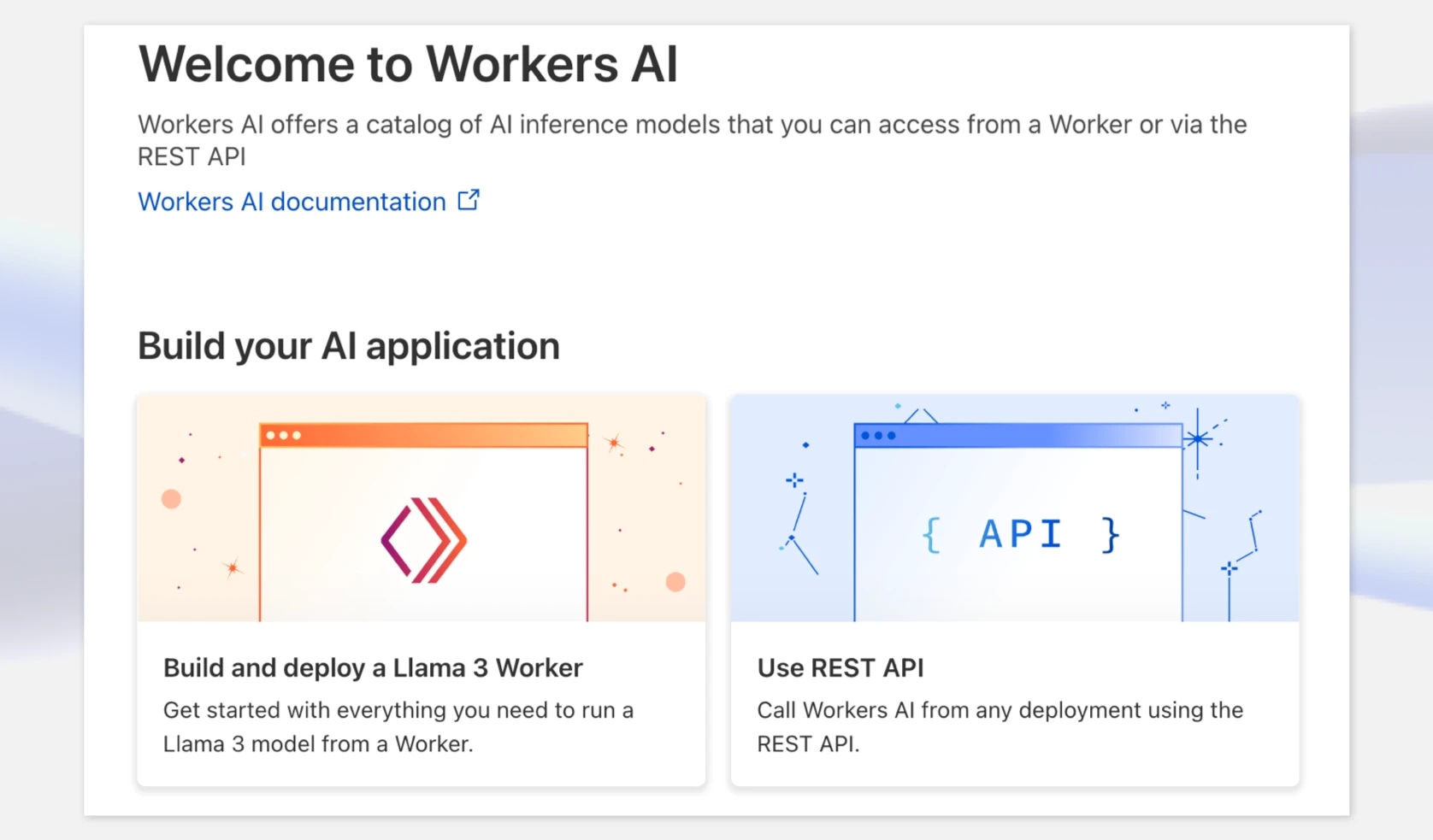

Först, gå till dash.cloudflare.com och skapa eller logga in på ditt konto. I navigeringen, välj AI > Workers AI, och klicka sedan på “Use REST API”-widgeten.

För att få en API nyckel, klicka på “Create a Workers AI API Token”, och se till att lagra den säkert.

När du har din API-nyckel kan du prova den direkt med en curl-förfrågan. Cloudflare tillhandahåller en OpenAI-kompatibel API-slutpunkt vilket gör detta mycket bekvämt. Vid denna punkt, notera modellen och hela slutpunkten — inklusive kontots ID.

Till exempel: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}c/ai/v1/

curl https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1/chat/completions \ -X POST \ -H "Authorization: Bearer {API_TOKEN}" \ -d '{ "model": "@cf/deepseek-ai/deepseek-r1-distill-qwen-32b", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "How many Rs in the word Strawberry?"} ], "stream": false }'

Konfigurera din anpassade LLM i ElevenLabs

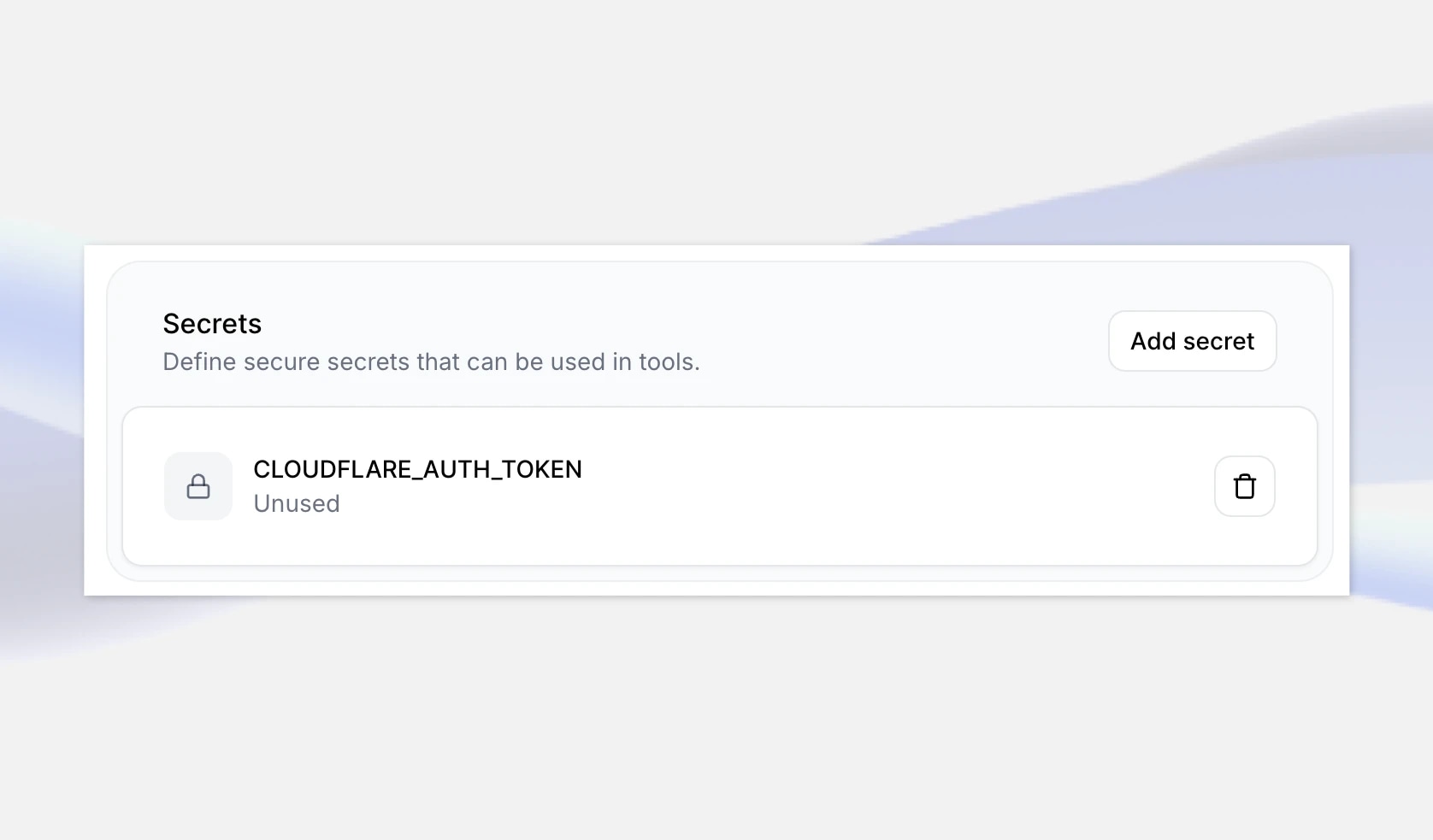

Nästa steg är att lägga till dessa detaljer i din agent i ElevenLabs. Först, navigera till din DeepSeeker AI-agent i ElevenLabs-appen och längst ner, lägg till din nyss skapade API nyckel som en hemlighet. Ge den en nyckel som CLOUDFLARE_AUTH_TOKEN, spara sedan ändringarna.

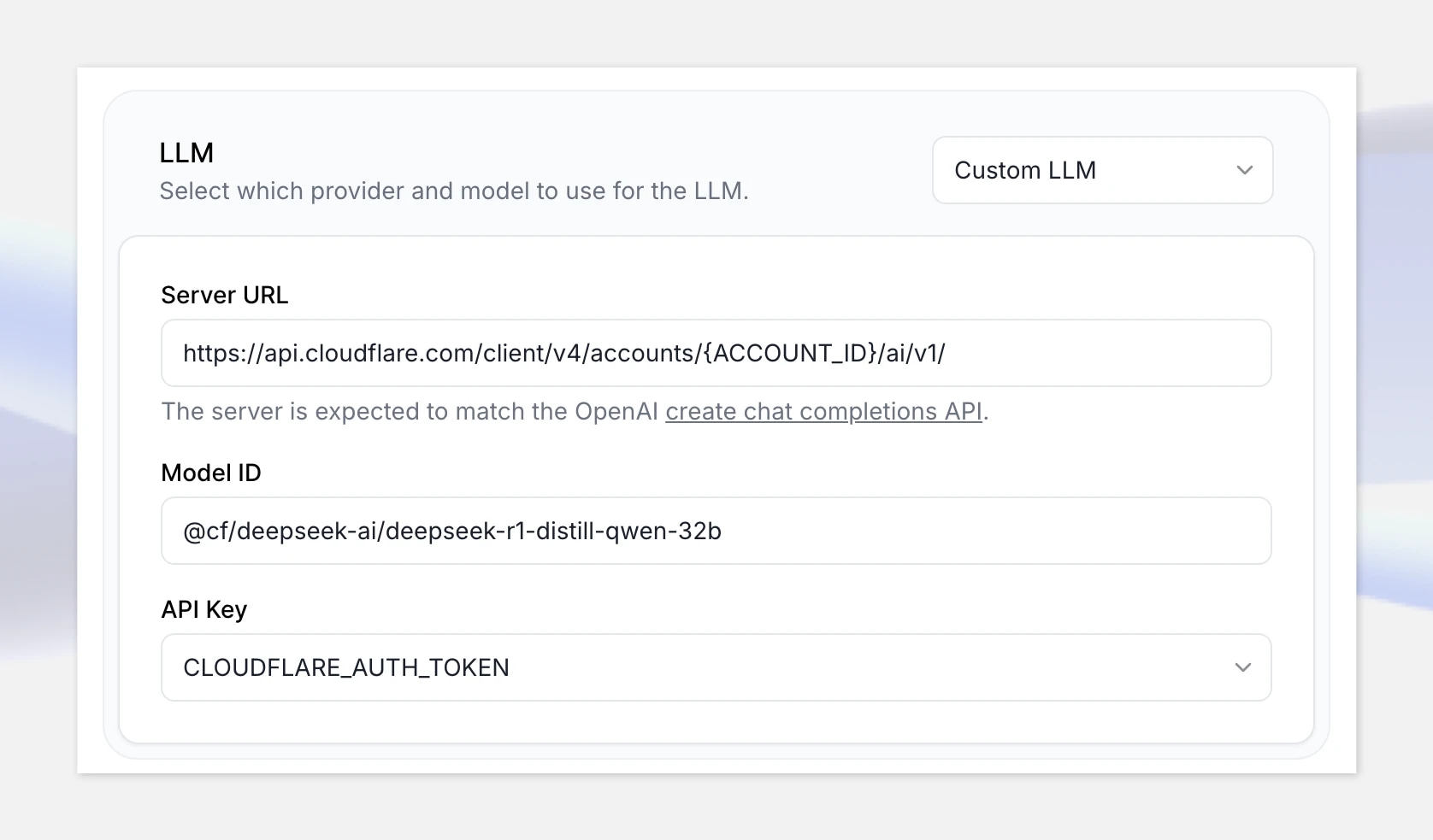

Nästa, under LLM, välj alternativet Custom LLM, och ange Cloudflare Workers AI OpenAI-kompatibla API slutpunkt: https://api.cloudflare.com/client/v4/accounts/{ACCOUNT_ID}/ai/v1

Se till att ersätta “{ACCOUNT_ID}” i URL:en med ditt konto-ID som visas i Cloudflare.

Lägg till modell-ID: @cf/deepseek-ai/deepseek-r1-distill-qwen-32b

Välj slutligen din hemlighet som du just skapade.

Testa det

Bra, nu när allt är inställt, låt oss klicka på “Test AI agent” och testa det med följande matematikproblem:

“Två tåg passerar varandra öst/väst med hastigheter på 65mph och det andra 85mph. Hur länge tills de är 330 miles ifrån varandra?”

Obs: om du inte har en betalningsmetod inställd, kommer Cloudflare Workers AI API att strypas och du kan uppleva längre svarstider. Se till att ställa in ditt faktureringskonto innan du går till produktion. Detta kanske inte är ett problem med andra hostingplattformar.

Slutsats

Att bygga realtidskonversations-AI-agenter med ElevenLabs Conversational AI-plattform gör att du snabbt kan reagera på nya modeller som släpps genom att låta dig koppla in anpassade LLMs via vilken OpenAI-kompatibel API-leverantör som helst.

Så länge modellen du vill använda är OpenAI-kompatibel och stödjer funktionsanrop kan du integrera den med en realtidsröstagent. Detta kan inkludera modeller du har finjusterat på anpassade dataset. Du kan också använda vilken röst som helst från ElevenLabs bibliotek — eller din egen röst om du har skapat en klon av din egen röst.

Utforska artiklar av ElevenLabs-teamet

.webp&w=3840&q=95)

.webp&w=3840&q=95)

Bygga konversations-AI-applikationer med avancerade text-till-tal-API:er

Förbättra konversationsbaserade AI-applikationer med naturlig dialog.