Powiedz to po swojemu i usłysz to w zupełnie innym głosie, mając pełną kontrolę nad efektem. Wychwytuj szepty, śmiech, akcenty i subtelne emocje.

Przedstawiamy speech to speech

Powiedz to, jak chcesz, i zmień swój głos na inną postać z pełną kontrolą nad emocjami, tempem i sposobem przekazu

Dodaliśmy Speech to Speech (STS) do Speech Synthesis. STS to narzędzie do konwersji głosu, które pozwala zmienić nagranie jednego głosu tak, by brzmiało jak inny. Daje ci kontrolę nad emocjami, tonem i wymową poza tym, co możliwe z TTS samymi podpowiedziami. Użyj tego, by wydobyć więcej emocji z konkretnego głosu lub jako odniesienie 'powiedz to, jak chcesz'.

W innych aktualizacjach zmieniamy nasze gotowe głosy. Wprowadziliśmy też wiele ulepszeń w Studio, w tym normalizację, słownik wymowy i więcej opcji personalizacji.

Mowa-mowa

STS bierze treść i styl mowy z twojego nagrania i zmienia głos. Pomyśl o STS jako przydatnym głównie do dwóch rzeczy.

Jednym z zastosowań jest wydobycie więcej emocji z konkretnego gotowego głosu. Prześlij/ nagraj bardzo ekspresyjną mowę, a STS odtworzy emocje i intonację w innym głosie. Ponieważ nie wszystkie głosy mogą wyrażać silne emocje tylko za pomocą podpowiedzi TTS, teraz możesz sprawić, że profesjonalny narrator lub postać z książki dla dzieci będą bardziej ekspresyjni dzięki twojemu własnemu głosowi.

Innym zastosowaniem STS jest dostarczenie 'referencji' dla sposobu mówienia. Chociaż nasze TTS zazwyczaj dobrze trafia w intonację, czasem możesz chcieć ją dopracować. Tutaj STS pozwala ci pokazać, jak zintonować konkretną frazę, a potem wybrany głos powie to w ten sposób. Ta funkcjonalność stanie się bardziej użyteczna i uproszczona, gdy zintegrowujemy STS bezpośrednio ze Studio, ale naszym celem jest radykalne poprawienie twojej zdolności do precyzyjnej edycji wyników.

Obejrzyj wideo stworzone przez jednego z naszych członków społeczności:

Badania

Aby przekształcić mowę źródłową w mowę docelową, musimy wyrazić treść mowy źródłowej z cechami mowy docelowej. Dobrym porównaniem są aplikacje do zamiany twarzy, które pozwalają zmieszać twoją twarz z czyjąś inną, tworząc obraz obu jako jednej.

Sposobem na to jest wzięcie obrazu twarzy i mapowanie jej cech. Markery w poniższym przykładzie robią właśnie to: są granicami, w których zostanie odwzorowana inna twarz.

Sztuczka w konwersji głosu polega na odwzorowaniu treści mowy źródłowej za pomocą fonemów mowy docelowej. Ale jest tu kompromis, podobnie jak w przykładzie zamiany twarzy: im więcej markerów używasz do mapowania cech jednej twarzy, tym więcej ograniczeń nakładasz na twarz, którą mapujesz wewnątrz nich. Mniej markerów oznacza mniej ograniczeń.

To samo dotyczy konwersji głosu. Im więcej preferencji dajemy mowie docelowej, tym bardziej ryzykujemy, że nie będziemy zsynchronizowani z mową źródłową. Ale jeśli nie damy jej wystarczającej preferencji, ryzykujemy utratę tego, co czyni tę mowę charakterystyczną. Na przykład, jeśli mielibyśmy odwzorować nagranie kogoś krzyczącego ze złością w szeptanym głosie, mielibyśmy problem. Daj zbyt dużo preferencji emocjom mowy źródłowej, a ceną, jaką płacimy, jest utrata wrażenia, że to szeptany głos mówi. Zbyt duży nacisk na wzorzec szeptanej mowy i tracimy ładunek emocjonalny mowy źródłowej.

Produkt i ostatnie aktualizacje

Zmiany w gotowych głosach

Wprowadzimy zmiany w domyślnych głosach dostępnych w Speech Synthesis w tym tygodniu. Przestaniemy wspierać kilka głosów, ale zastąpimy je nowymi. Planujemy dodać ponad 20 w nadchodzących tygodniach.

Zaczniemy także dostarczać informacje w interfejsie użytkownika o tym, jak długo każdy głos będzie dostępny. Na koniec, przez cały grudzień będziemy pracować nad odświeżeniem funkcji udostępniania głosów i rekompensaty za ich użycie, aby jeszcze bardziej zwiększyć różnorodność głosów. Więcej szczegółów wkrótce.

Eleven Turbo v2 i format uLaw 8khz

Nasz model Turbo zawiera miesiące badań naszego zespołu technologicznego. Jest zaprojektowany do interakcji w czasie rzeczywistym, ale można go używać do wszystkiego, co chcesz. Posiada także standardowy format (m)uLaw 8kHz dla systemów IVR.

Normalizacja i metadane w Studio

Teraz możesz przestrzegać wytycznych dotyczących przesyłania audiobooków zgodnych z branżowymi standardami w Studio. Obejmuje to dostosowanie wzmocnienia i zastosowanie kompresji dynamicznej. Dodatkowo, teraz istnieje opcja osadzania metadanych w twoim Studio (ISBN, autor i tytuł).

Dziennik wymowy

Dodanie Słownika Wymowy było jedną z naszych najczęściej zgłaszanych funkcji. W zeszłym miesiącu wdrożyliśmy dodanie tagów SSML do określania wymowy za pomocą słowników IPA i CMU dla naszych modeli angielskich. Teraz udostępniliśmy wsparcie dla słownika wymowy w interfejsie Studio, pozwalając na przesłanie pliku określającego wymowę za pomocą IPA, CMU lub zamienników słów. Pliki słownika są przesyłane przy użyciu standardu branżowego i otwartego formatu .PLS format pliku leksykonu.

Na razie IPA i CMU są wspierane przez Turbo V2 English, a zamienniki słów (aliasy) są wspierane przez wszystkie modele i języki. Pełna dokumentacja jest dostępna tutaj.

Jeśli masz jakieś uwagi, nie wahaj się skontaktować z nami na Discordzie!

Powiedz to po swojemu i usłysz to w zupełnie innym głosie, mając pełną kontrolę nad efektem. Wychwytuj szepty, śmiech, akcenty i subtelne emocje.

Przeglądaj artykuły zespołu ElevenLabs

ElevenLabs and Deutsche Telekom unveil the world’s first network-integrated AI call assistant

Bringing real-time AI assistance and translation to any phone call, on any device.

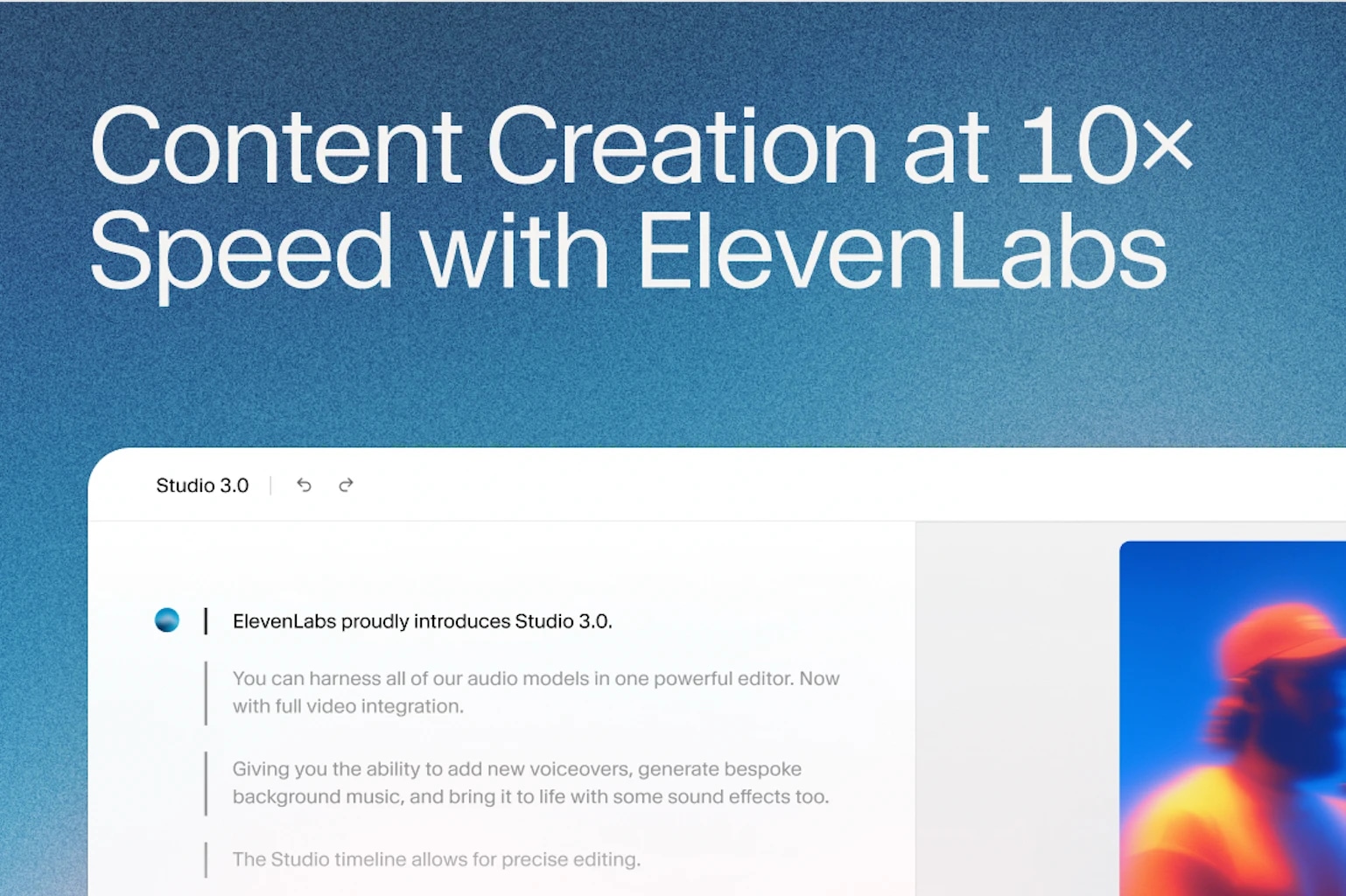

Webinar Recap: Content Creation at 10x Speed

AI is changing how marketing teams produce content.