Eleven v3 Audio Tags: Wyrażanie emocji w mowie

Dodaj emocjonalne niuanse do mowy AI dzięki Eleven v3 Audio Tags. Kontroluj napięcie, ciepło, wahanie i ulgę, tworząc dynamiczne i ludzkie treści.

Emocje kształtują naszą mowę — nie tylko to, co mówimy, ale jak to mówimy. Dzięki Eleven v3 Audio Tags możesz teraz wzbogacić mowę AI o emocjonalne niuanse, dodając napięcie, ciepło, wahanie czy ulgę do każdej kwestii.

To sprawia, że mówione treści są bardziej przystępne, dynamiczne i ludzkie.

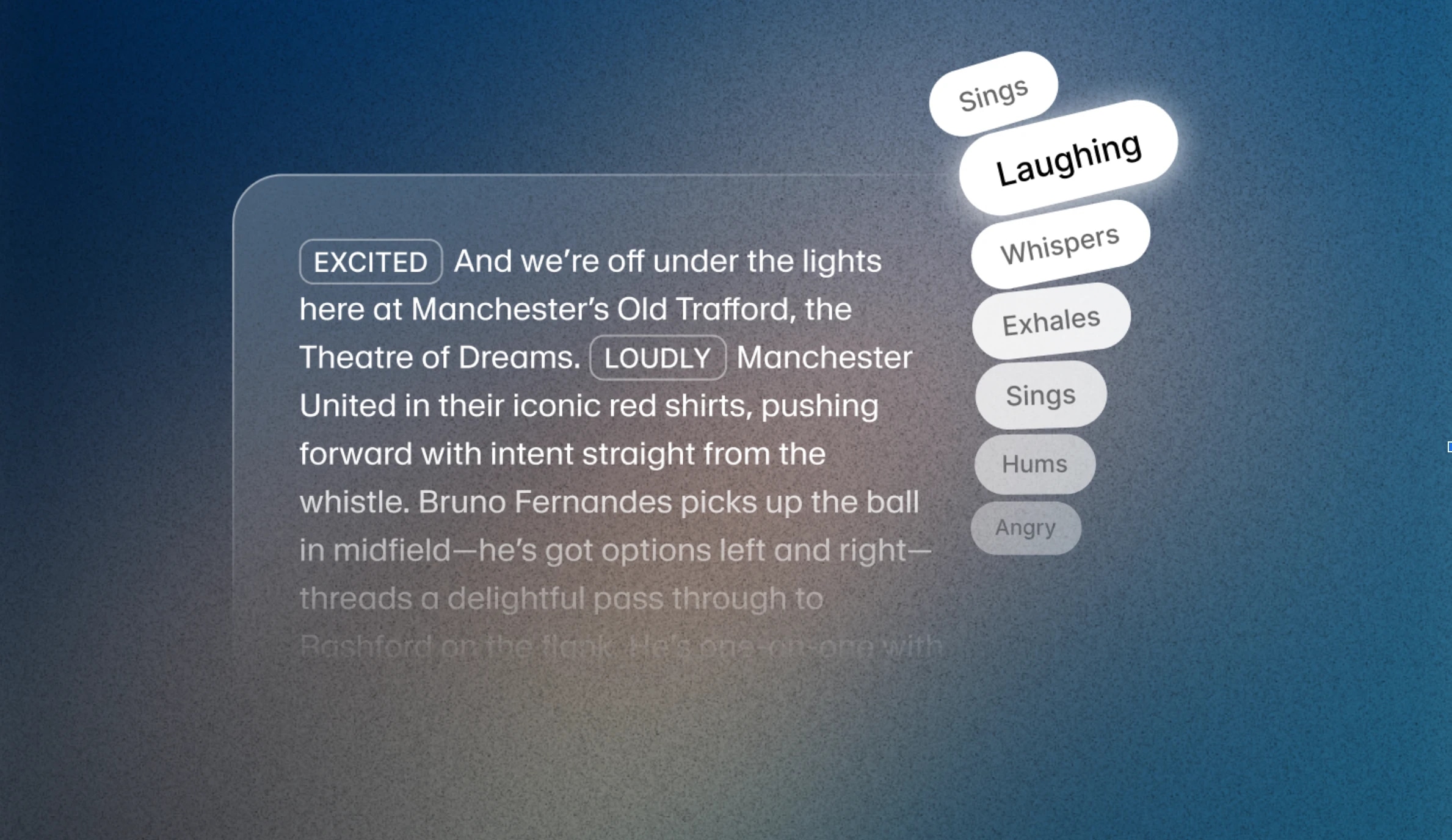

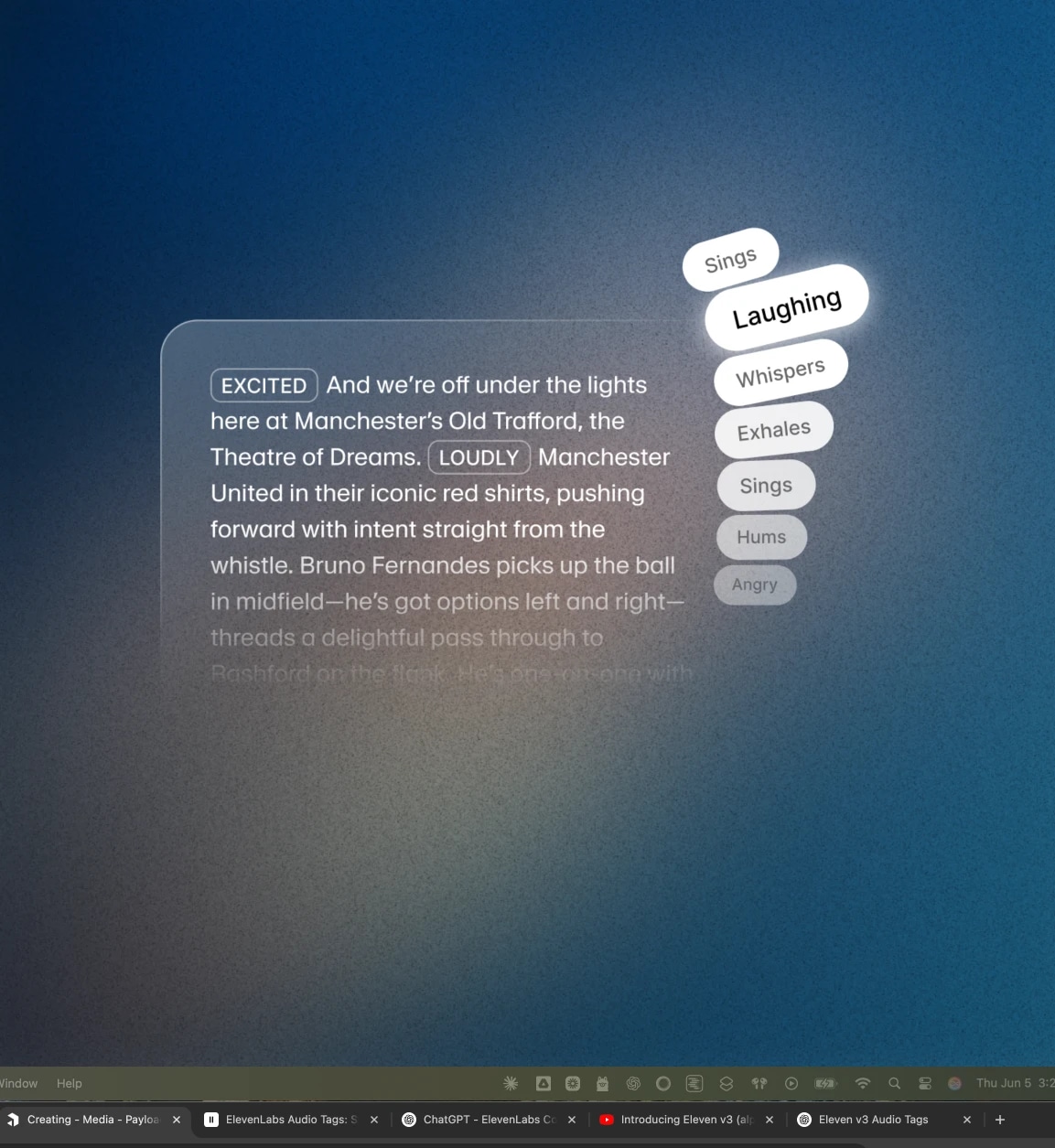

Używając nawiasów jak [westchnienie], [podekscytowany] czy [zmęczony], możesz kierować emocjonalnym przekazem modelu głosu — z chwili na chwilę.

Czym jest kontekst emocjonalny w mowie AI?

Kontekst emocjonalny odnosi się do zdolności modelu do wyrażania uczuć pasujących do sytuacji. To sposób, w jaki postać reaguje na wydarzenia — czy to zachwyt, strach, radość, czy zmęczenie.

Dzięki Audio Tags możesz kierować stanem emocjonalnym kwestii w trakcie jej wypowiadania. Na przykład: „[smutny] Nie mogłem spać tej nocy. Powietrze było zbyt nieruchome, a światło księżyca wciąż przesuwało się przez żaluzje, jakby chciało mi coś powiedzieć. [cicho] I nagle, wtedy to zobaczyłem.”

To nie tylko aktorstwo głosowe — to występ świadomy kontekstu.

Od zmian tonu po emocjonalne akcenty

W prawdziwej mowie uczucia się zmieniają. Eleven v3 uchwyca to dzięki warstwowym tagom. Na przykład: „[zmęczony] Pracuję już 14 godzin bez przerwy. [westchnienie] Już nawet nie czuję rąk. [nerwowo] Jesteś pewien, że to zadziała? [przełyka] Dobra… idziemy.”

Nawet subtelne zmiany jak [lekki śmiech] czy [westchnienie ulgi] mogą diametralnie zmienić znaczenie zdania.

Popularne tagi dla kontekstu emocjonalnego

Oto kilka często używanych tagów do kierowania emocjonalnym występem:

- Stany emocjonalne: [podekscytowany], [nerwowy], [sfrustrowany], [smutny], [spokojny]

- Reakcje: [westchnienie], [śmiech], [przełyka], [dyszy], [szept]

- Akcenty poznawcze: [pauza], [wahanie], [jąkanie], [ton rezygnacji]

- Wskazówki tonalne: [radosny], [monotonny], [bez emocji], [zabawny]

Można je łączyć lub sekwencjonować dla bogatszych łuków emocjonalnych: [wahający się] Ja... Ja nie chciałem tego powiedzieć. [żałujący] To po prostu wyszło.

Emocjonalne opowiadanie na twoje zawołanie

W narracji, dialogach postaci czy w feedbacku UI, tagi emocjonalne pomagają kontrolować tempo, ton i atmosferę. Głos, który śmieje się z własnego żartu lub szepcze w napiętej scenie, robi więcej niż tylko recytuje tekst — angażuje.

Na przykład, ta kwestia z dema postaci: [śmiejąc się] Brooo—BROOO nie wiem DLACZEGO to mnie rozbawiło!! [śmieje się mocniej] Kurczak nie miał ŻADNEJ FABUŁY, żadnego zwrotu, tylko czystą determinację!

Tagi takie jak te pozwalają aktorom głosowym, projektantom i deweloperom tworzyć bardziej angażujące doświadczenia — bez ponownego nagrywania, edytowania czy przepisywania.

Nie tylko ekspresja — połączenie

Eleven v3 rozumie kontekst emocjonalny na poziomie strukturalnym. Oznacza to, że może dostarczać długie występy, które naturalnie się rozwijają, odzwierciedlają wewnętrzne stany i zmieniają ton w odpowiedzi na historię lub interakcję — wszystko z poziomu scenariusza.

Dla twórców to już nie tylko kwestia dostarczania linii. To kwestia kierowania emocjami.

Wybór odpowiedniego głosu

Profesjonalne Klony Głosowe (PVC) nie są jeszcze w pełni zoptymalizowane dla Eleven v3, co może skutkować niższą jakością klonów w porównaniu do wcześniejszych modeli. W tej fazie podglądu badawczego najlepiej znaleźć Instant Voice Clone (IVC) lub zaprojektowany głos do projektu, jeśli chcesz używać funkcji v3. Optymalizacja PVC dla v3 jest wkrótce planowana.

Przeglądaj artykuły zespołu ElevenLabs

Introducing Experiments in ElevenAgents

The most data-driven way to improve real-world agent performance.