ElevenLabs and Deutsche Telekom unveil the world’s first network-integrated AI call assistant

Bringing real-time AI assistance and translation to any phone call, on any device.

Odpowiednie przygotowanie dużego modelu językowego do użycia w systemie Conversational AI może zrobić ogromną różnicę.

Dziś LLM stał się sercem systemów conversational AI. Konkretnie, LLM-y umożliwiają conversational AI — pierwotnie zbudowane wokół rozbudowanych drzew telefonicznych — oferowanie dynamicznych funkcji i zapewnianie doświadczeń zbliżonych do ludzkich. Jednak LLM-y nie są magicznym rozwiązaniem; wymagają specjalistycznego przygotowania, ponieważ domyślnie nie są dostosowane do ludzkiej mowy.

Deweloperzy często popełniają błąd, stosując te same metody, które były używane do szkolenia ludzkich pracowników. Ta strategia, choć brzmi prosto, rzadko przynosi owoce. LLM-y mają inne założenia niż typowi ludzie, a ich domyślny ton i zakres nie sprzyjają interakcjom werbalnym.

Dziś odkryjemy, co wiemy o tym, jak przygotować LLM-y do budowy udanych systemów conversational AI. Możesz także przeczytać bardziej szczegółowy i techniczny przewodnik na ten temat w dokumentacji dewelopera ElevenLabs.

Przed LLM-ami systemy conversational AI wykorzystywały rozbudowane drzewa logiczne, przez które przechodziły zapytania na podstawie werbalnych danych wejściowych. To rozwiązanie było popularne w numerach obsługi klienta (np. infolinie lotnicze) i systemach płatności (np. telefoniczne usługi kart kredytowych).

Te starsze systemy były powolne, robotyczne i pozwalały na bardzo ograniczone ludzkie dane wejściowe. Jest duża szansa, że sam tego doświadczyłeś, krzycząc „TAK” do telefonu, aby odpowiedzieć na pytanie. To słabe doświadczenie sprawiło, że większość użytkowników próbowała „pokonać system”, aby wymusić rozmowę z żywym agentem.

Jednak te drzewa telefoniczne miały jedną zaletę — były ograniczone. Istniało tylko tyle ścieżek, które mogła przyjąć rozmowa, a deweloperzy mogli łatwo wprowadzić zabezpieczenia, aby ignorować niedozwolone dane wejściowe. To ograniczenie podkreśla zalety i wady LLM-ów: znacznie wykraczają poza ograniczoną naturę drzew telefonicznych, ale są również nieprzewidywalne, otwierając puszkę Pandory z pułapkami — takimi jak składanie niemożliwych obietnic, złość na klientów czy naruszanie danych wrażliwych.

Jeśli LLM-y są po prostu szkolone na podręczniku pierwotnie zaprojektowanym dla ludzi, osiągną przeciętne wyniki z powodu kilku podstawowych luk. Zrozumienie tych luk pomoże ci zaprojektować odpowiednie przygotowanie:

LLM-y są szkolone poprzez uczenie ze wzmocnieniem, gdzie opinie ludzi zachęcają LLM-y do zwracania uporządkowanych odpowiedzi. Konkretnie, odpowiedzi LLM-ów mają tendencję do bycia rozwlekłymi i wypełnionymi punktami, blokami wyróżnień i nagłówkami.

Jednak w kontekście conversational AI, LLM-y muszą naśladować zwięzły i uproszczony charakter interakcji werbalnych.

LLM-y mają tendencję do wypełniania nieznanych informacji wiedzą domniemaną zamiast zadawania pytań. Może to prowadzić do błędnych założeń, które wprowadzą użytkowników w błąd — lub do kosztownych pomyłek (np. obiecane zwroty). Później zobaczymy, jak możemy użyć bazy wiedzy i zabezpieczeń, aby lepiej ugruntować LLM-y, zapobiegając składaniu błędnych obietnic i wykonywaniu niedozwolonych działań.

LLM-y mogą programowo wywoływać funkcje, zbierając i zapisując dane w imieniu ludzi. Choć jest to zazwyczaj jedna z największych zalet LLM-ów, oznacza to również, że wcześniejsze instrukcje szkoleniowe, które pozwalały agentom telefonicznym „zyskać czas” podczas wykonywania zadań, nie są już potrzebne. Jednak wywołania funkcji również nie są natychmiastowe, co oznacza, że LLM-y muszą dokładnie uprzedzać użytkownika, gdy spodziewane jest opóźnienie (np. „daj mi chwilę na zbadanie twojej sprawy”).

LLM-y są dość skuteczne w dostosowywaniu tonu do stylu. LLM może być skonfigurowany, aby brzmieć przyjaźnie, humorystycznie, zwięźle, formalnie lub w kombinacji stylów. To ważny element przy przygotowywaniu LLM-a.

Na przykład, deweloperzy aplikacji conversational AI do obsługi klienta, zaprojektowanej do wspierania niezadowolonych klientów linii lotniczych, mogą użyć takiego przygotowania:

Nicole

LLM-y muszą otrzymać wyraźne instrukcje, jak odpowiadać. Aby upewnić się, że nie dodają zbędnego tekstu, LLM-y powinny otrzymać strukturę, która obejmuje odpowiedź przekazywaną użytkownikowi.

Na przykład, LLM-y mogą być przygotowane do:

Ta struktura zachęca LLM do udzielania odpowiedzi zaprojektowanej do odczytania na głos.

Jednak LLM-y czasami mogą potknąć się na rzeczach, które mogą nie różnić się intuicyjnie od treści pisemnych. Częstym przykładem są liczby — LLM może wydrukować kod pocztowy jak 10023, co spowoduje, że model zamiany tekstu na mowę powie „dziesięć tysięcy dwadzieścia trzy”. Zamiast tego, LLM powinien być wyraźnie przygotowany do mówienia liczb osobno, wskazując, co oznaczają, np. „Kod pocztowy to jeden zero zero dwa trzy.”

Temperatura to kluczowy parametr przy konfigurowaniu LLM-ów do conversational AI. Niższa temperatura generuje bardziej skoncentrowane, deterministyczne odpowiedzi idealne do rozmów zorientowanych na zadania, podczas gdy wyższe temperatury tworzą bardziej kreatywne, zróżnicowane odpowiedzi.

Niska temperatura jest idealna dla systemów conversational AI, które mogą preferować spójne odpowiedzi (np. linia obsługi klienta do zwrotów). Tymczasem dla systemów, które chcą zapewnić bardziej angażujące i realistyczne wrażenia klientom (np. cyfrowy trener), wyższa temperatura jest lepsza:

Dla systemów conversational AI, które korzystają z większych zasobów wiedzy, baza wiedzy powinna być wykorzystywana do minimalizacji długości przygotowania. W produkcji jest to zazwyczaj realizowane za pomocą bazy danych wektorowych (takiej jak Pinecone lub Elasticsearch) lub bezpośredniego magazynu wiedzy dostawcy LLM.

Ogólnie rzecz biorąc, bazy wiedzy są niezbędne do ugruntowania odpowiedzi LLM w faktach i zatwierdzonych informacjach. Podczas budowy systemu conversational AI powinieneś dostarczyć LLM-owi kompleksową bazę wiedzy zawierającą dokładne, aktualne informacje o produktach, usługach, politykach i procedurach. Zapobiega to halucynacjom LLM-a lub wymyślaniu informacji, jednocześnie zachęcając do spójnych i niezawodnych odpowiedzi w rozmowach.

Ponieważ LLM-y często wywołują funkcje w imieniu użytkownika, muszą również wiedzieć, jakie dane wejściowe są wyraźnie potrzebne. Na przykład, jeśli zadaniem LLM-a jest pomoc użytkownikowi w umówieniu wizyty na strzyżenie, muszą upewnić się, że mają:

Naive wdrożenie może skutkować tym, że LLM poprosi o wszystkie informacje w jednej turze rozmowy. To jest całkowicie w porządku jako tekst, ale w rozmowie może być przytłaczające:

Ponieważ informacje są zwykle zbierane stopniowo poprzez rozmowę, LLM-y muszą być zachęcane do zbierania tych informacji w sposób fragmentaryczny. Rezultatem jest znacznie bardziej konwersacyjne doświadczenie:

Podczas budowy rozproszonych systemów zakładasz, że twój serwer w pewnym momencie się zawiesi. Podobnie, podczas budowy systemów AI, powinieneś założyć, że twój LLM popełni błąd w pewnym momencie. Aby zminimalizować skutki tego błędu, powinieneś dać tym systemom najniższe niezbędne uprawnienia do wykonania zadania. Poniżej kilka przykładów, jak to zrobić:

Podczas tworzenia systemów agentów głosowych AI które podejmują działania za pomocą narzędzi, warto wbudować proces walidacji i weryfikacji, aby upewnić się, że zbierasz poprawne informacje od użytkowników. Dziś, gdy rozmawiasz z ludzkim agentem, powtarzają oni wszelkie krytyczne informacje, które podajesz, aby zweryfikować, że usłyszeli je poprawnie i że klient nie przejęzyczył się. LLM-y mogą skorzystać z podobnego poziomu sprawdzania błędów:

Dla walidacji, wszelkie informacje otrzymane od klienta powinny być sprawdzane pod kątem typowej struktury tych informacji. Czy numer telefonu ma odpowiednią liczbę cyfr? Czy wiek podany przez klienta mieści się w rozsądnym zakresie? Czy klient podał prawidłowy adres?

W zależności od twojego przypadku użycia, możesz zweryfikować wszystkie otrzymane informacje lub tylko te, które nie przeszły weryfikacji. Dodatkowo, możesz zdecydować się na weryfikację każdej informacji w miarę jej przychodzenia lub weryfikację wszystkiego na końcu.

Skuteczne przygotowanie systemu agenta AI polega na zrównoważeniu odpowiednich konfiguracji i zabezpieczeń, aby stworzyć doświadczenie, które naśladuje rozmowę z człowiekiem z większą efektywnością. Proces nie jest tak trywialny, jak użycie starych materiałów szkoleniowych do przygotowania LLM-a; zamiast tego, LLM-y to narzędzia, które wymagają specjalistycznej struktury i strategii, aby tworzyć przewidywalne, skuteczne wyniki.

Bringing real-time AI assistance and translation to any phone call, on any device.

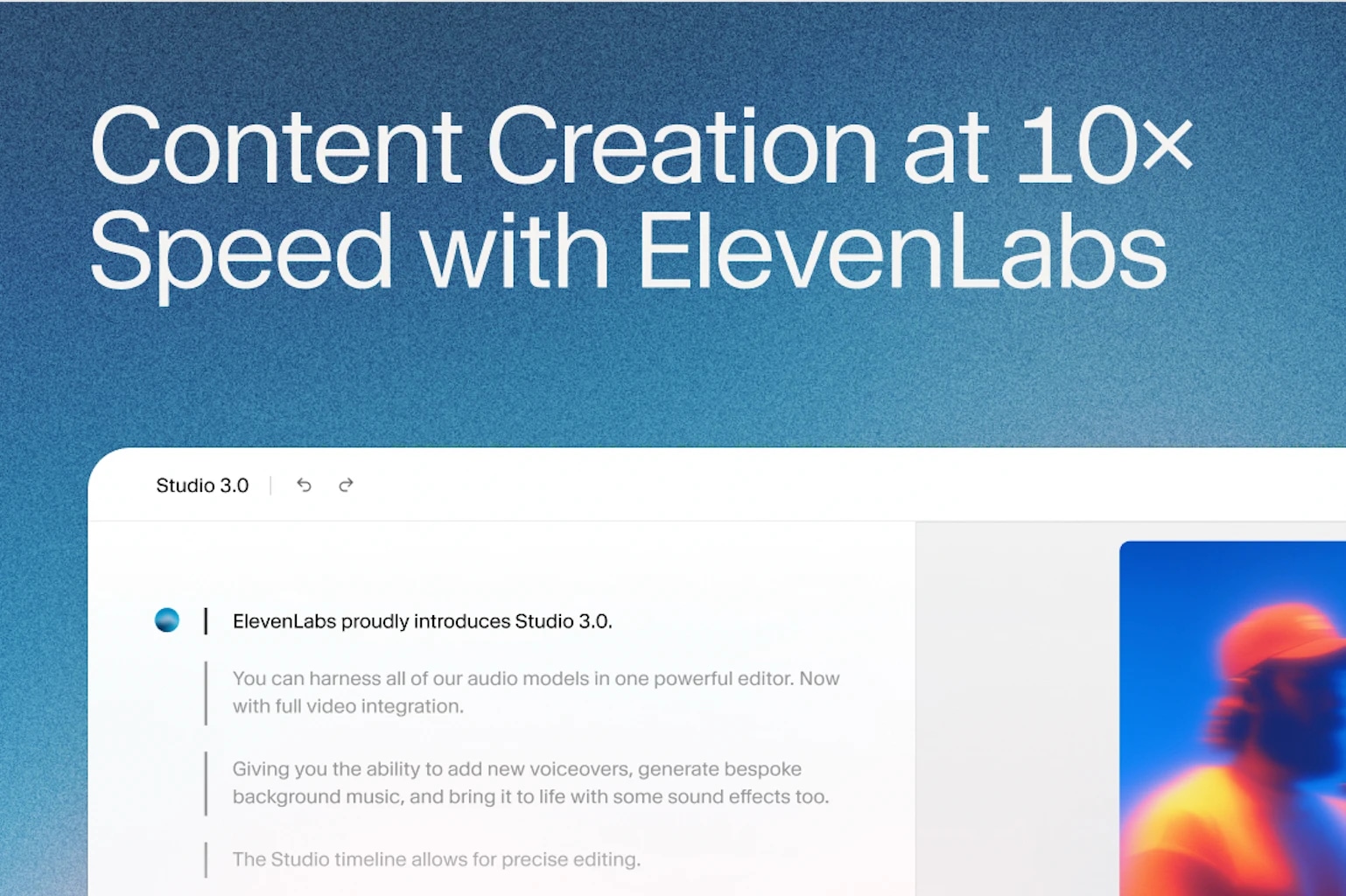

AI is changing how marketing teams produce content.